rCore Series Notebook

建设中

清华大学操作系统2022-课程笔记,以及以一些相关资源工具的学习补充。

关于 rCore 和清华大学操作系统课程

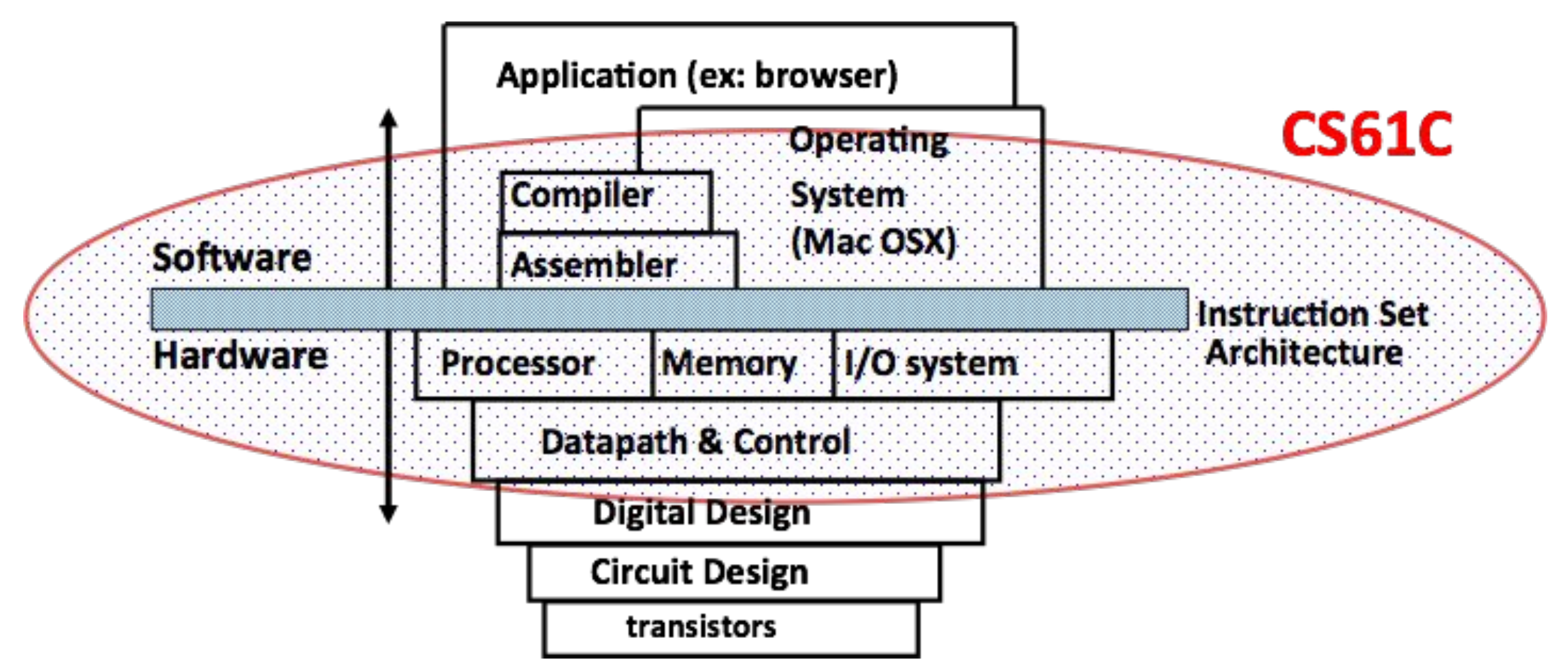

rCore 是清华大学计算机系开发的一个开源操作系统内核学习项目,基于 Rust 语言,旨在让学生从底层理解操作系统的结构与设计。该项目伴随清华大学的操作系统课程,内容覆盖了从基本操作系统理论到实践的各个方面。

课程目录

-

第零章:实验环境配置

-

第一章:应用程序与基本执行环境

-

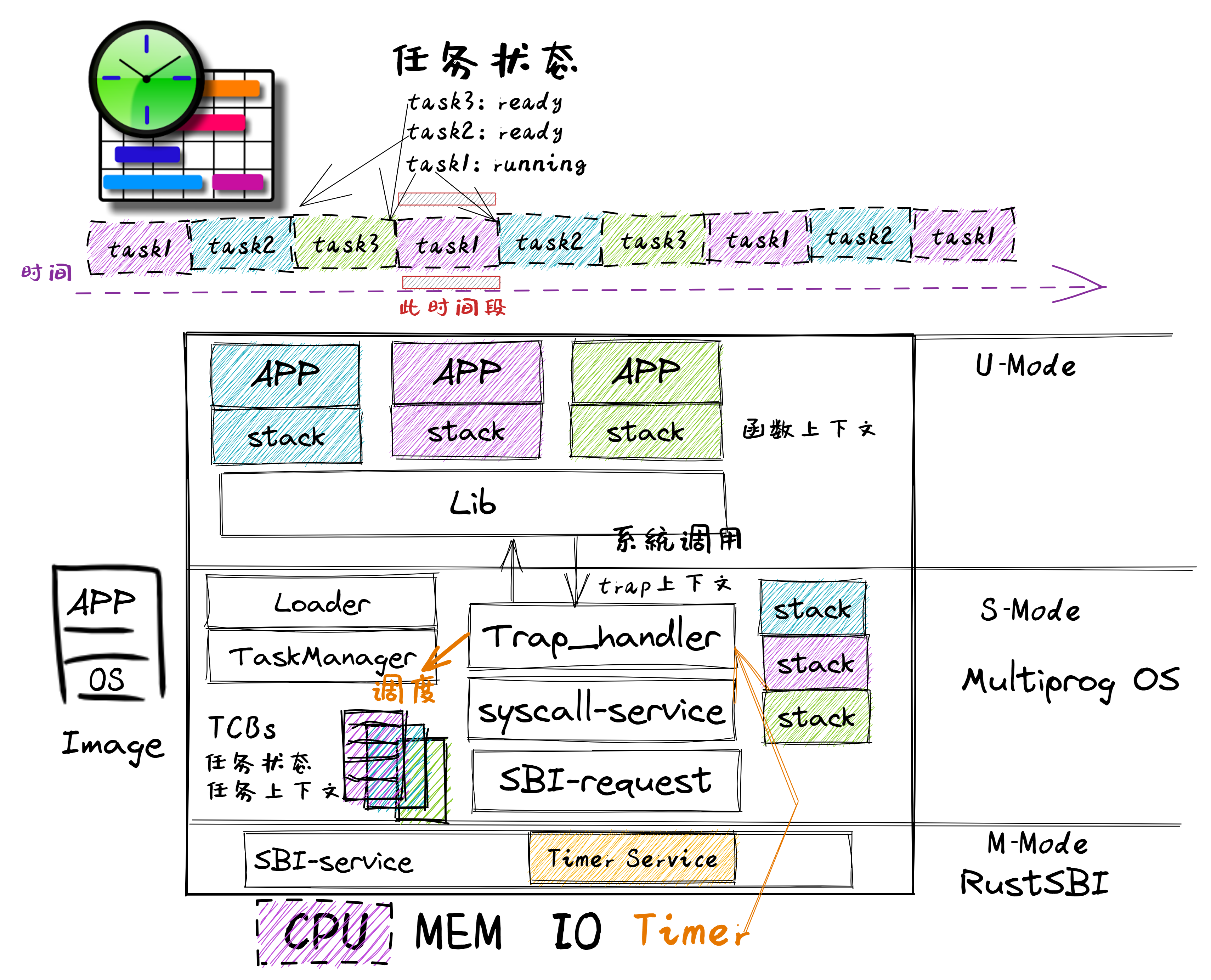

第三章:多道程序与分时多任务

-

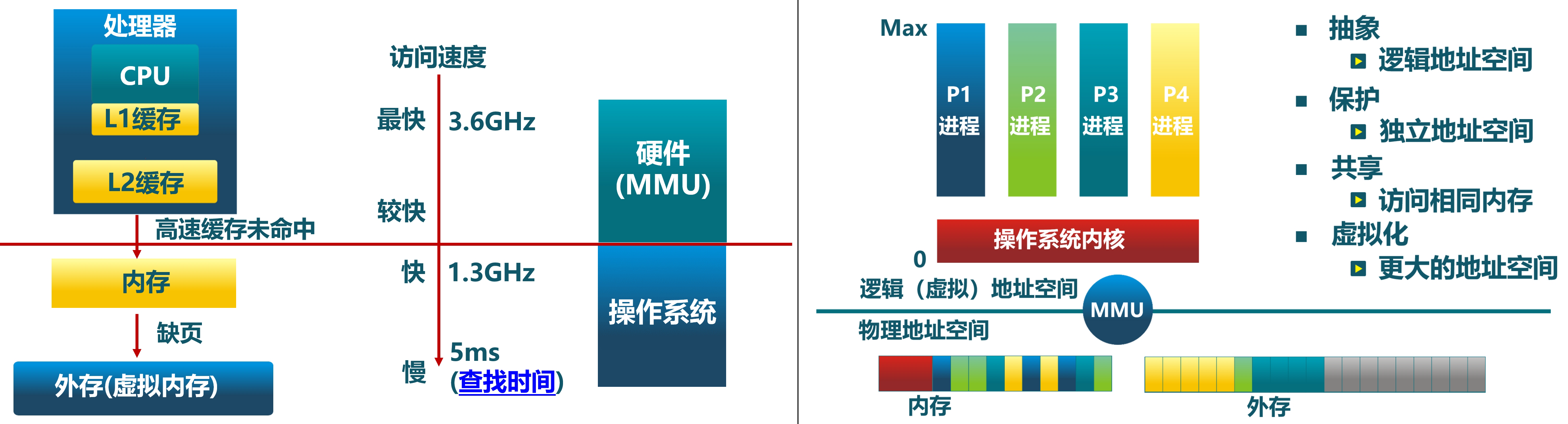

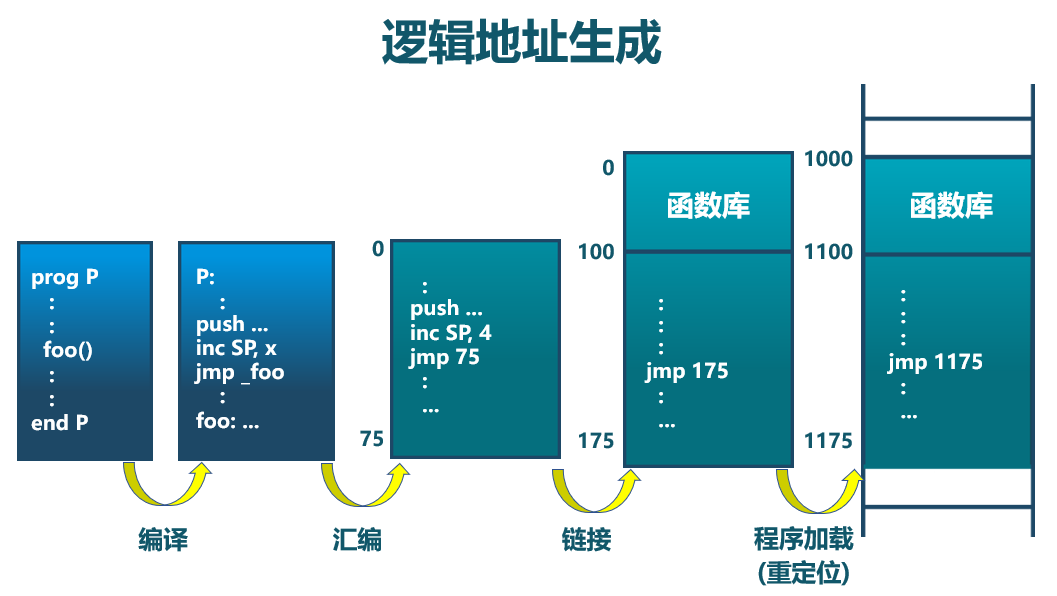

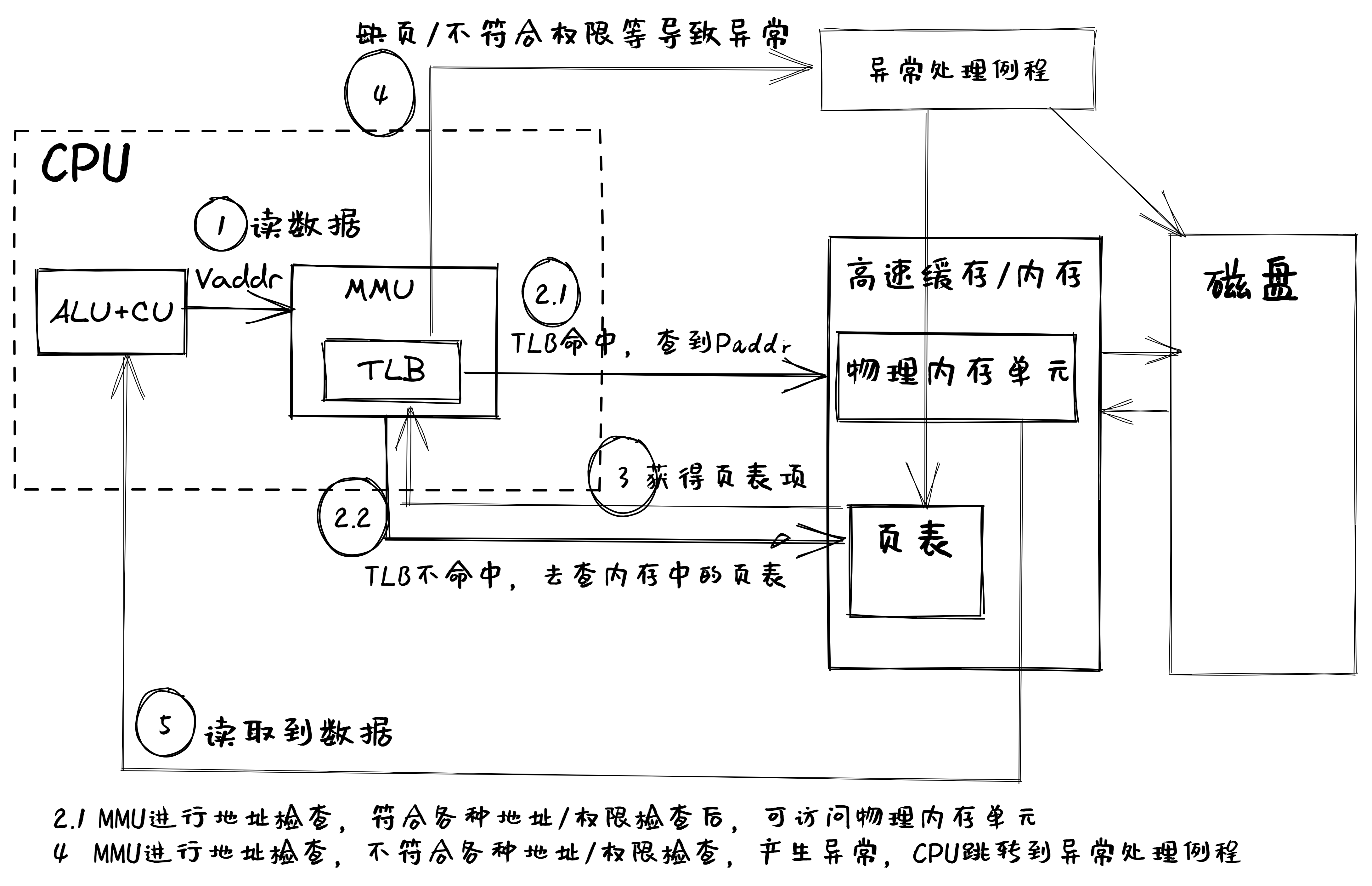

第四章:地址空间

-

第五章:进程及进程管理

-

第六章:文件系统与 I/O 重定向

-

第七章:进程间通信

-

第八章:并发

更多资源

在学习过程中,我将分享一些翻译的资料与额外的资源,帮助你更好地理解 rCore 和操作系统课程中的内容。如果你对某些部分有疑问或者需要更详细的补充,可以随时在下面评论。

0. 开始前的阅读

An Introduction to RISC-V Boot Flow

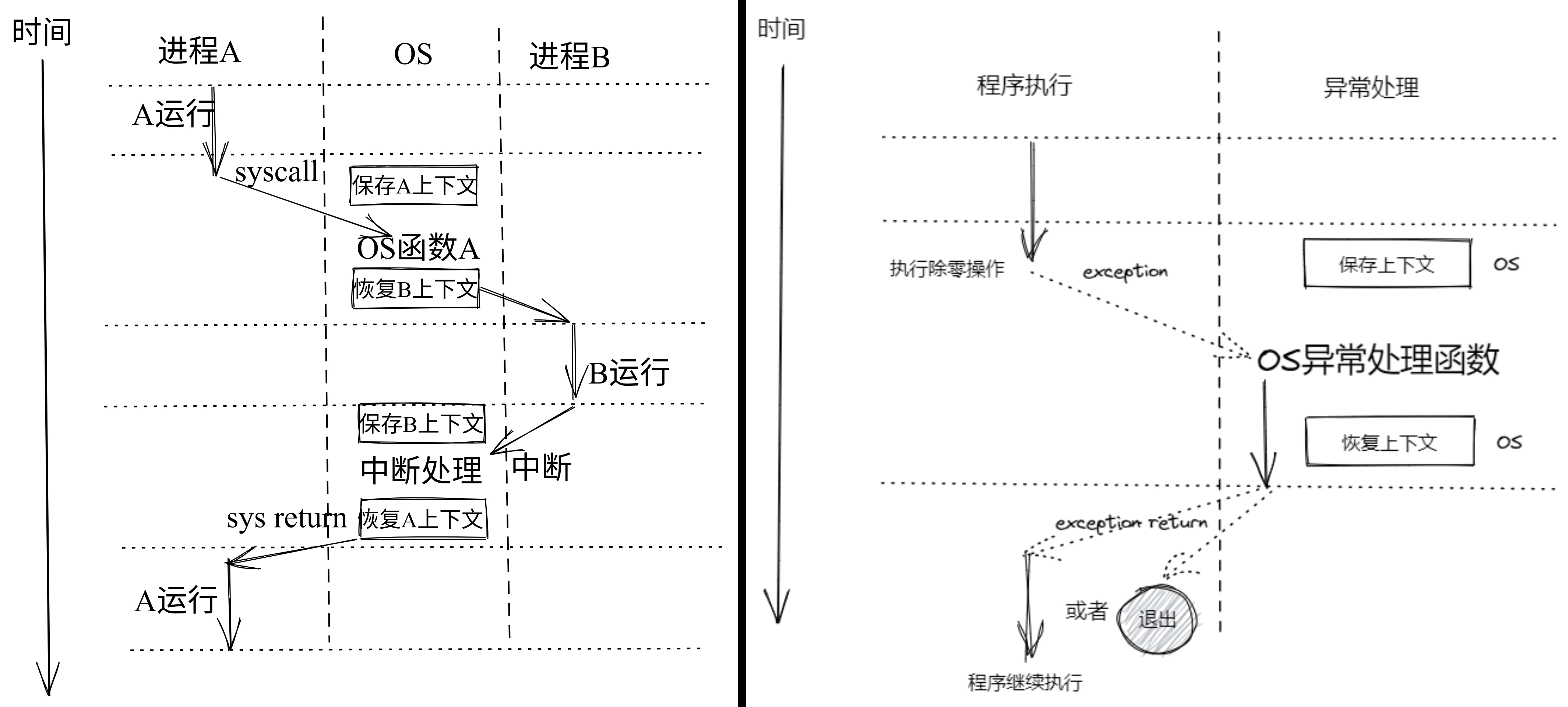

本讲座由Atish Patra和Anup Patel主讲,主要讲解了RISC-V体系结构的启动流程。RISC-V是一种开源指令集架构,其灵活性和模块化设计使其在嵌入式系统和高性能计算领域日益受到关注。此文档针对RISC-V启动流程,介绍了它在嵌入式系统中的应用、与传统体系的对比、当前发展状态,以及未来可能的工作方向。

原始内容来源:

幻灯片标题:An Introduction to RISC-V Boot Flow

原作者:Atish Patra, Anup Patel

出处:Western Digital

原始发布日期:2019年12月19日

版权声明:该幻灯片及其内容的版权归Western Digital公司所有。翻译与讲解仅供学习和参考,更多详细信息请参见原文链接。

本文是2019年12月的一个讲座内容,虽然其中的部分技术进展和版本信息已经有些过时,但本文的学习重点在于了解RISC-V启动流程(RISC-V Boot Flow)的基本原理和结构。随着RISC-V生态系统的快速发展,某些工具和固件可能已经更新,因此不必对具体的版本和实现细节深究。阅读本文的目的在于掌握启动流程的整体框架和概念,了解RISC-V如何从上电到操作系统启动的过程,这对未来进一步研究和开发仍然有重要的参考价值。

简单看看即可,重点在于理解基本原理。

Outline

本次介绍的内容包括以下几个方面:

- Common embedded boot flow:介绍常见的嵌入式系统启动流程,帮助读者了解嵌入式系统在启动过程中涉及的关键步骤和组件。

- Current RISC-V boot flow:对RISC-V目前的启动流程进行详细解释,特别是在RISC-V架构上如何实现启动流程,区别于其他常见架构的启动过程。

- OpenSBI Project:深入讲解OpenSBI项目,作为RISC-V系统启动的一个关键组件,它的工作原理及如何在RISC-V启动过程中发挥作用。

- Tutorials:为读者提供关于RISC-V启动的实际操作教程,帮助其在真实环境中应用所学内容。

- Current Status:讲述RISC-V启动流程的当前状态,包括目前的进展、已解决的问题和仍存在的挑战。

- Future work:展望RISC-V启动流程未来的发展方向,探讨可能的改进和新的技术发展。

- Tutorials:再次提供相关的教程链接,帮助用户更深入理解和实践。

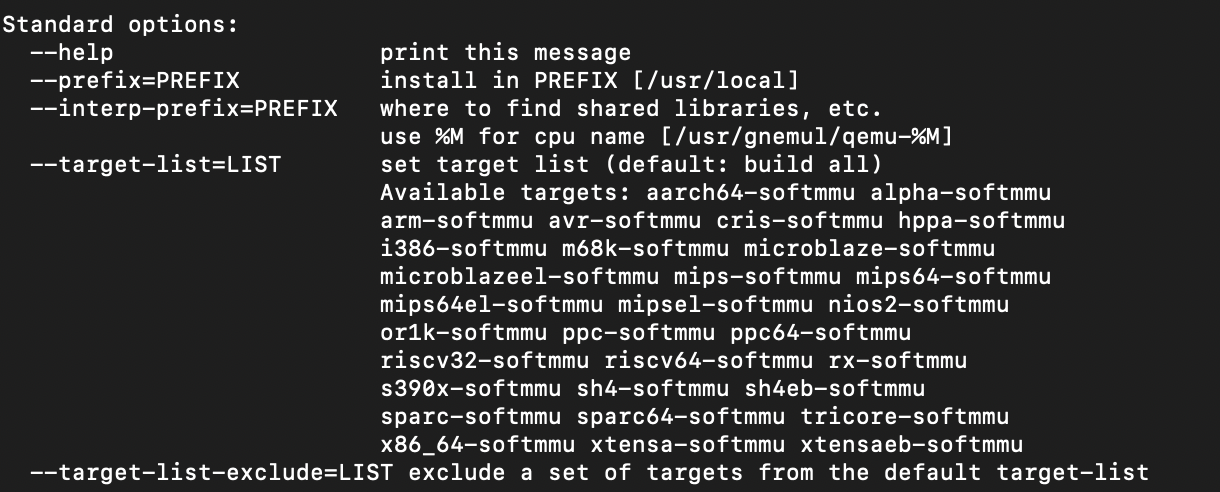

Prerequisite

在进行本次学习之前,需要做一些准备工作:

-

下载演示文稿:用户可以通过提供的短链接(shorturl.at/clITU)下载完整的演示文档。

-

操作系统要求:需要一台运行Linux操作系统的设备,任何发行版均可接受。这是因为RISC-V相关的开发环境多基于Linux。

-

可选的内核源代码构建环境:可以选择设置Linux内核源代码的构建环境,这对深入研究和开发RISC-V启动流程非常有帮助。

-

Ubuntu用户的具体指令:对于使用Ubuntu操作系统的用户,提供了安装相关开发环境的软件包命令:

sudo apt-get install git build-essential kernel-package fakeroot libncurses5-dev libssl-dev bison flex这条命令会安装一系列工具,包括构建工具链、内核打包工具、SSL库开发包等,这些都是在构建、调试和运行RISC-V启动流程时可能需要的依赖项。

Getting started

开始RISC-V的启动流程实验,需要完成以下几步准备工作:

-

创建工作目录

使用以下命令创建一个新的目录,并进入该目录:mkdir summit_demo; cd summit_demo -

下载交叉编译工具链

RISC-V的开发通常需要使用交叉编译工具链来编译代码,工具链可从以下链接下载: -

下载预构建的镜像

预先构建好的RISC-V镜像文件可以从以下链接获取: -

克隆OpenSBI项目

使用Git将OpenSBI项目克隆到本地,OpenSBI是RISC-V启动流程中重要的部分:git clone https://github.com/riscv/opensbi.git -

克隆U-Boot项目

同样,使用Git克隆U-Boot项目并切换到指定版本(v2019.10)。U-Boot是一个通用的引导加载程序,广泛用于嵌入式系统中:git clone https://github.com/u-boot/u-boot.git; git checkout v2019.10

这些步骤将为RISC-V启动实验设置好基础的开发环境和工具链,确保可以顺利运行后续的启动过程。

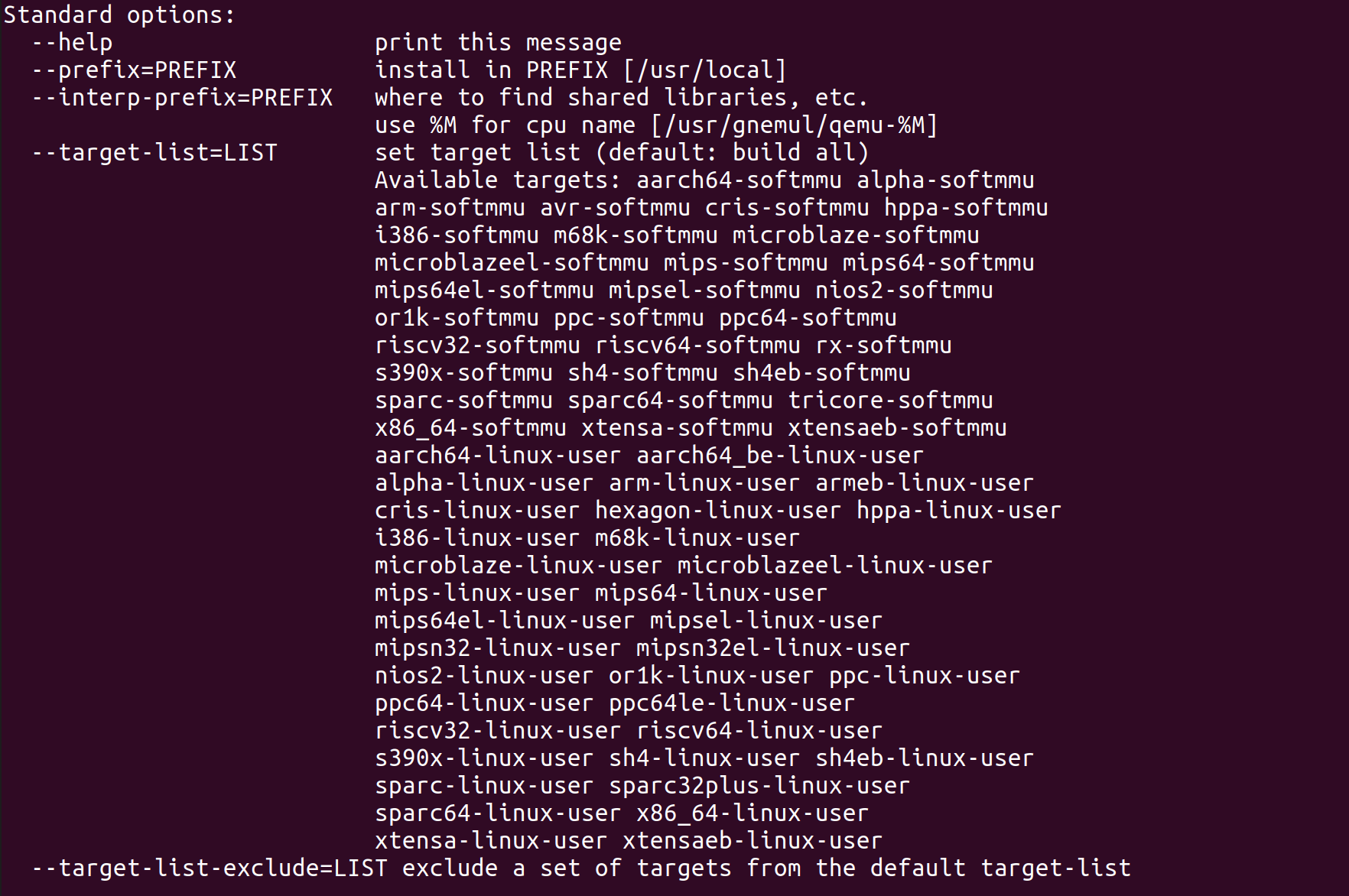

Common boot flow

在嵌入式系统中,启动过程通常分为多个阶段,每个阶段的功能和执行环境不同。常见的启动流程包括以下几个阶段:

-

ROM阶段

- 运行环境:从片上ROM(Read-Only Memory)中执行。

- 功能:负责系统上电和时钟设置,SOC(系统级芯片)的启动。

- 该阶段的软件直接存储在芯片中,执行非常基础的启动任务,为后续阶段的运行做准备。

-

LOADER阶段

- 运行环境:通常从片上SRAM(Static RAM)中运行,有时也会初始化DDR内存。

- 功能:加载运行时环境(RUNTIME)和引导加载程序(BOOTLOADER)。

- 示例:BIOS/UEFI、U-Boot SPL、Coreboot。

在这一阶段,系统开始对内存进行初始化,加载更复杂的启动代码,准备进入运行时阶段。

-

RUNTIME阶段

- 运行环境:可以从片上SRAM或已初始化的DDR内存中执行。

- 功能:处理SOC的安全设置,提供符合规格的运行时服务。

- 示例:ATF(Arm Trusted Firmware)、BIOS/UEFI。

该阶段开始执行系统的安全设置,并确保系统的关键资源按照设计规格被正确管理。

-

BOOTLOADER阶段

- 运行环境:从DDR内存中运行,通常为开源软件。

- 功能:文件系统支持、网络启动、引导配置等。

- 示例:U-Boot、GRUB、LinuxBoot。

引导加载程序负责加载操作系统内核,提供网络启动等功能,并引导进入最终的操作系统。

-

OS阶段

在引导加载程序的引导下,操作系统(OS)被加载并开始执行,系统正式进入工作状态。

整个流程通过不同阶段的加载和跳转,逐步引导系统从最初的硬件上电状态进入功能完善的操作系统,确保了启动过程的安全性和稳定性。

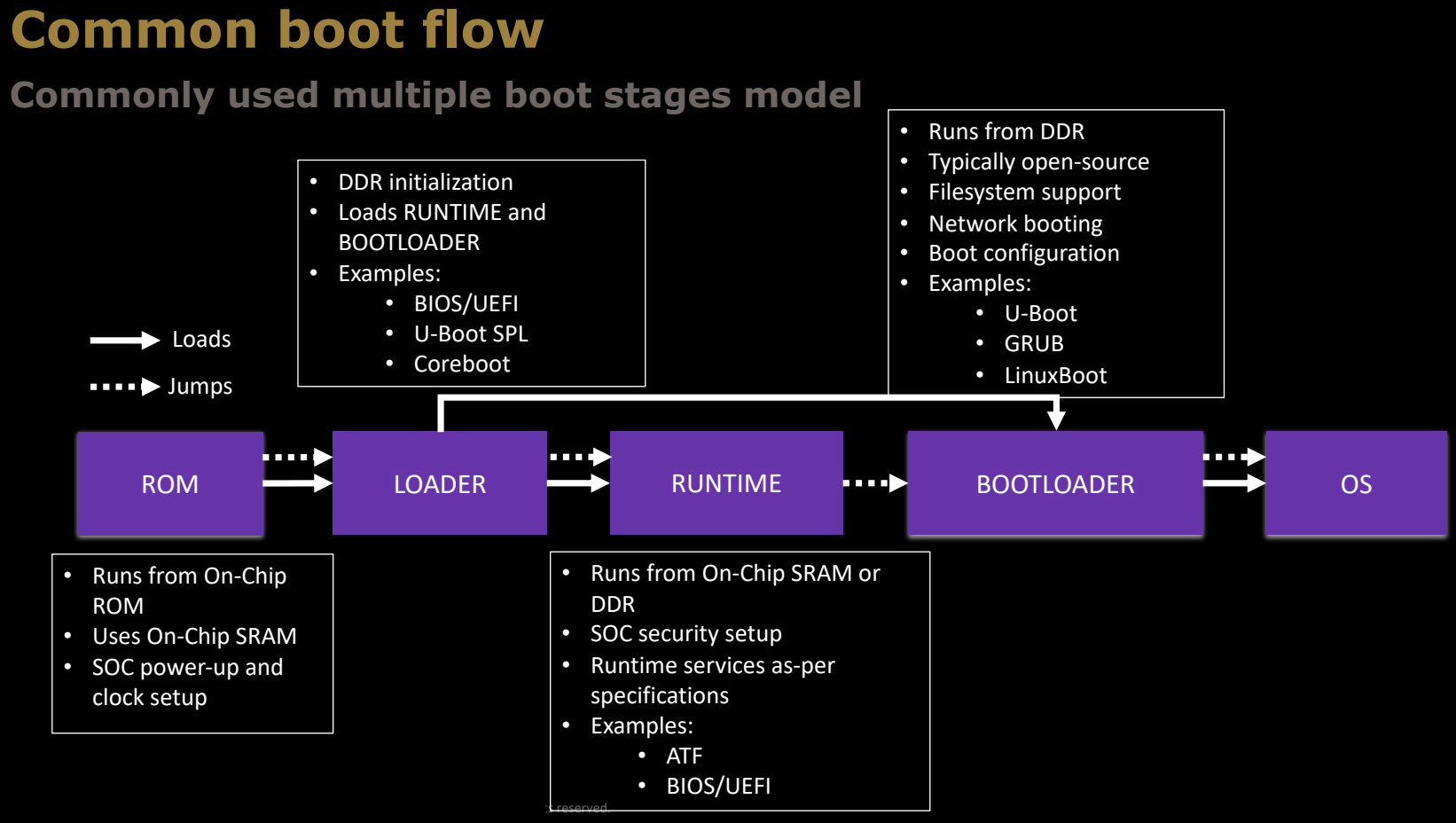

Common boot flow in ARM64

在ARM64架构中,启动流程也分为多个阶段,常见的启动模型如下:

-

ROM阶段

- 功能:从片上ROM中运行,负责启动系统最初的硬件初始化。通常,它会加载下一个阶段的启动加载程序,例如Coreboot或U-Boot SPL(Secondary Program Loader)。

-

Coreboot/U-Boot SPL / ATF BL2阶段

- 功能:从ROM加载,负责初始化系统内存(如DDR)和其他关键硬件资源。对于某些系统,还会加载ATF(Arm Trusted Firmware)BL2,它处理一些系统安全和电源管理任务。

-

ATF BL31阶段

- 功能:这是ATF的一个关键部分,负责处理安全性问题,例如设置安全世界与非安全世界之间的隔离。它在系统进入U-Boot或操作系统之前,确保所有的安全配置和硬件初始化已经完成。

-

U-Boot阶段

- 功能:U-Boot作为引导加载程序,负责加载操作系统内核。它可能会使用"Falcon模式"来直接加载操作系统,跳过某些额外的初始化步骤,以加快启动速度。

-

OS阶段

- 功能:操作系统加载并开始运行。ARM64平台通常使用Linux等操作系统。

这个启动流程中,ATF(Arm Trusted Firmware)是ARM64平台的一个重要部分,负责处理安全模式的切换和运行时的硬件管理。整个流程从硬件初始化开始,经过多次加载和跳转,最终将系统引导至操作系统。

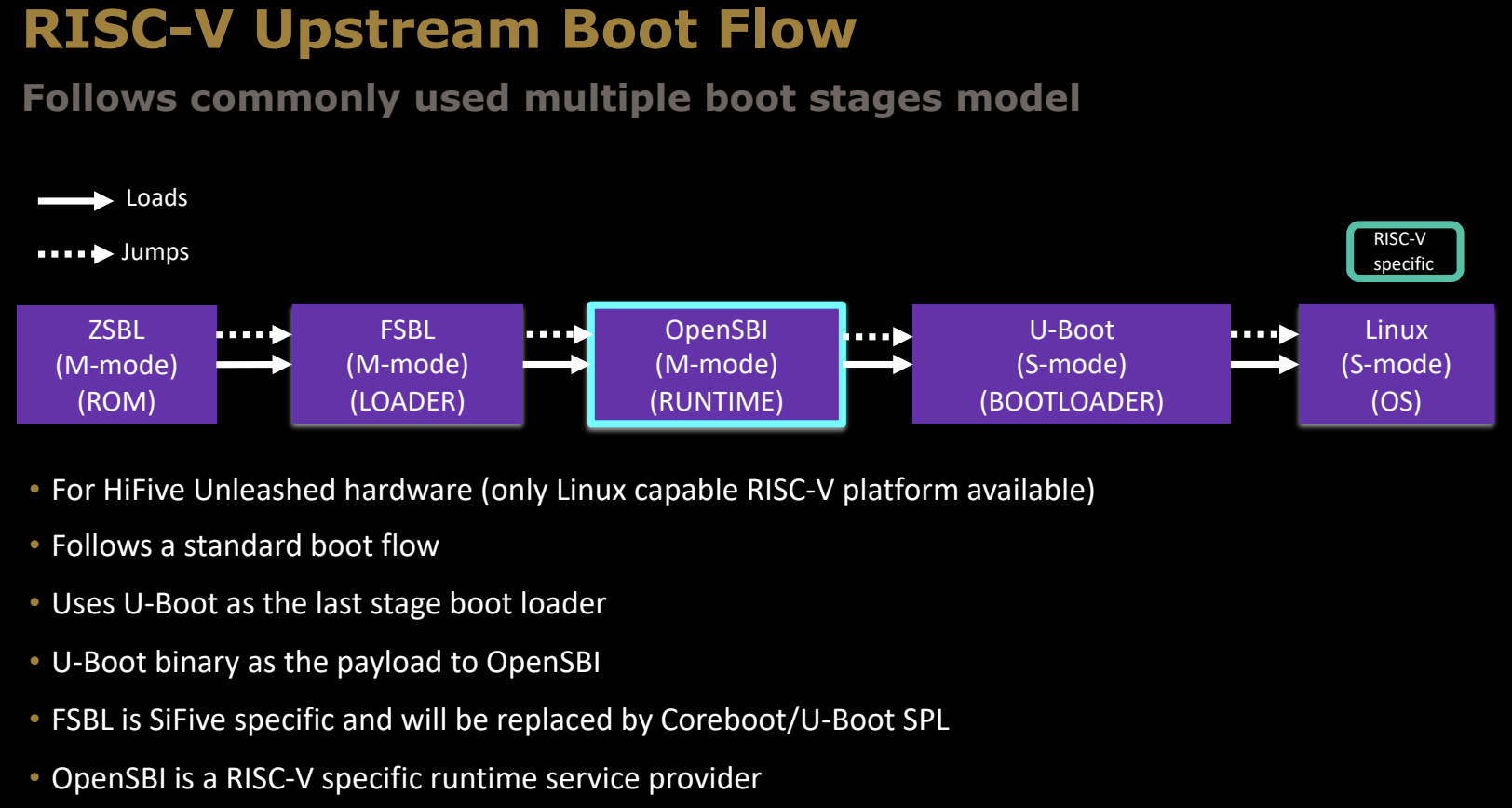

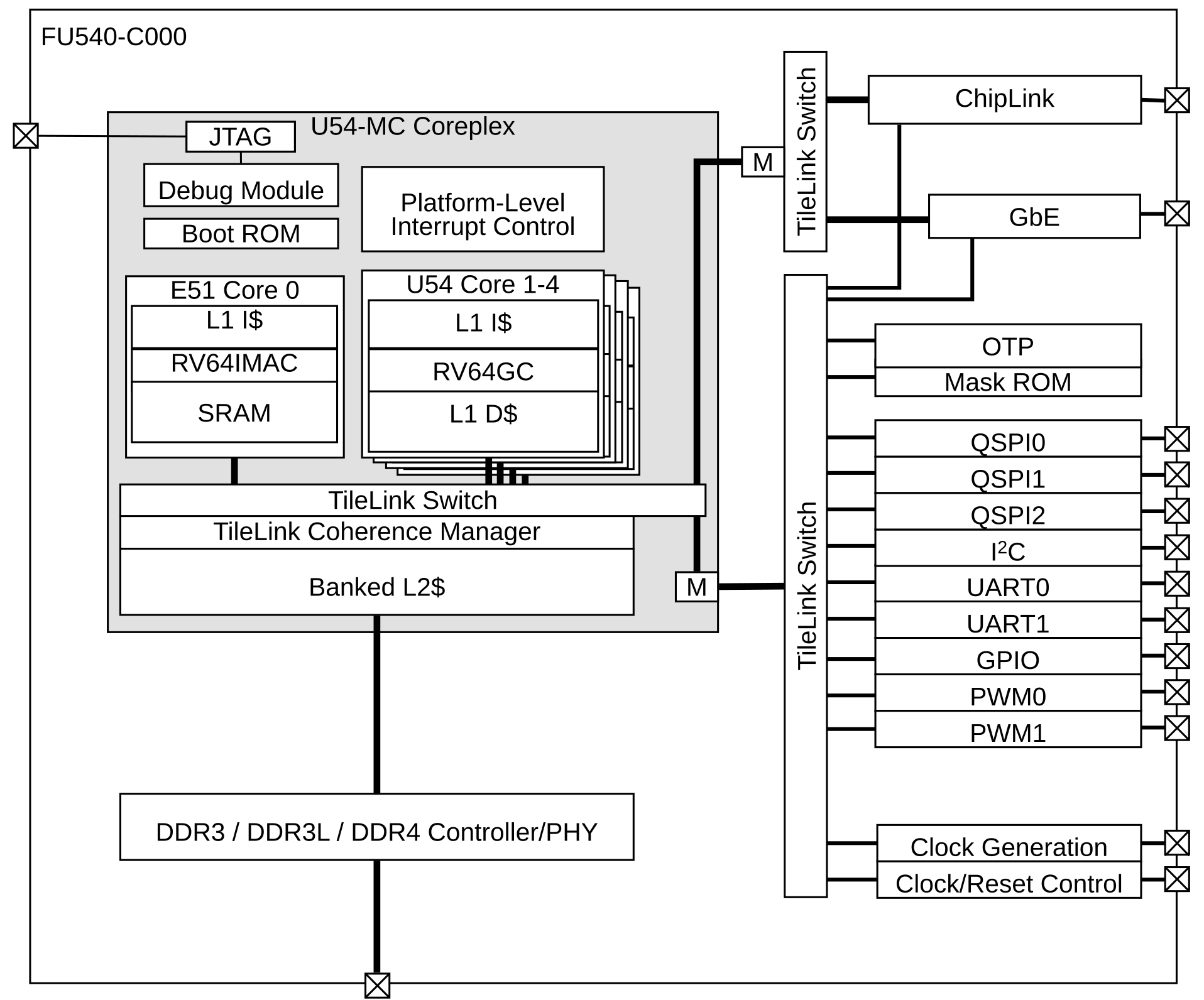

RISC-V Upstream Boot Flow

与ARM64相似,RISC-V的启动流程也遵循多个阶段的模型,以下是RISC-V的启动流程:

-

ZSBL阶段 (M-mode, ROM)

- 功能:ZSBL(Zero Stage Boot Loader)是启动的第一个阶段,从片上ROM运行,负责最基础的硬件初始化任务。它会加载FSBL(First Stage Boot Loader)。

-

FSBL阶段 (M-mode, LOADER)

- 功能:FSBL从ZSBL加载,进一步初始化内存和其他外设资源。对于SiFive开发的RISC-V平台,FSBL是特定的加载程序,不过在其他平台上可能会被Coreboot或U-Boot SPL取代。

-

OpenSBI阶段 (M-mode, RUNTIME)

- 功能:OpenSBI(Open Source Supervisor Binary Interface)是RISC-V架构中的一个关键组件,它为上层软件提供RISC-V特定的运行时服务。OpenSBI运行在机器模式(M-mode)下,直接控制硬件,并提供标准化的接口给下一阶段的引导加载程序或操作系统。

-

U-Boot阶段 (S-mode, BOOTLOADER)

- 功能:U-Boot在S-mode(Supervisor Mode)下运行,作为引导加载程序,负责加载操作系统内核。U-Boot在此阶段的作用与其他架构相似,处理网络启动、存储设备管理和文件系统加载。

-

Linux阶段 (S-mode, OS)

- 功能:最终操作系统被加载并进入运行。RISC-V目前主要支持Linux等开源操作系统。

关键说明

- 适用平台:这个流程主要适用于HiFive Unleashed硬件平台,这是目前 (2019.12) 唯一支持Linux的RISC-V开发板。

- 使用U-Boot作为最后阶段的引导加载程序:U-Boot是一个通用的引导加载程序,处理操作系统的加载。

- OpenSBI:这是RISC-V的特定组件,负责为引导加载程序和操作系统提供运行时服务。

与ARM64的启动流程相比,RISC-V的启动流程同样分为多个阶段,但其中的OpenSBI是RISC-V独有的一个关键部分。它提供了机器模式(M-mode)下的关键服务,使得引导加载程序和操作系统可以在RISC-V平台上顺利运行。

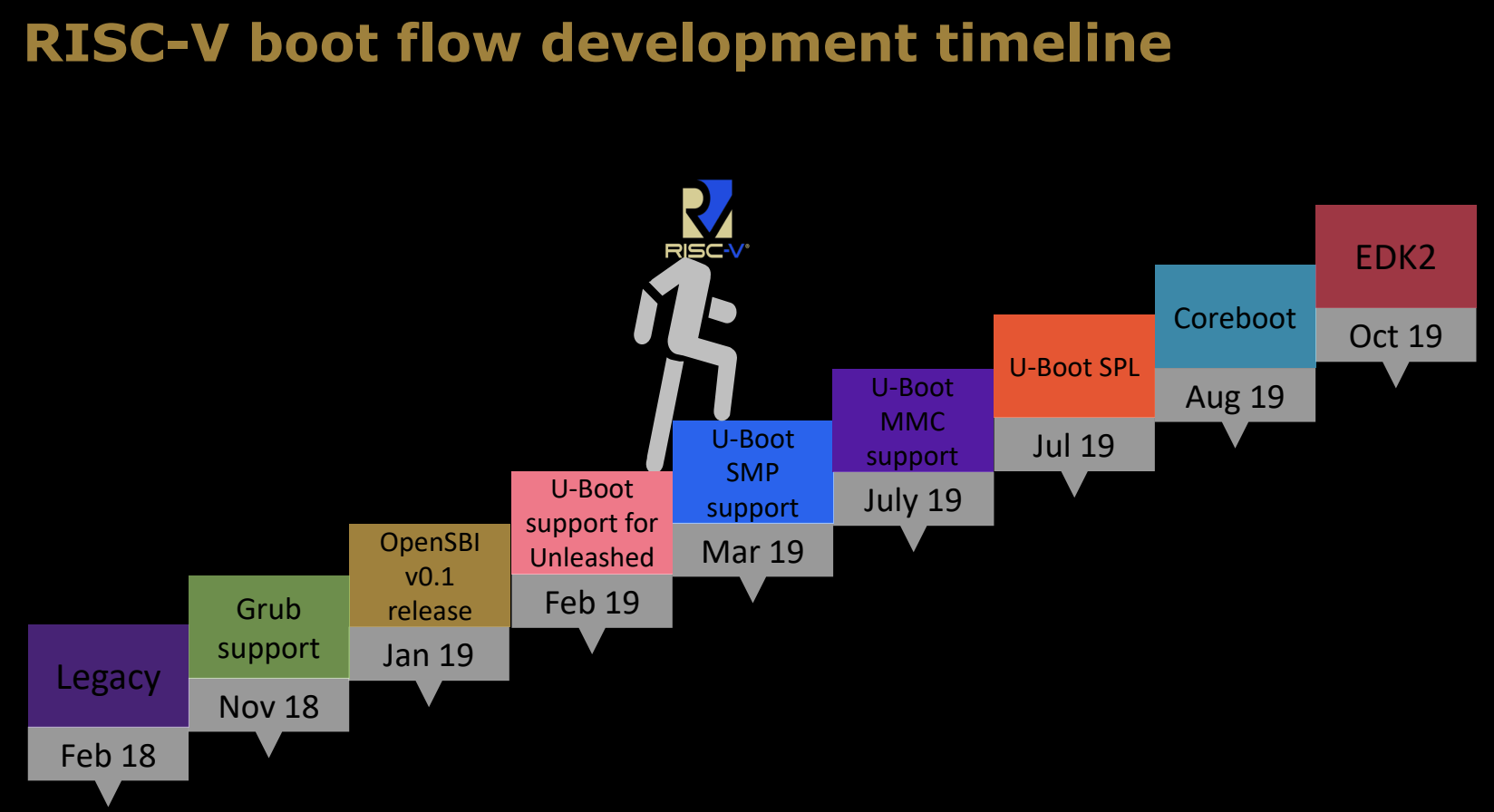

RISC-V boot flow development timeline

RISC-V启动流程的发展历程 (-2019.12) 展现了该架构的逐步成熟和演变。每个重要的里程碑标志着RISC-V启动流程支持的新功能和特性:

-

Legacy(Feb 18)

在2018年2月之前,RISC-V启动流程仍处于早期阶段,很多现代启动组件尚未完善。 -

Grub support(Nov 18)

2018年11月,RISC-V得到了Grub(Grand Unified Bootloader)的支持。Grub是一个常用的开源引导加载程序,它为RISC-V引入了更通用的启动加载选项,支持多种操作系统。 -

OpenSBI v0.1 release(Jan 19)

2019年1月,OpenSBI v0.1版本发布。OpenSBI是RISC-V启动流程中的关键组件,为操作系统提供运行时服务并管理硬件资源。 -

U-Boot support for Unleashed(Feb 19)

2019年2月,U-Boot引入了对HiFive Unleashed开发板的支持。这是RISC-V平台上首个支持Linux的开发板,U-Boot的支持使得该平台能够顺利引导操作系统。 -

U-Boot SMP support(Mar 19)

2019年3月,U-Boot增加了SMP(对称多处理)支持,允许多核处理器在RISC-V平台上进行并行处理,提升系统的性能和灵活性。 -

U-Boot MMC support(July 19)

2019年7月,U-Boot引入了对MMC(多媒体卡)的支持,允许RISC-V设备通过MMC卡存储和加载操作系统。 -

U-Boot SPL(July 19)

同样在2019年7月,U-Boot SPL(Secondary Program Loader)支持引入。SPL是一种轻量级引导程序,专门用于初始化内存和加载完整的引导程序。 -

Coreboot(Aug 19)

2019年8月,Coreboot支持被引入RISC-V启动流程。Coreboot是一个快速、灵活的开源固件平台,旨在替代传统的BIOS/UEFI。 -

EDK2(Oct 19)

2019年10月,EDK2的支持被加入。EDK2是UEFI固件的开源实现,它为RISC-V提供了标准化的固件接口,使其能够与更广泛的软件生态系统兼容。

这条时间线展示了RISC-V启动流程逐步从基础的启动支持走向复杂的多处理器支持、高级存储设备支持和开源固件的集成,最终形成一个功能完善、模块化的启动系统。

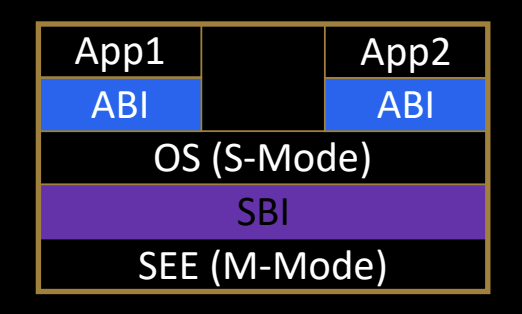

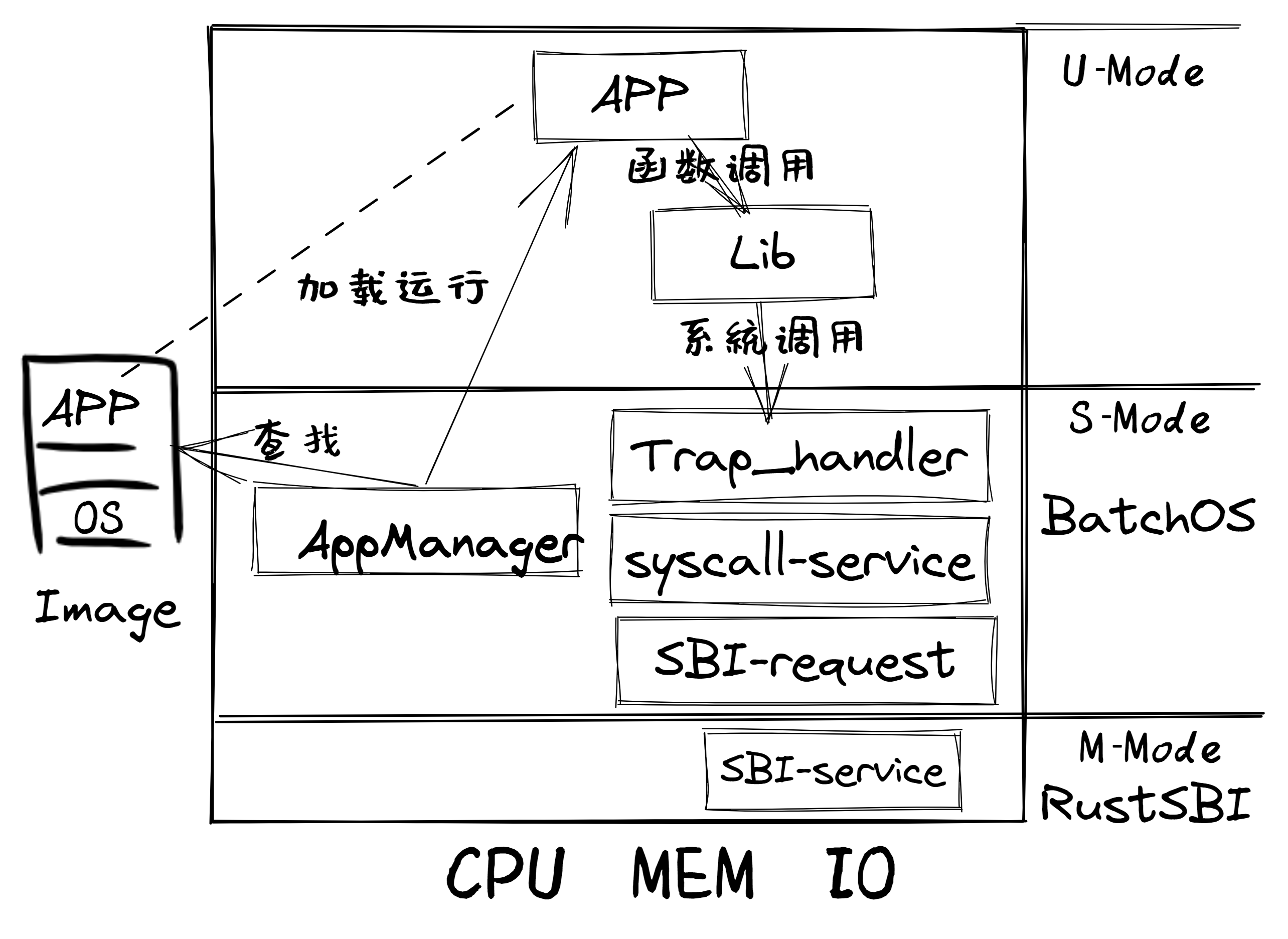

What is SBI?

SBI(Supervisor Binary Interface)是RISC-V架构中的管理模式二进制接口,其作用类似于系统调用接口,允许超级模式(S-mode)的操作系统与机器模式(M-mode)的执行环境(SEE, Supervisor Execution Environment)进行通信。它定义了一组标准化的接口,使得不同的操作系统和平台可以在不重复编写硬件相关代码的情况下,访问底层硬件资源。

SEE的定义

- M-mode下的运行时固件:为运行在HS-mode(Hypervisor Supervisor Mode)的操作系统或虚拟机管理器提供运行时服务。

- HS-mode下的虚拟机管理器:为运行在VS-mode(Virtual Supervisor Mode)的客户操作系统提供管理功能。

SBI的作用

- 减少平台代码的重复:通过统一的接口,减少Linux、FreeBSD等操作系统中的平台特定代码,简化操作系统在不同硬件平台上的移植和维护工作。

- 提供共享驱动程序:使多个平台可以共享驱动程序,避免为每个平台单独编写。

- 提供硬件资源访问接口:SBI允许操作系统直接访问机器模式下(M-mode)的硬件资源。

规范和开发进展

SBI的规范由Unix平台规范工作组制定,当前的版本包括:

- SBI v0.1:目前 (2019.12) 广泛使用。

- SBI v0.2:正在草案阶段,旨在提供更多功能和更好的性能。

SBI的详细文档和规范可以通过RISC-V的SBI GitHub项目获取。

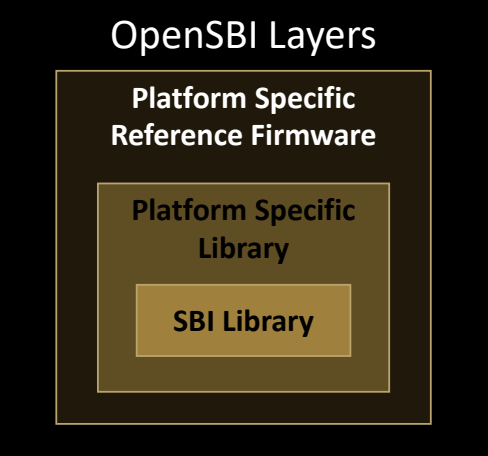

What is OpenSBI?

OpenSBI是RISC-V体系结构中Supervisor Binary Interface (SBI) 规范的开源实现。它为机器模式(M-mode)提供运行时服务,是RISC-V启动流程中的关键组件,通常在ROM/LOADER阶段之后使用。OpenSBI通过提供标准化接口,使得上层操作系统可以与硬件进行交互,从而避免了SBI实现的碎片化。

OpenSBI的主要特性

- 开源实现:OpenSBI遵循BSD-2条款许可证,由社区维护和开发。它确保SBI的实现一致性,并避免不同平台上SBI实现的差异。

- 提供运行时服务:OpenSBI在机器模式(M-mode)下运行,负责为操作系统(通常是在超级模式S-mode下运行)提供必要的服务。

- 支持参考平台:OpenSBI为不同平台提供了参考驱动程序,包括PLIC(平台级中断控制器)、CLINT(核心本地中断器)和UART 8250驱动程序等。其他平台可以基于这些通用代码添加自己的平台驱动程序。

- 社区维护的开源项目:用户可以通过OpenSBI的GitHub获取源代码、文档以及最新的更新。

OpenSBI的作用

OpenSBI主要为RISC-V平台提供一个标准化的接口,使操作系统可以高效、安全地与硬件交互。它被设计为可移植和模块化的,使得不同硬件平台可以复用它的核心功能,同时添加各自平台特定的驱动程序。

Key Features

OpenSBI具备以下几个重要的功能特性,确保其能够在广泛的硬件环境中高效运行,并适应不同的使用场景:

分层结构以适应多种用例

-

通用SBI库与平台抽象层:

通用的SBI库实现了平台抽象,通常与外部固件和引导加载程序(如EDK2、Secure Boot工作组实现的UEFI)一起使用。它提供了标准的SBI接口,使得外部引导加载程序可以在不同的平台上稳定运行。 -

平台特定的库:

与核心库类似,但包含特定平台的驱动程序。它允许硬件厂商根据自身硬件的特点进行定制,而不影响SBI核心功能的通用性。 -

平台特定的参考固件:

提供三种不同类型的运行时固件,供开发人员参考和使用。它们涵盖了从最基本的引导流程到高级的硬件初始化需求。

广泛支持的硬件特性

OpenSBI支持多种硬件特性,确保它能够在各种不同的RISC-V系统中运行,包括:

- 支持RV32和RV64:既支持32位的RISC-V架构,也支持64位架构,使其在不同的硬件平台上都可以使用。

- 虚拟化支持:支持Hypervisor模式,允许虚拟机管理程序在硬件上运行多个操作系统实例。

- 未对齐的加载/存储处理:处理未对齐的内存访问操作,确保在所有情况下都能正确处理数据。

- CSR(控制状态寄存器)仿真:为某些平台提供CSR仿真,确保它们能够顺利运行RISC-V的通用指令集。

- 使用PMP(物理内存保护)保护固件:通过PMP确保固件在运行时免受非法内存访问的威胁,增强系统的安全性。

OpenSBI的层次结构设计和其支持的硬件特性使其能够适应从简单到复杂的各种RISC-V平台,成为RISC-V生态系统中不可或缺的一部分。通过提供标准化的接口和驱动支持,OpenSBI确保了RISC-V平台的可移植性和扩展性。

Platform support

OpenSBI支持多种RISC-V平台,包括以下几种:

- SiFive HiFive Unleashed:这是RISC-V开发板中最为著名的硬件平台之一,支持Linux操作系统运行。

- Andes AE350:由Andes Technology开发的RISC-V处理器平台,适用于嵌入式系统和IoT应用。

- Ariane FPGA SoC:基于Ariane RISC-V内核的可编程逻辑器件(FPGA)系统芯片,适合硬件验证和研究。

- Kendryte K210:一个专为物联网和AI应用设计的RISC-V芯片,内置AI加速器和神经网络处理器。

- QEMU虚拟机(32位/64位):QEMU是一款开源虚拟机仿真器,可以通过模拟RISC-V架构的虚拟机进行开发和测试,支持32位和64位系统。

- OmniXtend:一个支持RISC-V的开源互连协议,用于高性能计算和数据中心应用。

这些平台覆盖了从硬件开发板到虚拟机环境的广泛应用场景,能够帮助开发者在不同的硬件和虚拟化环境中进行RISC-V软件开发和测试。

Tutorial

Setup details

为了成功设置RISC-V开发环境,以下步骤详细说明了如何配置工具链、QEMU仿真器以及环境变量。

-

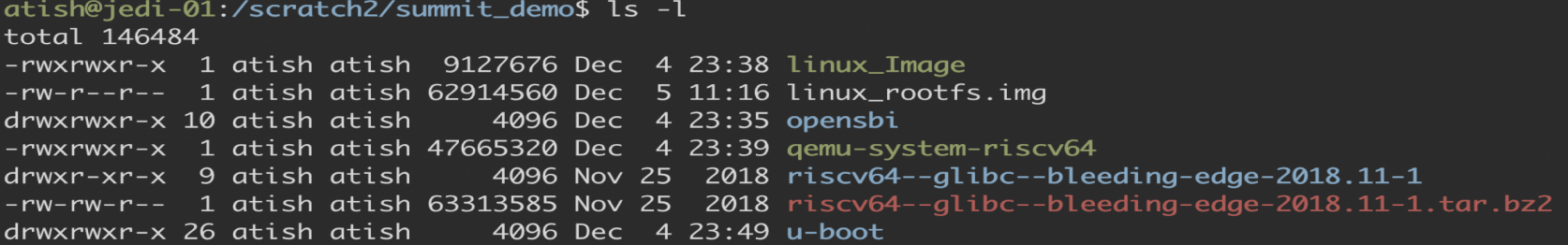

查看当前工作目录的设置

运行以下命令查看当前目录下的文件和设置:ls -l

输出结果展示了几个关键文件:

linux_Image:Linux内核镜像文件。linux_rootfs.img:根文件系统镜像,用于仿真系统的文件结构和内容。opensbi:OpenSBI的二进制文件,提供运行时服务。qemu-system-riscv64:QEMU的RISC-V 64位二进制文件,用于虚拟机仿真。riscv64--glibc--bleeding-edge-2018.11-1:RISC-V的交叉编译工具链。u-boot:U-Boot引导加载程序,用于启动系统。

-

解压工具链并将其添加到环境路径

下载并解压RISC-V工具链后,需要将其路径添加到系统环境变量中:tar -xvf riscv64--glibc--bleeding-edge-2018.11-1.tar.bz2 export PATH=$PATH:riscv64--glibc--bleeding-edge-2018.11-1/bin/这将确保可以在命令行中直接调用交叉编译工具链进行开发和构建。

-

更改QEMU二进制文件的权限

为了能够运行QEMU仿真器,需要为其二进制文件设置执行权限:chmod a+x qemu-system-riscv64这一步确保QEMU仿真器可以被正确执行,用于模拟RISC-V系统。

-

设置环境变量CROSS_COMPILE和ARCH

设置交叉编译工具链的相关环境变量,以确保编译过程中可以正确识别目标架构:export ARCH=riscv export CROSS_COMPILE=riscv64-linux-这里的

ARCH变量指定了目标架构为RISC-V,而CROSS_COMPILE则设置了用于交叉编译的前缀,使得编译器知道要为RISC-V平台生成代码。

通过上述步骤,可以成功配置一个完整的RISC-V开发和仿真环境。这些步骤尤其适合那些希望在虚拟化环境中运行RISC-V操作系统或开发软件的开发者。

Tutorial-I: Boot Linux in Qemu as a payload to OpenSBI

这部分指导如何通过OpenSBI在Qemu中启动Linux系统。Qemu是一个强大的虚拟化工具,支持RISC-V等多种架构,允许用户在虚拟环境中运行完整的操作系统。本教程将详细介绍如何将Linux内核作为OpenSBI的payload,在Qemu中运行RISC-V Linux系统。

1. 编译OpenSBI

首先,进入OpenSBI的源代码目录,并编译适用于Qemu虚拟机的OpenSBI固件。这里的PLATFORM参数指定了编译目标为Qemu的虚拟机平台,FW_PAYLOAD_PATH参数指定了将Linux内核作为OpenSBI的payload(负载)。

cd opensbi; make PLATFORM=qemu/virt FW_PAYLOAD_PATH=../linux_Image; cd ..

这一过程会生成适用于Qemu虚拟机的OpenSBI镜像,之后可以用作引导加载程序,将Linux内核作为payload。

2. 在Qemu中运行OpenSBI和Linux

接下来,通过Qemu运行OpenSBI,并将Linux根文件系统和内核加载到虚拟机中。以下是用于启动Qemu的命令,其中包括各个参数的具体含义:

qemu-system-riscv64 -M virt -m 256M -nographic \

-kernel opensbi/build/platform/qemu/virt/firmware/fw_payload.elf \

-drive file=linux_rootfs.img,format=raw,id=hd0 \

-device virtio-blk-device,drive=hd0 \

-append "root=/dev/vda rw console=ttyS0"

-M virt:指定Qemu使用的虚拟硬件平台,这里选择的是虚拟机平台。-m 256M:分配给虚拟机的内存大小,设定为256MB。-nographic:以无图形界面的方式运行虚拟机,所有输出将通过命令行显示。-kernel:指定OpenSBI固件的路径,OpenSBI的固件负责引导系统并加载Linux内核。-drive:指定根文件系统镜像的路径,这里使用的是linux_rootfs.img,格式为原始镜像。-device virtio-blk-device:使用virtio块设备驱动,为Qemu虚拟机提供存储设备支持。-append:向Linux内核传递命令行参数,指定根文件系统位于/dev/vda,并设置控制台为ttyS0。

通过上述命令,Qemu将启动虚拟的RISC-V系统,加载OpenSBI并运行Linux内核。

Adding Support for New Platforms

在开发过程中,可能需要为OpenSBI添加对新平台的支持。以下是为新平台添加支持的步骤:

-

在

/platform目录下创建新的平台目录

为新平台创建一个名为<xyz>的目录,用于存放与该平台相关的配置文件和源码。 -

创建平台配置文件

<xyz>/config.mk

该文件将包含平台的配置选项、常用驱动程序的标志以及固件选项。可以参考模板platform/template/config.mk创建该文件。 -

创建平台对象文件

<xyz>/objects.mk

在此文件中列出需要编译的与平台相关的特定对象文件。可以参考platform/template/objects.mk创建该文件。 -

创建平台源码文件

<xyz>/platform.c

该文件实现与平台相关的具体功能,并提供struct sbi_platform实例。可以参考platform/template/platform.c创建该文件。

额外说明

- 新平台的支持目录

<xyz>可以放置在OpenSBI源代码外部,但需要确保其路径在编译时正确指定。

通过这些步骤,开发者可以为OpenSBI添加对新硬件平台的支持,确保其能够在不同的硬件环境中正常运行。

Reference Firmwares

OpenSBI提供了几种类型的参考固件,每种固件都针对特定的平台需求。不同类型的固件适用于RISC-V启动流程中的不同阶段和使用场景。

1. FW_PAYLOAD

- 功能:该固件将下一阶段的引导程序作为负载(payload)进行加载。这是适用于Linux等操作系统的RISC-V硬件上最常用的固件类型。

- 默认使用:在可运行Linux的RISC-V硬件中,FW_PAYLOAD是最常用的参考固件。

2. FW_JUMP

- 功能:该固件带有一个固定的跳转地址,用于跳转到下一个引导阶段。这种方式适用于需要手动指定引导地址的场景。

- 默认使用:这是QEMU仿真环境中的默认引导方法。

3. FW_DYNAMIC

- 功能:该固件通过动态信息来确定下一个引导阶段。这种方式通常用于U-Boot SPL或Coreboot等加载程序,能够根据运行时信息灵活调整引导流程。

- 使用场景:U-Boot SPL和Coreboot等平台使用FW_DYNAMIC来管理引导流程。

SOC厂商的选择

SOC厂商可以根据自身需求选择适合的固件类型:

- 使用OpenSBI的参考固件作为M-mode的运行时固件。

- 使用OpenSBI作为库,完全从头构建M-mode运行时固件。

- 扩展现有的M-mode固件(如U-Boot_M_mode或EDK2),并将OpenSBI作为库来增强功能。

通过这些选项,硬件厂商能够根据平台的实际需求,灵活地选择和定制适合的固件解决方案。

U-Boot: An universal boot loader

U-Boot(Universal Boot Loader)是嵌入式系统中最常用的通用引导加载程序,广泛用于多个架构和平台。它作为最后阶段的引导加载器,负责加载操作系统并管理底层硬件资源。

U-Boot的支持范围

- 支持多种指令集架构(ISA):包括x86、ARM、AARCH64、RISC-V、ARC等,使其在不同架构的硬件上都能使用。

- 支持多种外设接口:如UART、SPI、I2C、以太网、SD卡、USB等,涵盖了几乎所有常见的嵌入式外设。

- 支持多种文件系统:能够从不同的文件系统中加载镜像,包括常见的文件系统格式。

- 支持多种网络协议:如TFTP等网络协议,允许从网络中加载操作系统镜像或数据。

U-Boot的功能

- 加载镜像:可以从网络、文件系统、可移动设备等多种介质中加载操作系统镜像。

- 命令行管理界面:U-Boot提供了一个简便的命令行接口,用于执行引导命令、配置启动参数以及调试系统。

高度的可定制性

U-Boot具备丰富的定制选项,能够根据实际需求进行裁剪和优化:

- U-Boot SPL:这是U-Boot的精简版本,通常作为启动的第一级引导加载器,用于最小化引导时间并加载完整的U-Boot程序。

- Falcon模式:该模式用于加速启动流程,直接加载操作系统,跳过某些不必要的初始化步骤。

U-Boot凭借其广泛的支持、灵活的定制性以及强大的功能,成为嵌入式系统中几乎标准的引导解决方案。它可以适应从开发板到生产环境的多种场景,使得系统启动流程更加高效和灵活。

Tutorial-II: Boot Linux in Qemu using U-Boot proper

这部分介绍如何在Qemu中通过完整的U-Boot(U-Boot proper)引导Linux系统。与之前的教程不同,这里使用的是U-Boot作为最后阶段的引导加载程序,而不是直接将Linux作为OpenSBI的payload。通过此方法,用户可以充分利用U-Boot的灵活性和强大的引导功能。

1. 编译U-Boot

首先,进入U-Boot的源代码目录,并为RISC-V平台的Qemu环境进行配置和编译。这里使用了qemu-riscv64_smode_defconfig配置文件,它为RISC-V 64位的Qemu虚拟机环境生成适合的U-Boot配置。

cd u-boot; make qemu-riscv64_smode_defconfig; make; cd ..

2. 编译OpenSBI

接下来,进入OpenSBI的源代码目录,并编译适用于Qemu的OpenSBI固件。与之前不同,这次没有指定payload,意味着OpenSBI的职责仅仅是作为U-Boot的引导器。

cd opensbi; make PLATFORM=qemu/virt; cd ..

这里使用fw_jump固件类型,允许U-Boot来加载Linux内核。

3. 在Qemu中运行U-Boot和OpenSBI

编译完成后,可以通过Qemu运行U-Boot和OpenSBI,同时加载Linux内核和根文件系统。运行以下命令:

./qemu-system-riscv64 -M virt -smp 4 -m 256M -nographic \

-bios opensbi/build/platform/qemu/virt/firmware/fw_jump.elf \

-kernel u-boot/u-boot.bin -device loader,file=linux_Image,addr=0x84000000 \

-drive file=linux_rootfs.img,format=raw,id=hd0 \

-device virtio-blk-device,drive=hd0

-M virt:指定使用Qemu的虚拟机平台。-smp 4:为虚拟机分配4个CPU核心,模拟多核环境。-m 256M:分配256MB内存。-nographic:以无图形界面的方式运行。-bios:指定OpenSBI固件路径,此处使用的是fw_jump.elf。-kernel:指定U-Boot二进制文件作为引导加载程序。-device loader:加载Linux内核,并指定其地址为0x84000000,这是U-Boot期望的内核加载地址。-drive:指定根文件系统镜像,格式为原始格式。-device virtio-blk-device:使用virtio块设备模拟存储设备。

通过该命令,Qemu将启动虚拟机,加载OpenSBI和U-Boot,并进入U-Boot的命令行界面。

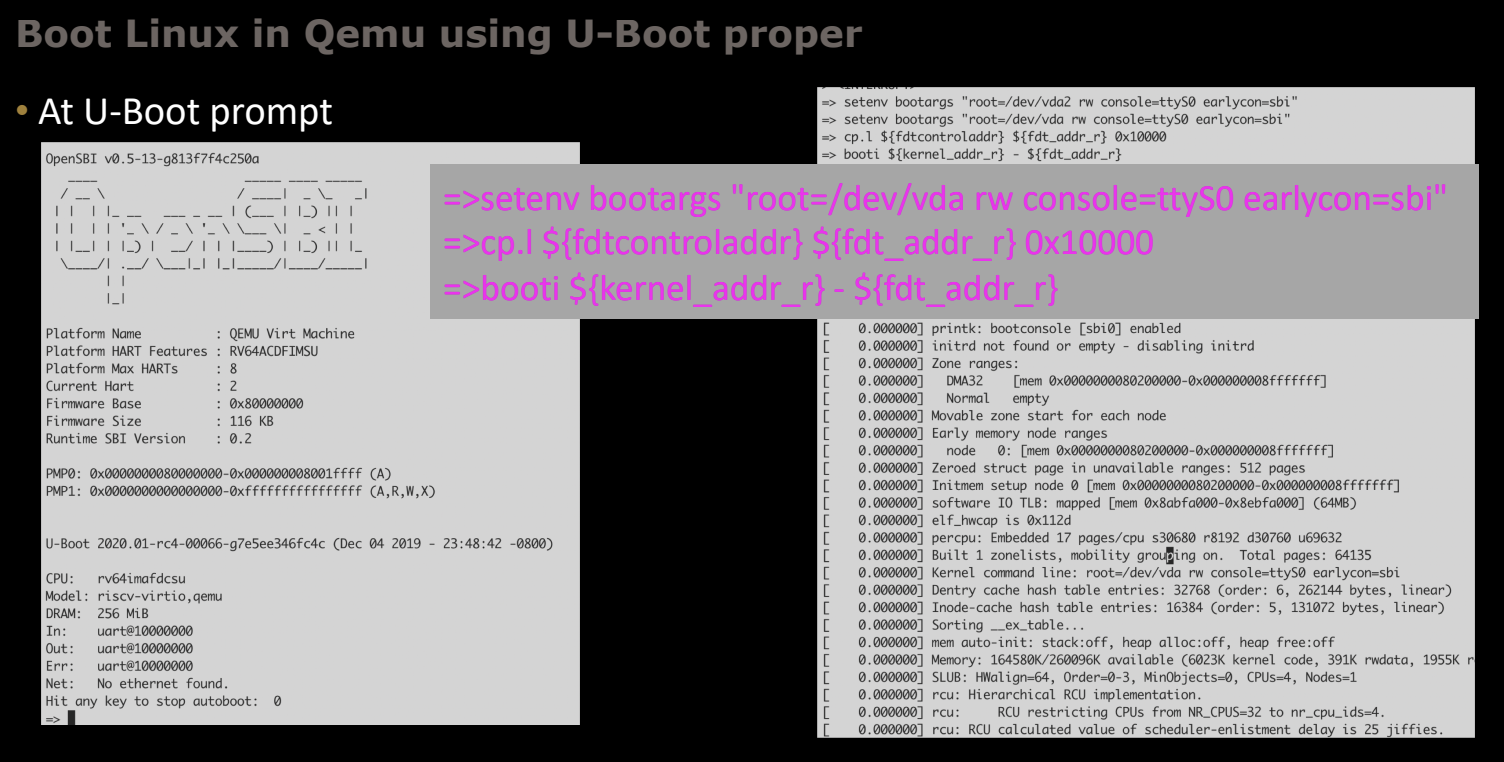

4. 在U-Boot命令行引导Linux

启动后,你将进入U-Boot的命令行提示符。在这里,可以通过以下命令引导Linux内核:

=> setenv bootargs "root=/dev/vda rw console=ttyS0 earlycon=sbi"

=> cp.l ${fdtcontroladdr} ${fdt_addr_r} 0x10000

=> booti ${kernel_addr_r} - ${fdt_addr_r}

setenv bootargs:设置内核引导参数,这里指定根文件系统为/dev/vda,并配置控制台输出。cp.l:复制设备树控制块(fdtcontroladdr)到设备树地址寄存器(fdt_addr_r)。booti:引导Linux内核,kernel_addr_r是内核的加载地址,fdt_addr_r是设备树的地址。

执行这些命令后,U-Boot将加载Linux内核并启动系统。

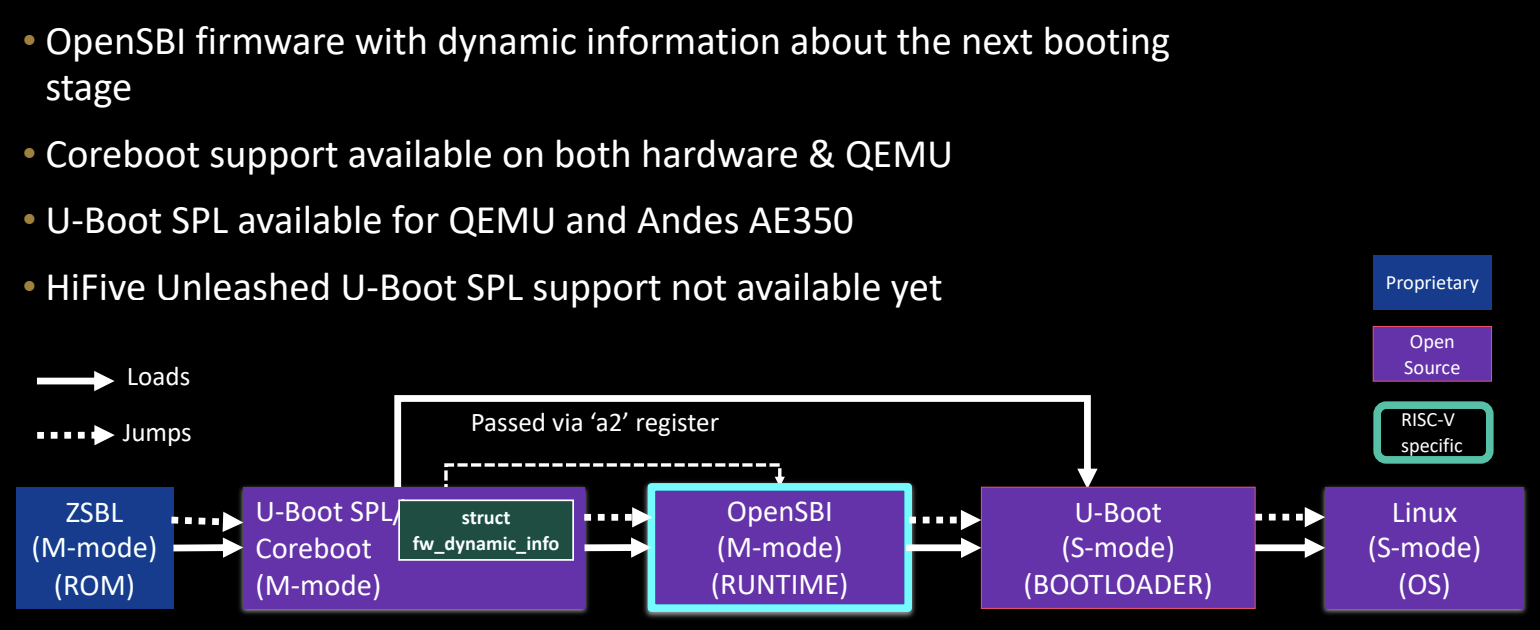

Boot flow using OpenSBI dynamic firmware

在使用OpenSBI动态固件的启动流程中,固件通过动态信息来确定下一个引导阶段。这种方式比固定地址跳转更加灵活,适用于复杂的启动场景。以下是使用OpenSBI动态固件的典型启动流程:

-

ZSBL (M-mode, ROM)

第一个阶段是从机器模式(M-mode)执行的片上ROM固件,负责最基本的硬件初始化。 -

U-Boot SPL/Coreboot (M-mode)

第二阶段使用U-Boot SPL或Coreboot,它们在M-mode下运行,并负责加载下一阶段的启动固件。 -

OpenSBI (M-mode, RUNTIME)

OpenSBI在M-mode下提供运行时服务,使用动态固件(fw_dynamic),通过寄存器a2传递关于下一引导阶段的信息。 -

U-Boot (S-mode, BOOTLOADER)

OpenSBI引导进入U-Boot,U-Boot运行在超级模式(S-mode)下,负责加载Linux内核。 -

Linux (S-mode, OS)

最终,U-Boot加载并引导Linux操作系统,进入正式的工作环境。

核心要点

- OpenSBI动态固件通过

a2寄存器传递下一引导阶段的地址。 - 支持Coreboot和U-Boot SPL在硬件和QEMU中运行。

- 目前HiFive Unleashed板上尚不支持U-Boot SPL。

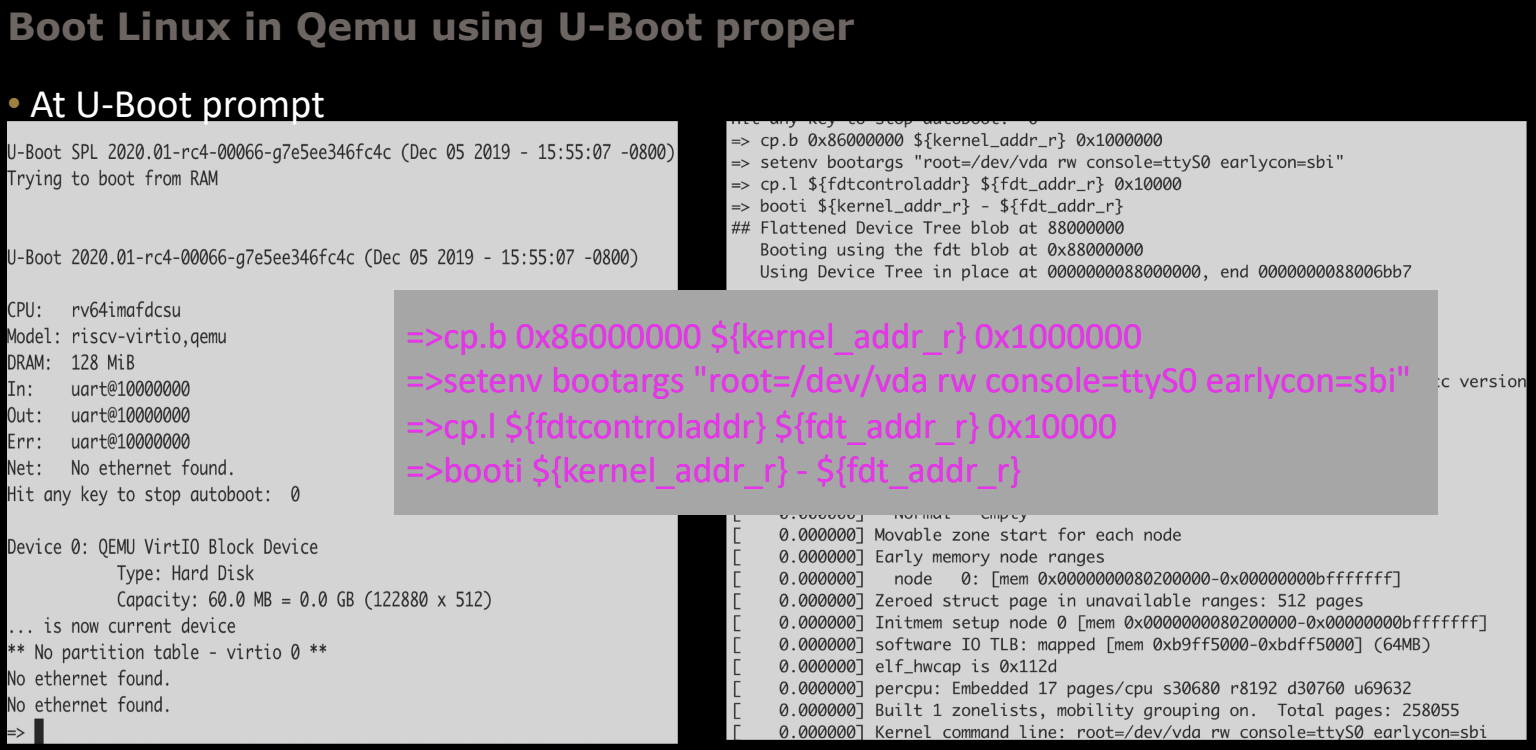

Tutorial-III: Boot Linux in Qemu using U-Boot SPL

这部分介绍如何在Qemu中使用U-Boot SPL作为第一阶段的引导加载程序来引导Linux操作系统。U-Boot SPL是U-Boot的简化版本,通常用于初始化系统硬件并加载完整的U-Boot或操作系统。

1. 编译OpenSBI

首先,编译OpenSBI固件,生成适用于Qemu虚拟机的动态固件。与之前不同,这次不指定payload,OpenSBI的职责是加载U-Boot SPL。

cd opensbi; make PLATFORM=qemu/virt; cd ..

这里生成的fw_dynamic.bin固件将用于引导U-Boot SPL。

2. 编译U-Boot SPL

接下来,编译U-Boot SPL。在这个过程中,需要设置CROSS_COMPILE环境变量并指定OpenSBI动态固件的路径。

cd u-boot; export OPENSBI=../opensbi/build/platform/qemu/virt/firmware/fw_dynamic.bin; \

ARCH=riscv CROSS_COMPILE=riscv64-linux- make qemu-riscv64_spl_defconfig; \

ARCH=riscv CROSS_COMPILE=riscv64-linux- make; cd ..

这里使用qemu-riscv64_spl_defconfig配置文件为Qemu生成U-Boot SPL的配置。

3. 在Qemu中运行U-Boot SPL和Linux

使用以下命令在Qemu中运行U-Boot SPL和Linux镜像:

./qemu-system-riscv64 -nographic -machine virt -m 2G -bios u-boot/spl/u-boot-spl \

-kernel u-boot/u-boot.itb -device loader,file=linux_Image,addr=0x86000000 \

-drive file=linux_rootfs.img,format=raw,id=hd0 \

-device virtio-blk-device,drive=hd0

-machine virt:指定Qemu虚拟机硬件平台。-m 2G:为虚拟机分配2GB内存。-bios u-boot/spl/u-boot-spl:指定U-Boot SPL的二进制文件路径。-kernel u-boot/u-boot.itb:使用FIT镜像(包含U-Boot和设备树)。-device loader:加载Linux内核,并指定其地址为0x86000000。-drive:指定根文件系统镜像。-device virtio-blk-device:使用virtio块设备模拟存储。

通过该命令,Qemu将启动U-Boot SPL,加载U-Boot并引导Linux内核。

4. 在U-Boot命令行引导Linux

当Qemu成功运行后,您将进入U-Boot的命令行界面。在这里,您需要设置引导参数并引导Linux内核:

=> cp.l 0x86000000 ${kernel_addr_r} 0x100000

=> setenv bootargs "root=/dev/vda rw console=ttyS0 earlycon=sbi"

=> cp.l ${fdtcontroladdr} ${fdt_addr_r} 0x10000

=> booti ${kernel_addr_r} - ${fdt_addr_r}

cp.l 0x86000000 ${kernel_addr_r} 0x100000:将Linux内核从加载地址0x86000000复制到内存中的U-Boot地址空间。setenv bootargs:设置内核引导参数,这里指定根文件系统为/dev/vda,并配置控制台输出为ttyS0。cp.l ${fdtcontroladdr} ${fdt_addr_r} 0x10000:复制设备树控制块到设备树地址寄存器。booti:引导Linux内核,指定内核地址和设备树地址。

执行这些命令后,U-Boot将加载Linux内核并启动系统。

Boot flow using OpenSBI as a library

当OpenSBI作为库使用时,它被集成到外部固件的源代码中。通过这种方式,外部固件可以调用OpenSBI的功能,并作为其启动流程的一部分来执行。在这种模式下,必须确保正确的配置和编译环境,使得OpenSBI能够与外部固件无缝集成。

核心要点

- OpenSBI作为外部固件源代码的一部分:OpenSBI与外部固件紧密集成,外部固件需要调用OpenSBI的API。

- 必须配置程序堆栈和scratch空间:为了确保每个HART(硬件线程)的独立运行,外部固件必须为每个HART配置专属的堆栈和scratch空间。

- 相同的GCC目标选项:外部固件和OpenSBI的源代码必须使用相同的GCC编译选项,例如

-march、-mabi和-mcmodel,以保证兼容性。 - EDK2与OpenSBI的集成:目前 (2019.12),HPE公司正在推动OpenSBI与EDK2的集成。该集成已经适用于U540和Xilinx VC707 FPGA平台,OpenSBI在EDK2的Pre-EFI Initialization (PEI)阶段作为库来使用。

EDK2集成的详细说明

- EDK2 mailing list上已有集成的OpenSBI内容可供参考。

- OpenSBI与EDK2构建环境兼容,并作为PEI阶段的一部分使用。这种集成极大增强了OpenSBI与EDK2固件的合作,尤其在高性能嵌入式系统中使用RISC-V的环境下。

Constraints on using OpenSBI as a Library

当OpenSBI作为外部固件的库使用时,存在一些必须遵守的限制条件和技术要求,以确保正确的运行。

编译选项要求

- 相同的GCC目标选项:必须为外部固件和OpenSBI使用相同的GCC目标编译选项,包括:

-march:指定RISC-V指令集架构的版本和扩展。-mabi:定义应用二进制接口(ABI),确保外部固件与OpenSBI之间的函数调用兼容。-mcmodel:指定内存模型,控制生成代码时的内存寻址方式。

外部固件必须为每个HART创建独立的堆栈和scratch空间

- 程序堆栈(Program Stack):外部固件需要为每个HART配置一个独立的堆栈,避免不同HART之间的堆栈冲突。

- OpenSBI scratch空间:外部固件必须为每个HART设置OpenSBI的scratch空间,通常是通过

struct sbi_scratch结构体来实现。

使用OpenSBI函数的约束

调用OpenSBI的函数时,外部固件需要遵守以下限制:

- MSCRATCH寄存器:必须为每个调用HART将其MSCRATCH寄存器设置为其专属的OpenSBI scratch空间。

- SP寄存器:调用HART的栈指针(SP)必须设置为该HART的独立堆栈空间,确保各HART之间不会干扰彼此的堆栈。

其他要求

外部固件还必须确保以下条件:

- 中断状态:在调用

SBI函数时,必须禁用MSTATUS和MIE寄存器中的中断位,以避免中断干扰函数执行。 - sbi_init()的调用:必须为每个HART在系统启动时或HART热插拔事件中调用

sbi_init(),以正确初始化。 - sbi_trap_handler()的调用:当发生机器模式(M-mode)中断或陷阱时,必须调用

sbi_trap_handler(),以确保能够正确处理这些异常情况。

Current Status

RISC-V启动生态系统正在快速发展,预计在 (2019) 年末之前将实现完整的传统启动流程支持。以下是当前的进展情况:

OpenSBI

- 积极开发与维护:OpenSBI作为RISC-V架构的关键组件之一,正在被持续开发和维护。

- 版本 0.5 已发布:最新版本具备更完善的功能和优化。

- 默认使用:在多种构建工具中,OpenSBI已经成为默认的BIOS接口,例如Buildroot、Yocto、OpenEmbedded和QEMU BIOS。

- 镜像可用:Fedora和Debian的RISC-V系统镜像已经包含了OpenSBI的二进制文件。

U-Boot

- U-Boot-2019.10 发布:该版本已经完全支持HiFive Unleashed S模式。

- 支持网络和MMC引导:该版本支持通过网络和MMC卡引导操作系统。

- FIT镜像支持:U-Boot支持FIT镜像加载,它包含了内核、设备树、RAM盘等多个组件。

- EFI支持:为RISC-V架构提供了EFI支持,进一步增强了启动灵活性。

Grub

- 上游支持RISC-V:Grub已经在上游版本中提供了对RISC-V的支持,能够加载Linux内核。

Linux Kernel

- 内核主线支持QEMU引导:上游Linux内核可以在QEMU中正常启动。

- 设备树集成:RISC-V的设备树已经集成在Linux内核中,支持多种硬件配置。

- v5.3内核:Linux 5.3版本可以与OpenSBI和U-Boot配合,在HiFive Unleashed板上正常工作。

Future Boot Support

未来,RISC-V的启动支持将进一步扩展,目标是构建一个稳定、易用的启动生态系统。以下是未来的启动支持方向:

EFI Stub支持

- Linux内核中的EFI Stub支持:正在开发中,目标是提供完整的UEFI支持。这将为RISC-V带来企业级的启动环境,确保兼容更多高级功能。

U-Boot SPL 支持 HiFive Unleashed

- HiFive Unleashed的U-Boot SPL支持:正在开发中,未来可以通过SPL引导HiFive Unleashed板的操作系统。

Coreboot中的SMP支持

- 多处理器支持:Coreboot正在开发对SMP(对称多处理)支持,以便在多核系统中更好地管理硬件资源。

EDK2项目上游集成

- 持续进行的EDK2集成:OpenSBI与EDK2的集成正在逐步上游化,进一步扩展RISC-V的固件支持。

Oreboot

- 基于Rust的Coreboot:Oreboot项目是用Rust编写的Coreboot版本,目标是为RISC-V提供更加安全和可靠的固件解决方案。

LinuxBoot和其他引导加载程序

- LinuxBoot?:未来可能会为RISC-V提供LinuxBoot的支持,使启动流程更加简化和灵活。

- 其他引导加载程序?:随着RISC-V的生态系统不断发展,未来可能会出现更多的引导加载程序,进一步丰富启动选项。

通过这些即将到来的支持,RISC-V的启动流程将变得更加多样化和稳定,为开发者提供更灵活的工具链和启动选项,适应从嵌入式系统到高性能计算的广泛应用场景。

Ongoing Work

为了构建一个稳定且易于使用的RISC-V启动生态系统,当前有多个方面的工作正在进行中。这些工作涵盖了SBI规范的更新、OpenSBI的改进、以及Linux内核的持续开发。

SBI Specifications

- SBI v0.2 规范:新版SBI v0.2规范正在制定中,将带来更多改进和扩展。

- Hart状态管理扩展:在SBI v0.2中,将引入对Hart(硬件线程)状态管理的扩展,以便更好地控制和管理系统中的各个Hart。

- 替换旧版SBI扩展:SBI的遗留扩展将被更现代的功能替代,进一步优化性能和兼容性。

OpenSBI

- 通过CPU热插拔实现顺序CPU启动:改进OpenSBI以支持CPU热插拔,允许系统在运行时动态启动或关闭CPU。

- 支持其他M-mode引导加载程序:OpenSBI正在扩展以支持其他机器模式(M-mode)的引导加载程序,例如Coreboot和U-Boot SPL。

- 虚拟化支持:当SBI规范发生变化时,OpenSBI将增加对虚拟机管理程序(Hypervisor)的支持。

- 更多平台支持:OpenSBI计划扩展支持更多硬件平台,但这些扩展需要额外的硬件支持。

Linux Kernel

- SBI v0.2实现:SBI v0.2规范的实现正在进行中,补丁正在审查过程中。

- EFI stub的支持:EFI stub正在内核中开发,旨在提供完整的UEFI支持,这对企业级应用至关重要。

- 替换旧版SBI扩展:与OpenSBI一样,Linux内核也在逐步替换SBI的遗留扩展。

- 顺序启动:内核将支持顺序启动功能,确保系统能够按需有序地启动。

- CPU热插拔支持:内核正在开发对CPU热插拔的支持,以实现更灵活的系统资源管理。

Acknowledgements

在RISC-V启动生态系统的开发过程中,多个团队和个人做出了重要贡献。以下是对这些贡献者的感谢:

U-Boot

- Lukas Auler

- Bin Meng

- Anup Patel

Coreboot

- Ron Minnich

- Jonathan Neuschäfer

- Patrick Rudolph

- Philip Hug

EDK2

- Abner Chang

其他贡献者

- 感谢所有为RISC-V启动流程做出贡献的开发者和社区成员,他们的努力推动了整个生态系统的前进。

这些开发者和团队通过持续的贡献,使得RISC-V启动流程更加成熟,进一步推动了开源硬件平台的普及和发展。

Reference

© 2019 Western Digital Corporation or its affiliates. All rights reserved. 12/19/19

More

The future of RISC-V Supervisor Binary Interface(SBI) - Atish Patra - Western Digital

OpenSBI Deep Dive - Anup Patel - Western Digital

【翻译】RISC-V SBI and the full boot process

原文作者: @popovicu

原文链接: RISC-V SBI and the full boot process

版权声明: 本文为 @popovicu 的原创作品。本文的翻译仅供学习参考,更多详细信息请访问原文链接。

RISC-V SBI 和完整的启动过程

发表于:2023年9月9日 | 晚上09:00

在上一篇文章中,我们讨论了RISC-V上的裸机编程。在继续阅读本文之前,请先熟悉之前的内容,因为本文是对前述文章的直接延续。

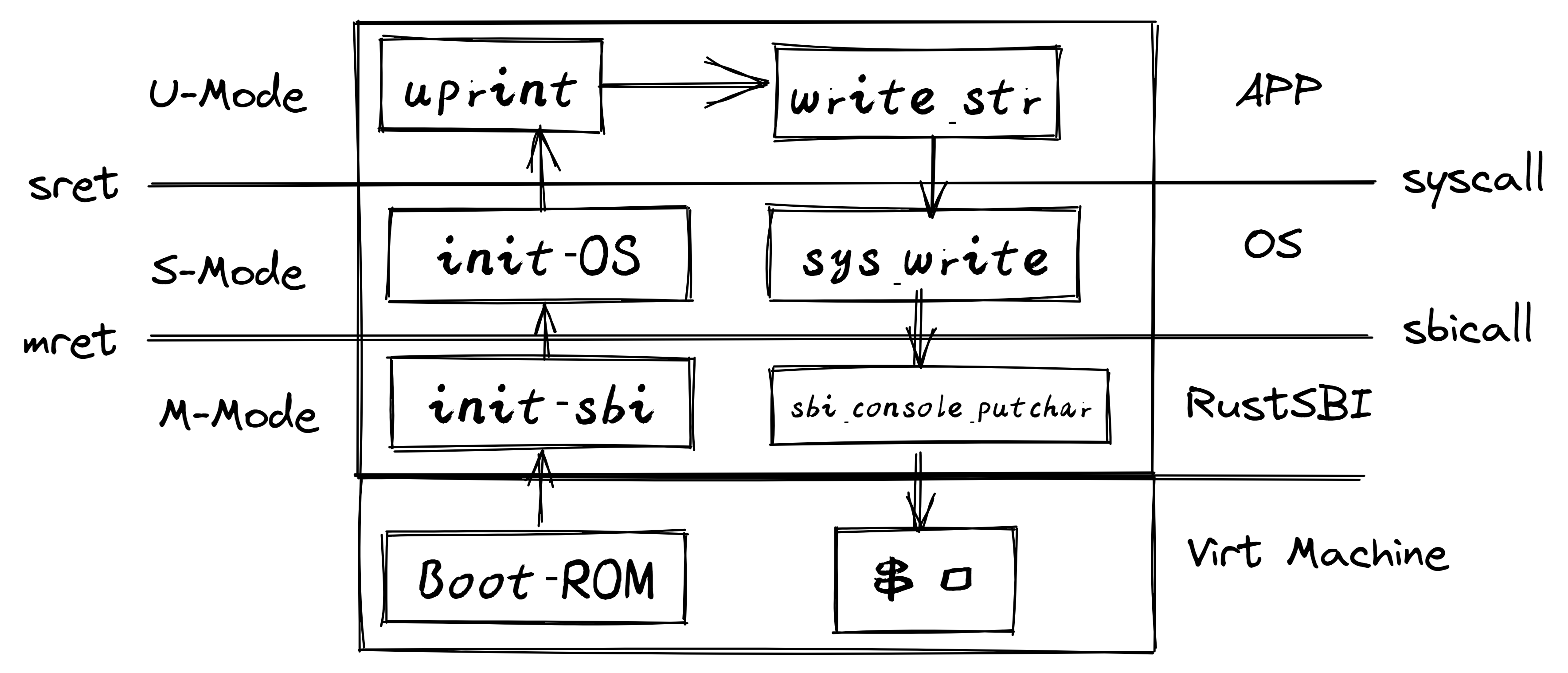

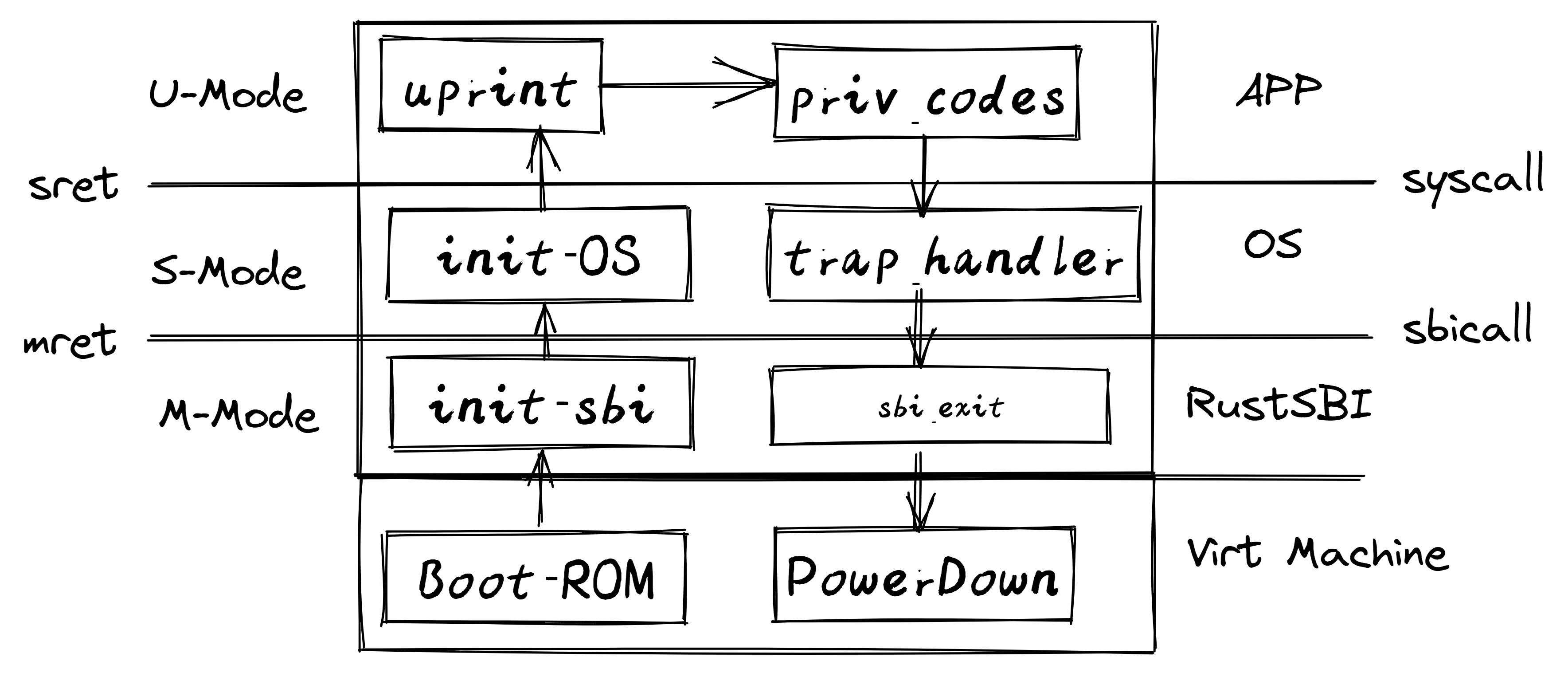

这次我们将讨论 RISC-V 的 SBI(Supervisor Binary Interface,监督者二进制接口),并以 OpenSBI 作为示例。我们将探讨 SBI 如何帮助我们实现操作系统内核的基本功能,并以 riscv64 virt 机器为例结束本文。

RISC-V 和“BIOS”

在前文中,我们详细讨论了 RISC-V 启动过程的最初阶段。我们提到,首先运行的是 ZSBL(零阶段引导加载程序),它初始化一些寄存器并跳转到 ZSBL 硬编码的地址。在 QEMU 的 riscv64 virt 虚拟机中,这个硬编码的地址是 0x80000000。这就是用户提供的代码首次运行的地方,默认情况下,QEMU 会在这里加载 OpenSBI。

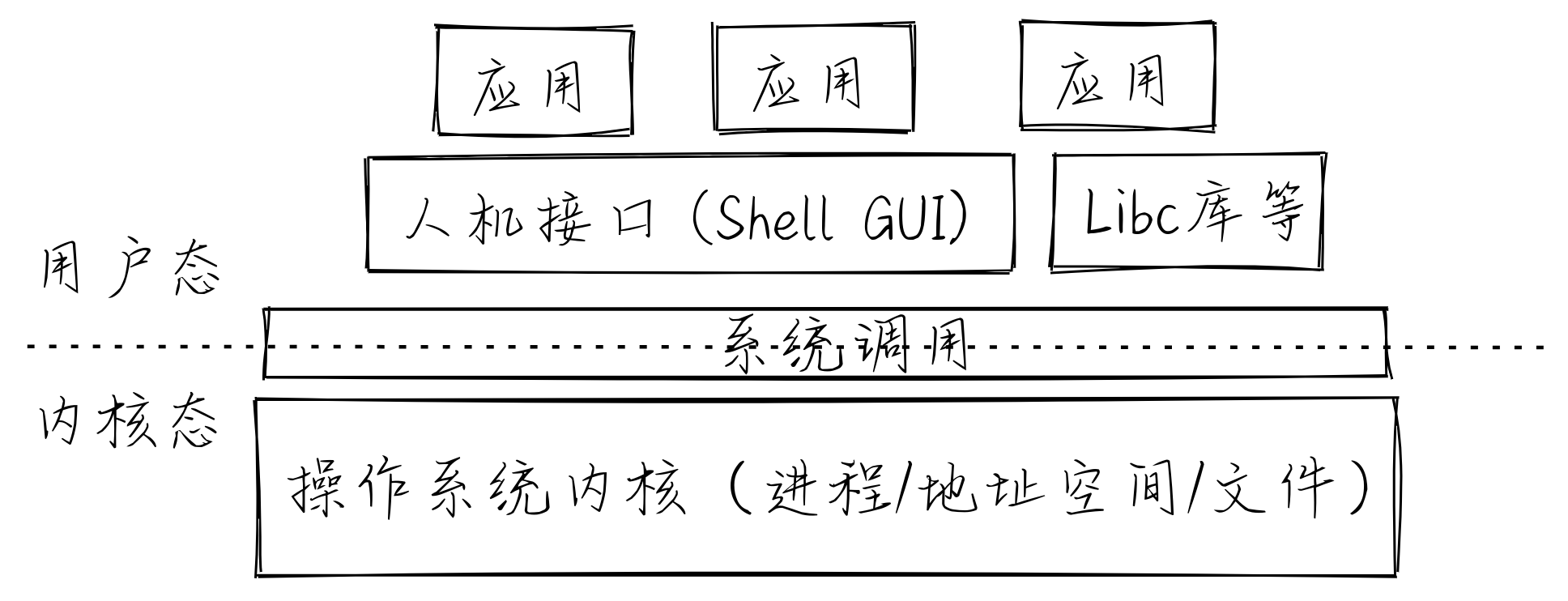

机器模式

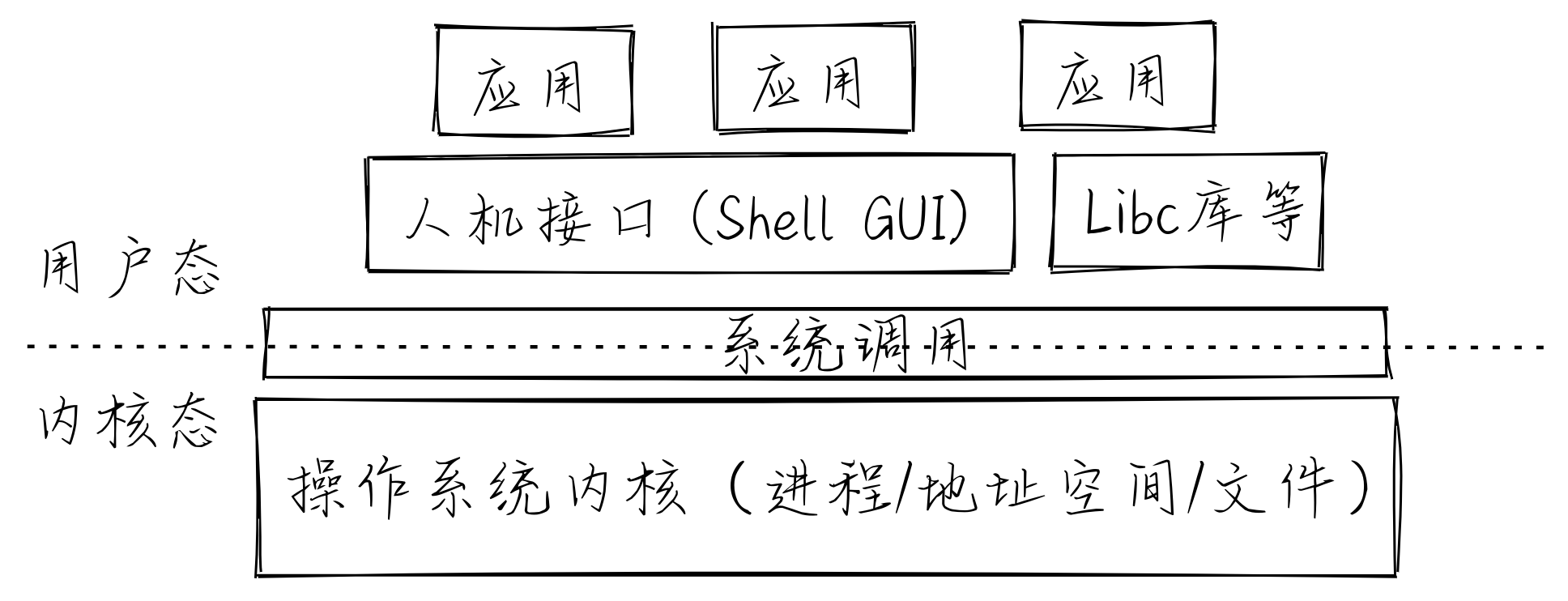

到目前为止,我们避免讨论不同的机器模式,现在是引入它们的最佳时机。机器模式的概念在于,并不是每个软件都应该能够访问机器上的任意内存地址,甚至不是所有的指令都应该被 CPU 执行。传统的教科书示例中,通常有两种主要的权限划分:

- 特权模式

- 非特权模式

特权模式 是机器在启动时的模式。此时允许执行任何指令,且没有地址访问违规的概念。一旦操作系统接管系统控制并开始执行用户代码(即用户空间代码),模式就会开始切换。当用户代码在 CPU 核心上运行时,它是在 非特权模式 下运行,此时并不能访问所有资源。返回内核模式意味着切换回特权模式。

这是操作权限的一种非常教科书化的简化视角,但问题来了:为什么只有两种模式?

在系统中,通常有超过两种模式,形成多个访问模式的保护环。RISC-V 规范并没有明确规定一个核心必须实现哪些模式,除了 M(机器)模式,这是最具特权的模式。

通常,只有 M 模式的处理器是简单的嵌入式系统,而更安全的系统会支持 M 和 S 模式,直到可以运行类似 Unix 操作系统的完整系统(支持 M、S 和 U 模式)。

SBI

官方文档 提供了正式定义,我将在此对其进行简化解释,以帮助更直观地理解。

RISC-V 的 SBI 规范定义了 RISC-V 软件栈底层的软件层。这非常类似于 BIOS,后者通常是机器上运行的第一段软件。你可能看到过一些从零开始开发简单内核的指南,它们通常涉及与我们在RISC-V裸机编程指南中所做的类似操作,带有一点不同——它们往往依赖于一些预先存在的软件来完成某些 I/O 操作。与我们之前的指南相似之处在于,它们也仔细对齐了第一条指令的地址,以确保处理器的执行流程按预期进行,并且简单的内核能够在正确的时间接管。然而,我通常在这些简短的指南中观察到,目标通常是向VGA屏幕打印类似‘Hello world’的东西。最后这一点看起来相当复杂,事实上确实如此。

那么,如何轻松地向 VGA 打印内容呢?答案是 BIOS 在这里帮助我们完成最基本的 I/O 操作,例如向屏幕上打印字符,因此它被称为 Basic Input Output System(基本输入输出系统)!请注意裸机编程指南的开头部分:我们是在没有依赖于机器上任何现有软件的情况下与用户交互的(严格来说,这并不完全正确,我们仍然通过了零阶段引导加载程序,但我们并不依赖于它的任何结果,也无法真正控制它;它是系统中硬编码的)。如果我们要在 VGA 屏幕上打印内容,而不是通过 UART 发送字符,我们将需要做的不仅仅是向某个地址发送 ASCII 码。VGA 需要通过发送多个值来设置显示设备,配置不同的参数等。这是一个相当复杂的操作。

那么 BIOS 通常如何帮助处理这些任务?主要的概念是,无论最终在机器上安装了什么操作系统,它都需要一些基本功能,比如向 VGA 屏幕打印信息。因此,机器可以将这些标准操作预先集成到系统中,供任何操作系统使用。从概念上讲,我们可以将这些过程视为我们应用程序编写时所依赖的日常库。

此外,如果操作系统是针对这样的“库”编写的,它将自动变得更加可移植。“库”应该包含所有底层细节,例如“输出到 UART 意味着写入 0x10000000”(在 QEMU 的 riscv64 virt 虚拟机中),与“输出到 UART 意味着写入 0x12345678”相比,操作系统只需要调用“输出到 UART”的过程,而这个“库”将知道如何与硬件进行交互。

精妙的抽象

这些讨论归根结底是编程中从第一天就开始使用的一个非常简单的概念:我们在编程中应用了抽象层。想象一下,一个 Python 函数执行类似“将本地文件发送到电子邮件地址”的操作。从高层视角看,我们只是简单地调用一个函数 send_file_to_email(file, email),然后底层的库会打开网络连接并开始传输字节。这可能是另一个 Python 库。在某个时刻,这个操作可能会下移到软件栈的底层,Python 库将依赖于用 C 语言编写的 Python 运行时,后者通过系统调用操作系统来执行核心操作(例如打开网络套接字)。操作系统的深处有一个网络驱动程序,它知道应该将字节发送到地址空间中的哪个地址,以便将字节通过网络传输出去。这里的主要概念是,我们已经建立了一种隐藏操作复杂性的方式,通过将它们委托给软件栈的底层来处理。我们并不是从原子部分构建更大的系统,而是从“分子”构建。

如果我们将复杂性委托给底层库,这可能只是一个函数调用。然而,一旦需要将复杂性委托给操作系统及以下层次,这就会通过一个二进制接口来实现。

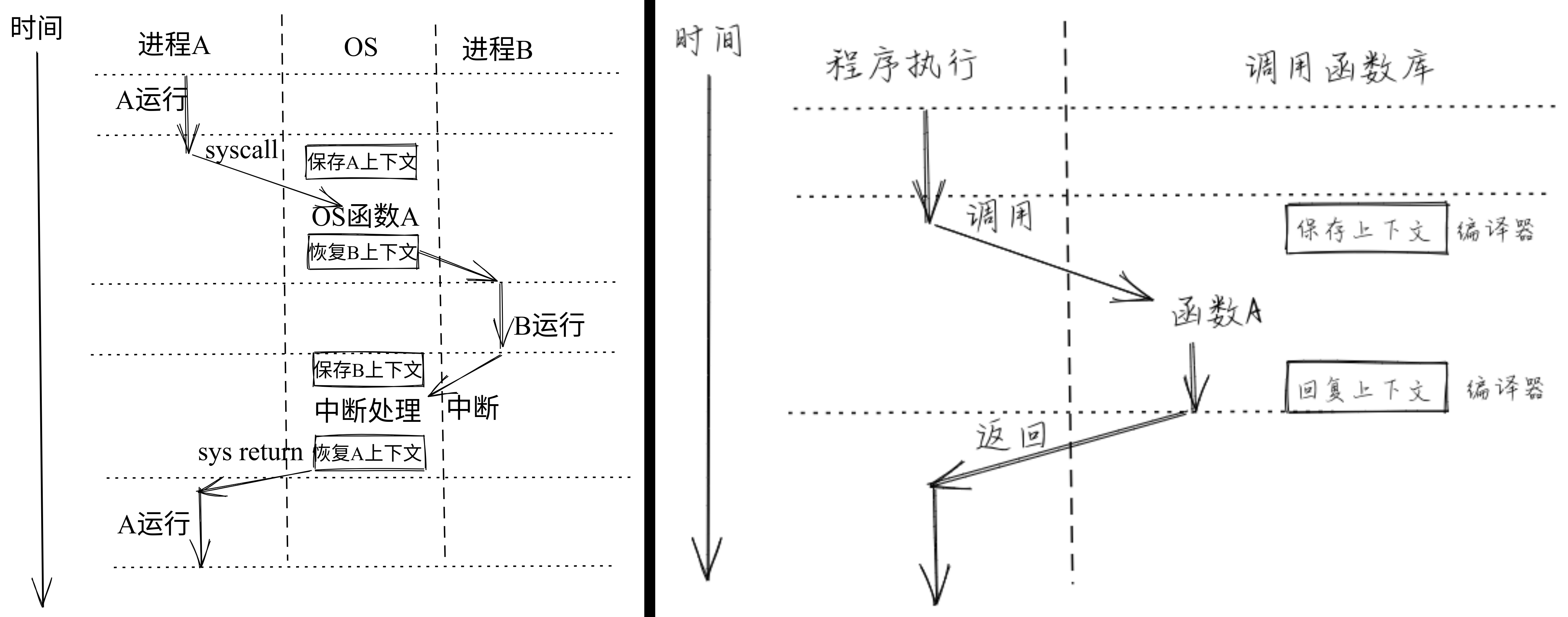

二进制接口

自从计算机开始广泛使用以来,x86 架构一直是我们使用的台式机或笔记本电脑的主导架构。近年来,情况发生了很大变化,其他架构开始进入我们的视野,但让我们暂时集中于 x86。那么,是什么使为 Linux 构建的应用程序与 Windows 的应用程序不兼容呢?如果它是为 x86 编写的,并且 Linux 和 Windows 都运行在 x86 上,那么差异究竟在哪里?CPU 指令并没有因平台不同而改变,那么原因是什么呢?答案是应用程序和操作系统之间的接口。用户软件与操作系统之间的这个特定链接称为应用二进制接口(ABI)。ABI 只是一个定义,规定了如何从用户应用程序调用操作系统的服务。

因此,当我们说“这个软件是为平台 X 编写的”时,仅仅说 X 是 x86 或 RISC-V 还不够,我们必须明确说 x86/Linux 或 x86/Windows 或 RISC-V Linux 等。如果涉及动态链接,平台定义甚至可能更加复杂,但我们暂且不讨论这个问题。

让我们来看一个用汇编语言为 x86/Linux 编写的程序的简单例子,该程序只是将‘Hello’字符串打印到标准输出。

.global _start

.section .text

_start: mov $4, %eax ; 4 是 'write' 系统调用的代码

mov $1, %ebx ; 我们正在写入文件 1,即 '标准输出'

mov $message, %ecx ; 我们要打印的数据位于 message 符号定义的地址

mov $5, %edx ; 我们要打印的数据长度是 5

int $0x80 ; 调用系统调用,即请求内核将数据打印到标准输出

mov $1, %eax ; 1 是 'exit' 系统调用的代码

mov $0, %ebx ; 0 是进程的返回码

int $0x80 ; 调用系统调用,即请求内核关闭该进程

.section .data

message: .ascii "Hello"

用以下命令汇编该程序:

as -o syscall.o syscall.s

链接:

ld -o syscall syscall.o

运行:

./syscall

你应该会看到输出“Hello”。如果你使用的是 Bash,并且想要检查进程的返回码,可以运行:

echo $?

你应该会看到 0。

提示:如果你没有 x86/Linux 机器,但想尝试上面的例子,可以通过一个模拟 x86 系统的 JavaScript 虚拟机来实现这里;这是一个非常酷的网站!

这样我们就得到了一个在 x86 机器上运行并在 Linux 内核下打印消息的程序。没有使用 C 标准库。最终生成的 ELF 二进制文件应该能够在 Linux 上运行,唯一的依赖条件是它运行在正确的平台上。

现在回到问题本身,是什么可能使这个二进制文件与 Windows 不兼容?不同的操作系统以不同的方式编码系统调用(例如,写入操作的代码在 Linux 是 4,而在 Windows 可能是 123,或者参数通过不同的 CPU 寄存器传递)。 现在你对如何直接与内核交互有了更好的理解,而不依赖标准库(尽管你几乎不会想这么做)。这意味着你已经揭示了软件执行诸如打开文件、分配内存、发送信号等操作的那一层。C 标准库可以看作是一个封装器,它隐藏了通过 int 指令调用软件中断与内核通信的复杂性,而是使其看起来像一个正常的 C 函数调用,但实际上它的底层机制就是这样。公平地说,库做的远不止这些,但对于本文的目的,可以简单地将其视为一个封装器。

现在在 RISC-V 的世界里,情况也是类似的:用户应用程序通过软件中断的 CPU 指令与内核交互,并通过 CPU 寄存器传递参数。而内核则通过 SBI 来调用它的服务,执行的方式完全相同!不同之处在于,这一层的逻辑调用被称为 SBI,而不是 ABI。可以把它理解为,这不是应用程序在工作,而是应用程序的监督者在工作。名称不同,概念却是完全一致的。

使用 OpenSBI 的实际示例

到此为止,我们已经明确了,SBI 和 ABI 类似,都是调用软件栈底层功能的一种方式。同时我们也明确了,SBI 处于 RISC-V 机器的软件栈的最底层,并在最具特权的 M 模式下运行。现在让我们进一步补充一些细节。

现在应该可以理解为什么 QEMU 开发者选择使用 -bios 标志来接受 SBI 软件镜像(因为其功能与 BIOS 基本相同)。需要提醒的是,-bios 标志应该指向一个 ELF 文件,该文件将从地址 0x80000000 开始布局 SBI 软件。

让我们在仅加载 OpenSBI 的情况下启动 QEMU 的虚拟机,看看会发生什么。我们不需要传递任何参数给 QEMU,因为默认情况下它会将 OpenSBI 加载到 0x80000000。

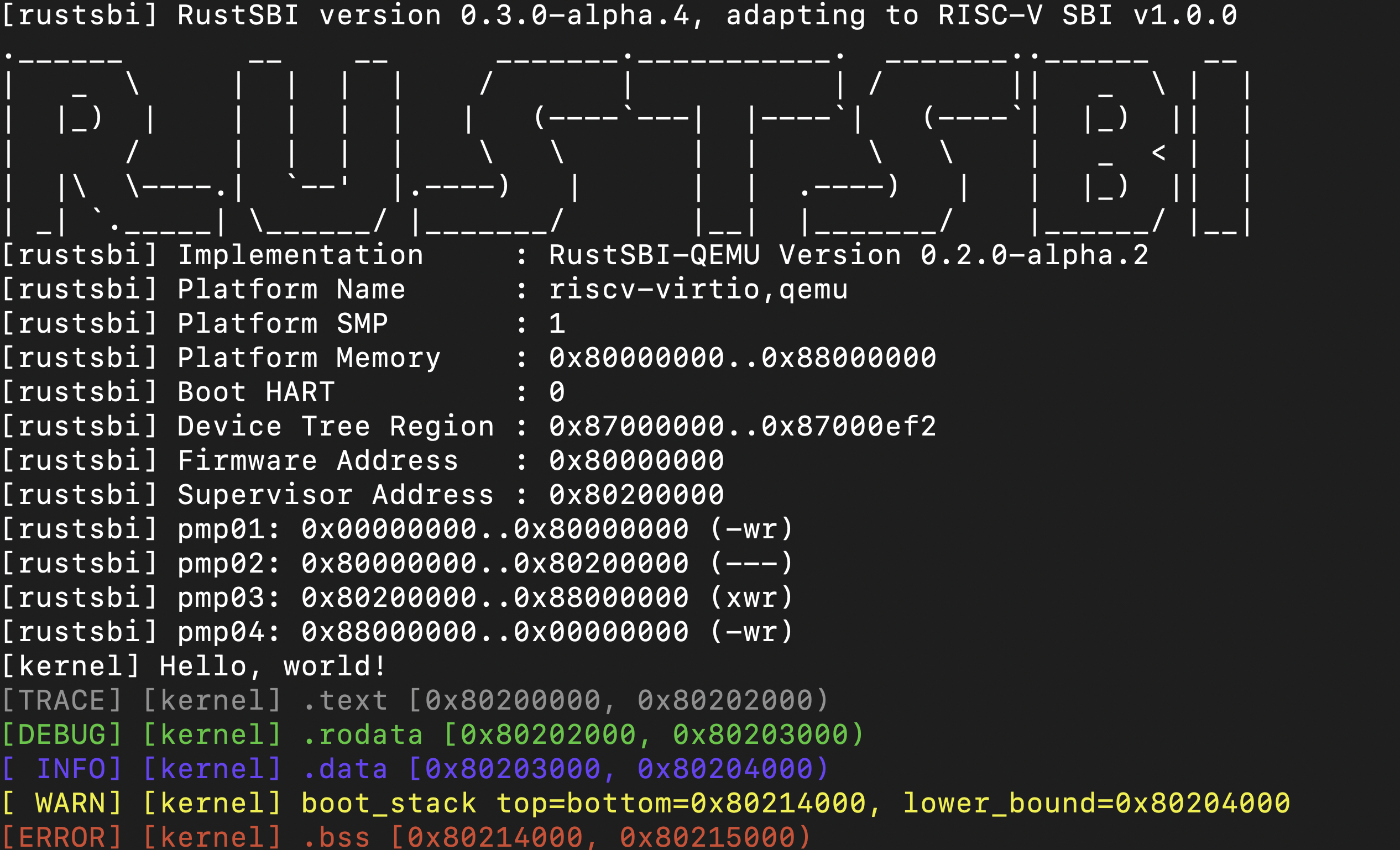

qemu-system-riscv64 -machine virt

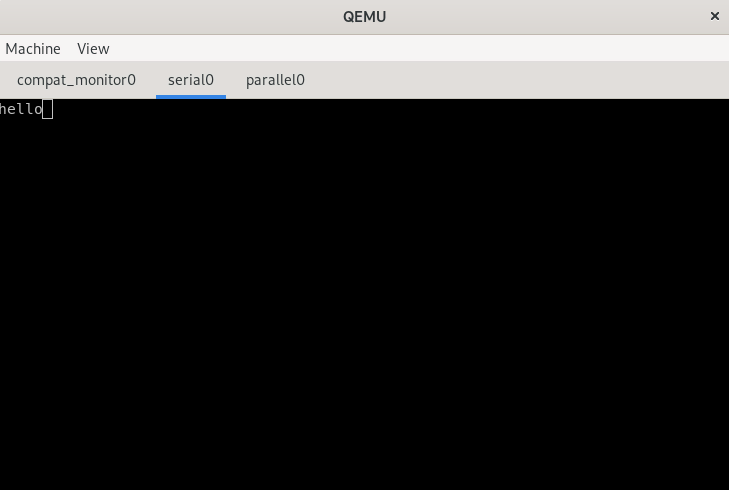

这是输出(在串行端口上,不是 VGA):

OpenSBI v0.8

____ _____ ____ _____

/ __ \ / ____| _ \_ _|

| | | |_ __ ___ _ __ | (___ | |_) || |

| | | | '_ \ / _ \ '_ \ \___ \| _ < | |

| |__| | |_) | __/ | | |____) | |_) || |_

\____/| .__/ \___|_| |_|_____/|____/_____|

| |

|_|

Platform Name : riscv-virtio,qemu

Platform Features : timer,mfdeleg

Platform HART Count : 1

Boot HART ID : 0

Boot HART ISA : rv64imafdcsu

BOOT HART Features : pmp,scounteren,mcounteren,time

BOOT HART PMP Count : 16

Firmware Base : 0x80000000

Firmware Size : 96 KB

Runtime SBI Version : 0.2

MIDELEG : 0x0000000000000222

MEDELEG : 0x000000000000b109

PMP0 : 0x0000000080000000-0x000000008001ffff (A)

PMP1 : 0x0000000000000000-0xffffffffffffffff (A,R,W,X)

虚拟机就这样一直运行下去,可能是因为默认情况下它被设置为这样运行,因为没有其他软件传递给 QEMU 来在 OpenSBI 之后接管控制。此时看来一切正常,OpenSBI 已经成功设置(其输出也确认它位于 0x80000000)。

接下来我们如何继续扩展软件栈呢?新的一层可以是操作系统内核,因此类似于我们之前构建的包含指令的 ELF 文件,它被放置在 0x80000000,我们将构建另一个 ELF 文件,供 QEMU 加载到内存中,但这次指令将加载到另一个地址,因为从 0x80000000 开始的部分已经被 OpenSBI 占用。

那么,我们应该将这个“虚拟内核”加载到哪个地址呢?

在 SBI 之后启动操作系统内核并调用 OpenSBI

当我们加载 BIOS/SBI/无论你想怎么称呼它时,这个地址基本上是“写死”在机器逻辑中的。最初的几条指令是零阶段引导加载程序(ZSBL),它的最后一条指令跳转到硬编码的地址 0x80000000。正如我们之前提到的,这是我们所使用的平台的不可更改的事实,它就是这样工作的。然而,这就是它目前所硬编码的全部内容:它只是硬编码了你必须从 0x80000000 开始,而我们现在已经在这里放置了 OpenSBI,那么 OpenSBI 接下来将带我们到哪里呢?

这时,ZSBL 的重要性再次出现了,现在它如何在执行跳转到 0x80000000 之前初始化这些寄存器真的很关键。ZSBL 实际上做了两件事:

- 确保在 OpenSBI 初始化后运行的软件可以运行,这基本上是操作系统内核的引导加载程序,或者直接是内核本身(这就是你在 QEMU 指南中启动 Linux 时通常看到的,跳过引导加载程序,内存中直接加载内核)。

- 跳转到 OpenSBI。

我们已经详细讨论了第二点,现在让我们深入探讨它如何完成第1点。

ZSBL 中究竟发生了什么?

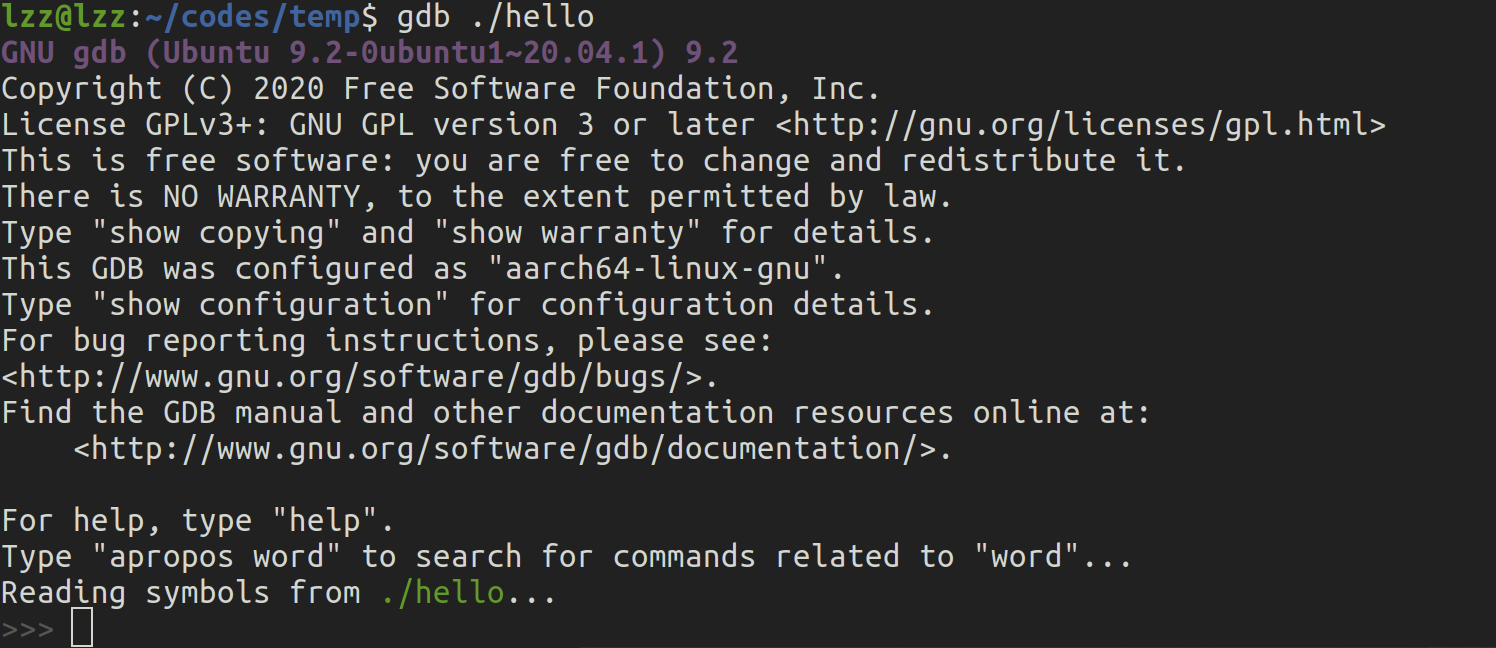

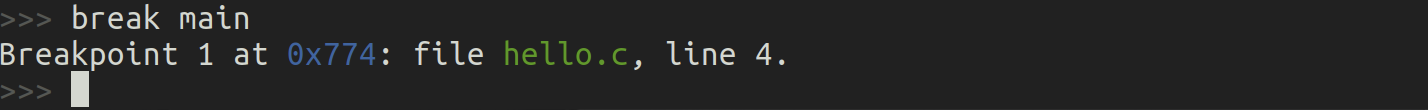

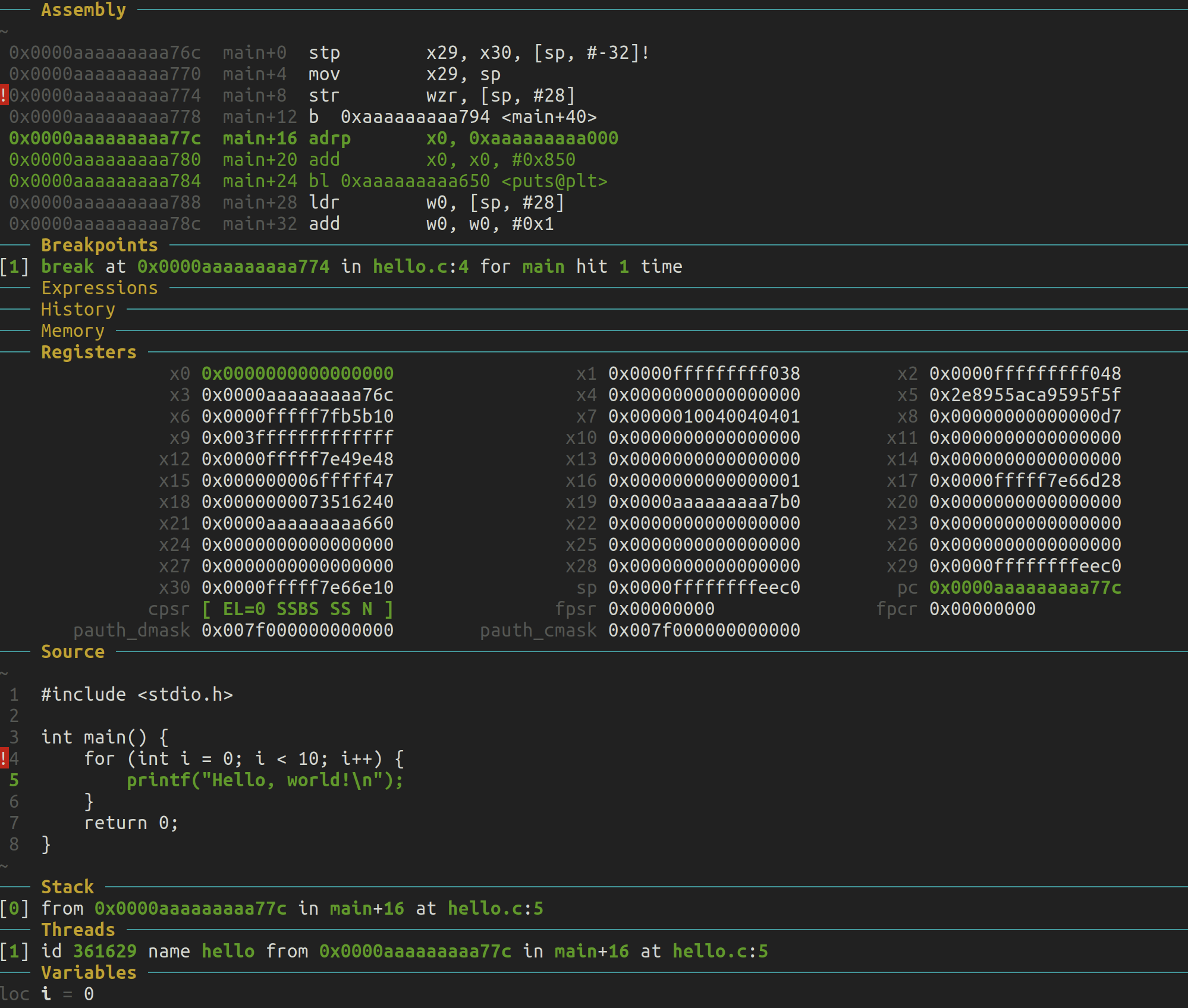

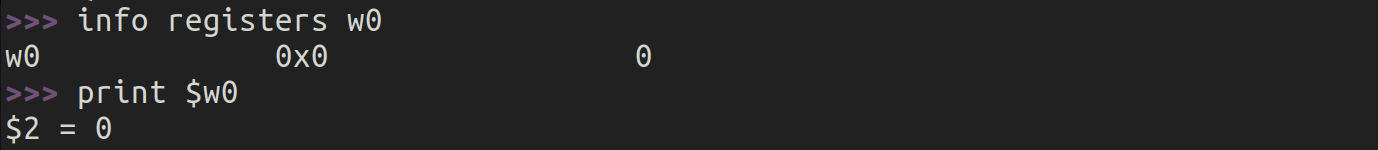

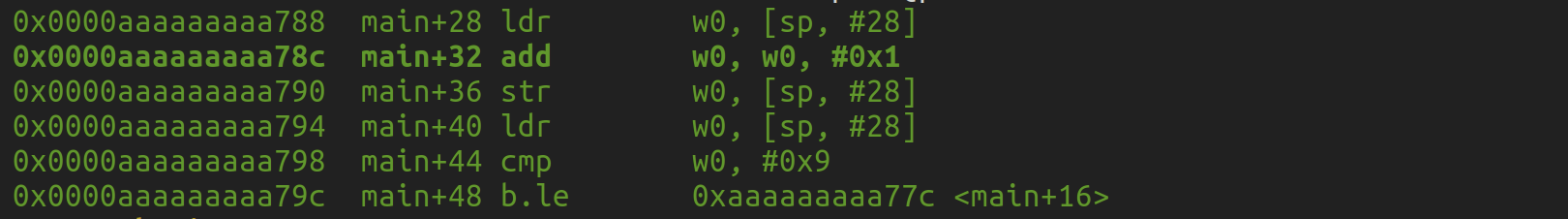

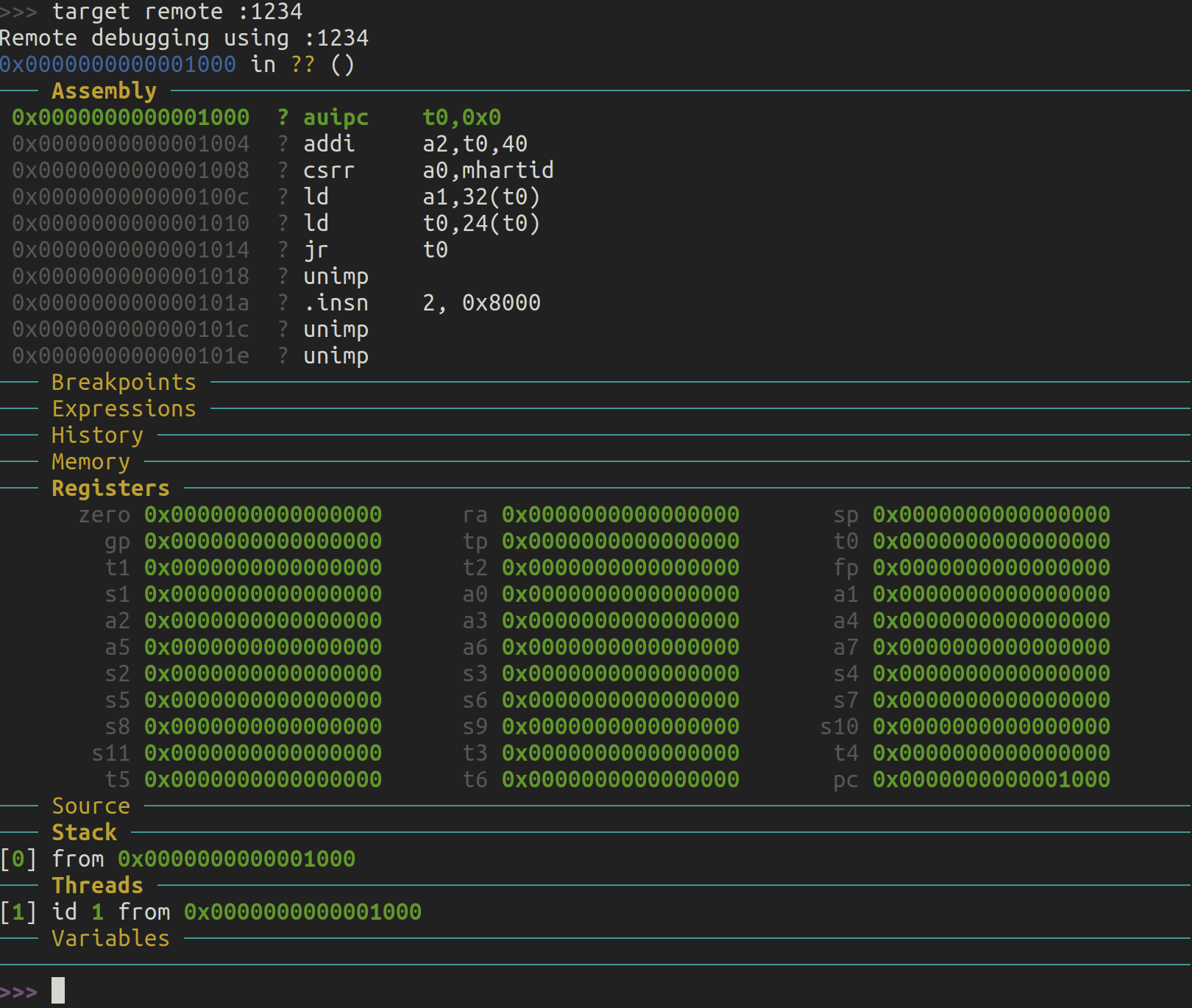

我们之前提到 ZSBL 的执行从地址 0x1000 开始。让我们通过 QEMU 跟踪执行情况,看看发生了什么。为此,我们将在 QEMU 命令行中添加两个标志:-s 和 -S。这些标志确保 QEMU 暴露一个 gdb 调试端口,并且虚拟机在创建时立即暂停,等待我们通过 gdb 手动驱动它。

我们现在开始这个逆向工程的过程。我们首先启动 QEMU:

qemu-system-riscv64 -machine virt -s -S

在另一个终端中,我们连接到嵌入在 QEMU 中的 gdb 服务器,以便控制虚拟机的执行。我是在 x86 机器上执行的,所以我会使用 gdb-multiarch 来进行跨平台的 riscv 调试。在这个新的终端中,我运行以下命令:

gdb-multiarch

在连接到虚拟机之前,我想先设置几件事:

set architecture riscv:rv64

这行命令的作用显而易见。接下来,我希望每次执行一条指令时都能在终端中打印出实际的运行指令:

set disassemble-next-line on

现在是时候连接到 QEMU 的 gdb 服务器了(端口 1234 基本上是 QEMU 的默认设置,虽然可能可以通过 -s 标志进行某种方式的配置;不过我从未尝试过,也认为你不需要改变这个行为)。

target remote :1234

此时,gdb 正在等待我们,它停在了地址 0x1000,这是系统上电后执行的第一条指令的地址。我们将使用 si 多次单步执行指令,直到我们跳转到位于 0x80000000 的 SBI。

(gdb) target remote:1234

Remote debugging using :1234

warning: No executable has been specified and target does not support

determining executable automatically. Try using the "file" command.

0x0000000000001000 in ?? ()

=> 0x0000000000001000: 97 02 00 00 auipc t0,0x0

(gdb) si

0x0000000000001004 in ?? ()

=> 0x0000000000001004: 13 86 82 02 addi a2,t0,40

(gdb) si

0x0000000000001008 in ?? ()

=> 0x0000000000001008: 73 25 40 f1 csrr a0,mhartid

(gdb) si

0x000000000000100c in ?? ()

=> 0x000000000000100c: 83 b5 02 02 ld a1,32(t0)

(gdb) si

0x0000000000001010 in ?? ()

=> 0x0000000000001010: 83 b2 82 01 ld t0,24(t0)

(gdb) si

0x0000000000001014 in ?? ()

=> 0x0000000000001014: 67 80 02 00 jr t0

(gdb) si

0x0000000080000000 in ?? ()

=> 0x0000000080000000: 33 04 05 00 add s0,a0,zero

在 ZSBL 中只有 6 条指令,之后控制权就交给了 OpenSBI,包含跳转指令。然而,这几条指令的意义是什么呢?

事实证明,这也是 SBI 规范的一部分,它是启动序列的一部分。然而,对于 OpenSBI,有三种不同的实现方式,在我们深入讨论 ZSBL 之后发生的事情之前,先来看看这些不同的实现方式。

OpenSBI 的三种实现方式

你可以通过三种不同的方式构建 OpenSBI:

FW_PAYLOAD

这个方式概念上最容易理解。构建这个版本的 OpenSBI 时,你会将 make 工具指向你的内核或“你希望在 OpenSBI 之后运行的任何软件”镜像,然后你将获得一个可以直接加载的单一二进制文件。在 QEMU 的虚拟机中,地址为 0x80000000。据我了解,可以调整你的软件在内存中与 OpenSBI blob 相关的位置,但为了简化起见,我们可以认为 OpenSBI 和你的软件被组合在一起成一个单一的 blob,一旦 OpenSBI 初始化完成,下一条指令就是你的软件(基本上 OpenSBI 之后直接过渡到你的软件)。

实现这个的方式是:

- 确保在

make过程中设置FW_PAYLOAD=y,这将确保生成一个名为fw_payload的文件。 - 在

make过程中设置FW_PAYLOAD_PATH,指向你希望在 OpenSBI 之后运行的软件。

根据上面链接的文档,如果你省略了第二个标志,OpenSBI 会与一个非常简单的无限循环软件一起拼接。这就解释了为什么当我们只启动 QEMU 而不加任何标志时,机器基本上只是原地打转——OpenSBI 很可能就是这样构建的(因为你不能继续执行随机的内存内容),它只是忙于原地等待。

这种方式的优点在于,现在你有了一个单一的、拼接的、整体的软件镜像,可以加载到你的机器中。你不需要处理多个独立的软件块,只需处理一个整体。如果你的软件构建过程比较简单,你甚至可能最终找到一种非常简单的方式来管理目标机器上的所有软件,同时还能享受 OpenSBI 为你提供的一些工作便利。

缺点是,现在你需要负责将所有东西拼接在一起,包括 OpenSBI。更糟的是,如果机器已经有了 OpenSBI,例如,烧录在某个 ROM 中,它已经有了启动 OpenSBI 的能力,重复加载 OpenSBI 可能会导致问题。

FW_JUMP

这种方式也相对简单:你基本上将 OpenSBI 之后的软件地址硬编码。类似于上述情况,也需要两步。

- 确保在

make过程中设置FW_JUMP=y,这将生成一个名为fw_jump的文件。 - 在

make过程中设置FW_JUMP_ADDR,指向 OpenSBI 完成后跳转的地址。

这与前一种情况非常相似,只是跳转地址是硬编码的。在这种情况下,你仍然需要负责构建 OpenSBI 镜像,但它易于重建,并且可以针对不同的机器指向不同的地址(例如,具有不同内存布局的机器)。

FW_DYNAMIC

这是最通用的方式,因此我们最后讨论这一种。在这种方式中,ZSBL 中寄存器设置的重要性开始显现出来。

在这种模式下,OpenSBI 之前的启动阶段负责向 OpenSBI 传递一些指针。在这个例子中,当然是 ZSBL。如果我们仔细观察,会看到它修改了寄存器 a2。

在这里,我鼓励读者阅读这篇文章中的 ZSBL 部分。整篇文章都很棒,只是我一开始觉得它有点难以理解,所以可以把本文看作是理解那篇文章的预备知识,值得花时间去阅读。

简单来说,ZSBL 设置 a2 寄存器的意义是什么?它指向一个 struct fw_dynamic_info 结构,这为动态 OpenSBI 提供了继续启动过程的方式!实际上,这个结构中的一项数据是 OpenSBI 之后运行的软件的地址。一个很好的问题是:在真实机器上,谁来填充这个结构?根据我们将看到的内容,显然 QEMU 会将该内容硬编码到内存中,这一逻辑并不是 ZSBL 的一部分,但我可以想象,在某些设备上 ZSBL 实际上会填充这个结构并传递给 OpenSBI。

来自西部数据的一名工程师的演讲的第17页(他可能是 OpenSBI 的核心贡献者)概述了这个 struct 的内容:

- 魔术数

- 版本号

- 下一个地址

- 下一个模式

- 选项

所有这些都是无符号长整型(我猜是 64 位,8 字节?)。

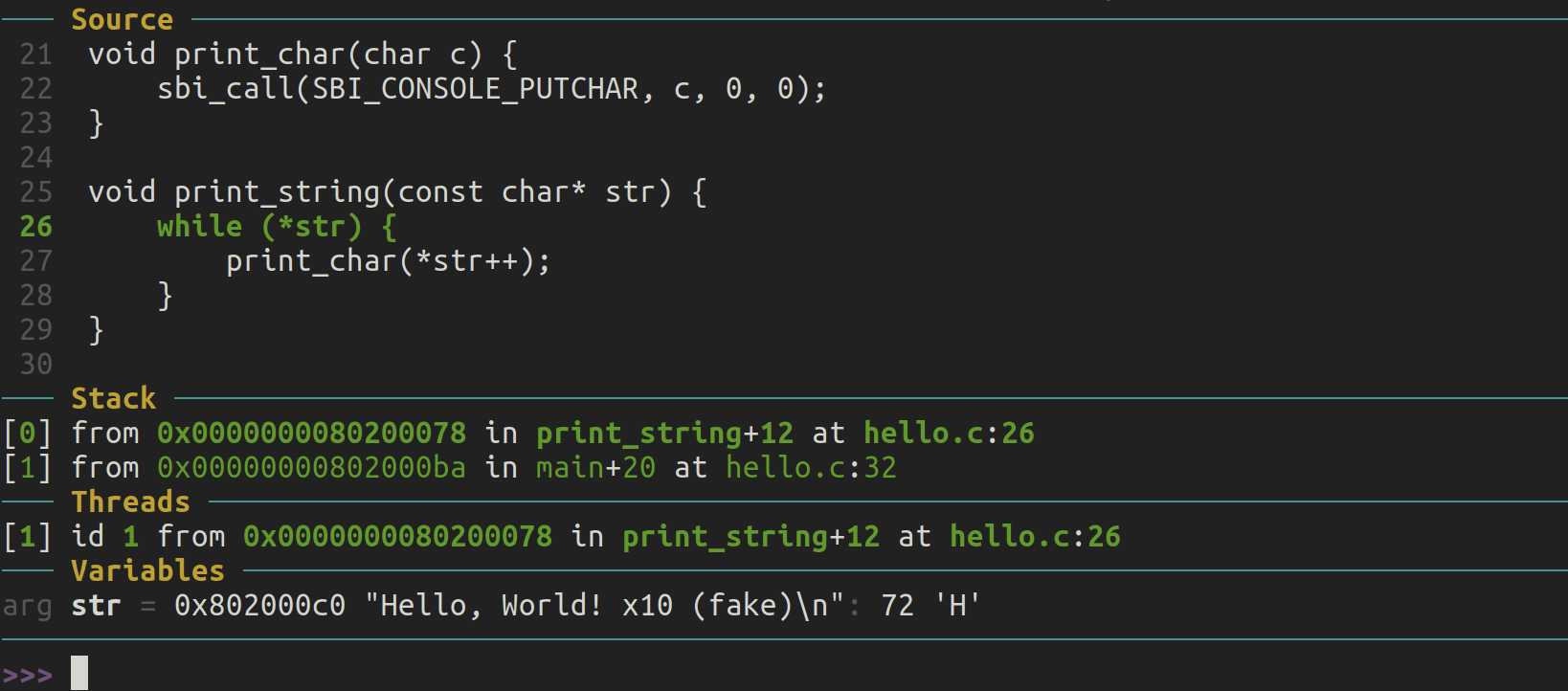

探索 fw_dynamic_info 结构

到此为止,我们来一个快速的绕道,确保我们在讨论相同的版本。我们检查一下 OpenSBI 的版本,因为不同系统的 QEMU 可能带有不同版本的 OpenSBI。构建 OpenSBI 源码非常简单,让我们快速进行。首先,我们需要克隆 Git 仓库(本文写作时是 2023 年 9 月 10 日;如果你想要完全可重复的构建,可以使用这一天的提交版本):

git clone https://github.com/riscv-software-src/opensbi.git

cd opensbi

make ARCH=riscv CROSS_COMPILE=riscv64-linux-gnu- PLATFORM=generic

构建速度应该非常快,且占用资源较少。我们感兴趣的输出文件是 build/platform/generic/firmware/fw_dynamic.bin。我们将通过 QEMU 的 -bios 标志来传递这个文件。从刚刚克隆的 opensbi 文件夹中启动 QEMU:

qemu-system-riscv64 -machine virt -s -S -bios build/platform/generic/firmware/fw_dynamic.bin

在 gdb 中执行几次 si 之后,我们回到之前的状态。让我们通过 gdb 查看 QEMU 的内存,以了解 ZSBL 结束时的情况。在 ZSBL 的最后一条指令处,我们查看寄存器转储(使用 i r 来查看):

=> 0x0000000080000000: 33 04 05 00 add s0,a0,zero

(gdb) i r

结果显示 a2 指向 0x1028。正如我们所说的,让我们通过 gdb 检查该内存。我们让它读取从 0x1028 开始的 10 个连续的 8 字节值,并以十六进制格式显示。

(gdb) x/10xg 0x1028

g 标志用于以 8 字节的“巨大”块打印内存内容。

(gdb) x/10xg 0x1028

0x1028: 0x000000004942534f 0x0000000000000002

0x1038: 0x0000000000000000 0x0000000000000001

0x1048: 0x0000000000000000 0x0000000000000000

0x1058: 0x0000000000000000 0x0000000000000000

0x1068: 0x0000000000000000 0x0000000000000000

这大致符合Vysakh的文章中的描述。我们确实看到了文章中提到的魔术数,后面跟着的是 0x02 版本信息。接下来应该是下一个跳转的地址,但这里全是零……这有点奇怪,不过我们继续看。下一个值是 0x01,根据文章,它应该对应于执行的下一个模式,也就是 S 模式。这是正确的,我们从运行 SBI 的 M 模式切换到运行操作系统内核引导程序(或直接是内核)的 S 模式。为什么下一个跳转地址全是零呢?在这个时候,我决定让 QEMU 不再受 gdb 干扰而继续运行。我在 gdb 中运行以下命令:

continue

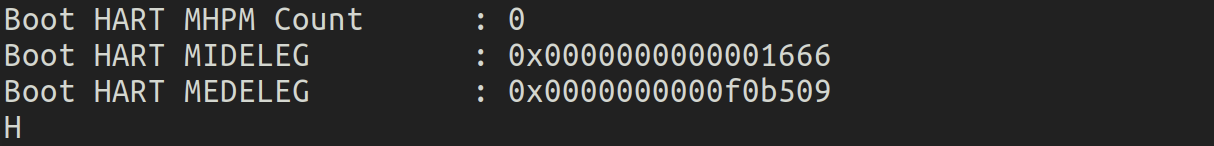

现在一切都停止了,但由于我正在运行更新版本的 OpenSBI,所以 UART 上输出了更新的内容:

OpenSBI v1.3-54-g901d3d7

____ _____ ____ _____

/ __ \ / ____| _ \_ _|

| | | |_ __ ___ _ __ | (___ | |_) || |

| | | | '_ \ / _ \ '_ \ \___ \| _ < | |

| |__| | |_) | __/ | | |____) | |_) || |_

\____/| .__/ \___|_| |_|_____/|____/_____|

| |

|_|

Platform Name : riscv-virtio,qemu

Platform Features : medeleg

Platform HART Count : 1

Platform IPI Device : aclint-mswi

Platform Timer Device : aclint-mtimer @ 10000000Hz

Platform Console Device : uart8250

Platform HSM Device : ---

Platform PMU Device : ---

Platform Reboot Device : syscon-reboot

Platform Shutdown Device : syscon-poweroff

Platform Suspend Device : ---

Platform CPPC Device : ---

Firmware Base : 0x80000000

Firmware Size : 322 KB

Firmware RW Offset : 0x40000

Firmware RW Size : 66 KB

Firmware Heap Offset : 0x48000

Firmware Heap Size : 34 KB (total), 2 KB (reserved), 9 KB (used), 22 KB (free)

Firmware Scratch Size : 4096 B (total), 768 B (used), 3328 B (free)

Runtime SBI Version : 1.0

Domain0 Name : root

Domain0 Boot HART : 0

Domain0 HARTs : 0*

Domain0 Region00 : 0x0000000002000000-0x000000000200ffff M: (I,R,W) S/U: ()

Domain0 Region01 : 0x0000000080040000-0x000000008005ffff M: (R,W) S/U: ()

Domain0 Region02 : 0x0000000080000000-0x000000008003ffff M: (R,X) S/U: ()

Domain0 Region03 : 0x0000000000000000-0xffffffffffffffff M: () S/U: (R,W,X)

Domain0 Next Address : 0x0000000000000000

Domain0 Next Arg1 : 0x0000000087e00000

Domain0 Next Mode : S-mode

Domain0 SysReset : yes

Domain0 SysSuspend : yes

Boot HART ID : 0

Boot HART Domain : root

Boot HART Priv Version : v1.10

Boot HART Base ISA : rv64imafdc

Boot HART ISA Extensions : zicntr

Boot HART PMP Count : 16

Boot HART PMP Granularity : 4

Boot HART PMP Address Bits: 54

Boot HART MHPM Info : 0 (0x00000000)

Boot HART MIDELEG : 0x0000000000000222

Boot HART MEDELEG : 0x000000000000b109

这与我们之前看到的相符,接下来的地址全是零……这很奇怪,不可能是对的。我现在运行 QEMU 时没有让它暂停,而是让它直接运行,并异步连接 gdb。我就不详细说明了,但在这种“实时运行”中检查寄存器时,确实显示没有任何指令在 0x0000000000000000 区域执行。CPU 似乎在某个其他地址上循环。

这可能与我实际上没有向 QEMU 传递除了 OpenSBI 以外的其他软件有关,所以这可能导致了问题。QEMU 可能将该结构填充为全零,OpenSBI 识别到这是一个非法的边缘情况,因此它一直在 OpenSBI 中无休止地循环——这是我的推测。

我们如何传递一些除 OpenSBI 以外的软件呢?**与传递 OpenSBI 的方式相同,只是使用不同的标志!**这次我们使用 -kernel QEMU 标志。我们将如何构建这个软件?与之前的“伪 BIOS”构建方式相同,只是将其映射到不同的内存位置。让我们试着把它加载到 0x80200000。

构建一个“无限循环的伪内核”

我们的操作系统内核将无限循环。它将在 0x80200000 处包含一条跳转指令,永远保持在那里。以下是汇编源代码:

.global _start

.section .text.kernel

_start: j _start

链接脚本如下:

MEMORY {

kernel_space (rwx) : ORIGIN = 0x80200000, LENGTH = 128

}

SECTIONS {

.text : {

infinite_loop.o(.text.kernel)

} > kernel_space

}

有关如何使用这些文件构建可加载到 QEMU 的 ELF 映像的详细信息,请参阅原始的裸机编程文章。

一旦我们构建完成,我们会得到一个名为 infinite_loop 的 ELF 文件,可以作为我们的伪内核。现在我们运行 QEMU:

qemu-system-riscv64 -machine virt -s -S -bios build/platform/generic/firmware/fw_dynamic.bin -kernel ~/work/github_demo/risc-v-bare-metal-fake-kernel/infinite_loop

再次,我连接 gdb 并用 si 一步步执行到 ZSBL 结束。现在,当我查看臭名昭著的 0x1028 结构时,情况好多了,这证实了 QEMU 之前奇怪地填充了那个结构的理论。

=> 0x0000000080000000: 33 04 05 00 add s0,a0,zero

(gdb) x/10xg 0x1028

0x1028: 0x000000004942534f 0x0000000000000002

0x1038: 0x0000000080200000 0x0000000000000001

0x1048: 0x0000000000000000 0x0000000000000000

0x1058: 0x0000000000000000 0x0000000000000000

0x1068: 0x0000000000000000 0x0000000000000000

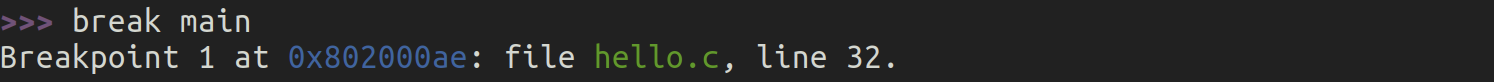

我们现在看到该结构中的新地址已经填充,正如预期的那样。这也反映在 UART 上的 OpenSBI 输出中。让我们通过 gdb 继续进入我们的伪内核,看看那里一切是否正常。

(gdb) break *0x080200000

Breakpoint 1 at 0x80200000

(gdb) continue

Continuing.

Breakpoint 1, 0x0000000080200000 in ?? ()

=> 0x0000000080200000: 6f 00 00 00 j 0x80200000

一切看起来都很正常。让我们总结一下:

- ZSBL 是上电后运行的第一段代码。它初始化了一些寄存器,关键的寄存器是

a2,它指向一个fw_dynamic_info结构,该结构包含 OpenSBI 动态模式操作的关键信息。在 QEMU 的情况下,这个结构在上电时被虚拟化引擎神奇地填充,但在现实中,这很可能是 ZSBL 的工作。不管怎样,OpenSBI 现在知道完成后要做什么。 - OpenSBI 提供了一个基于中断的接口,供上层软件(大概是操作系统内核引导程序或内核本身)调用。这个接口称为 SBI,它在概念上与操作系统之上的应用程序软件的 ABI 相同。

- 我们将内核映像作为另一个 ELF 文件传递给 QEMU,加载到内存的另一个区域。QEMU 填充该结构,使得 OpenSBI 能够将控制权传递到那里,并且在切换到那里之前,它会进入

S模式。

有意略过的细节

ZSBL 还修改了 a0 和 a1 寄存器。

a0 与 RISC-V 的 hart 有关,但我们不深入探讨这些细节,因为它们对本文的其余部分没有太大相关性。此外,这个引导过程中的这一步似乎并不重要,参见Github评论。

a1 是一个有趣的指针,它指向内存中的设备树数据结构。对于本文的其余部分,这个数据结构并不相关,因此我们可以忽略它。然而,对于像 Linux 这样的真实内核,设备树非常有用。Linux 能够从内存中扫描设备树,并了解它运行的机器的结构,而不是针对每种硬件组合编写大量的 if/else 分支。你可以从维基百科文章中了解它在 Linux 中的使用情况。不过,正如所提到的,我们不会在本文中讨论设备树的细节。

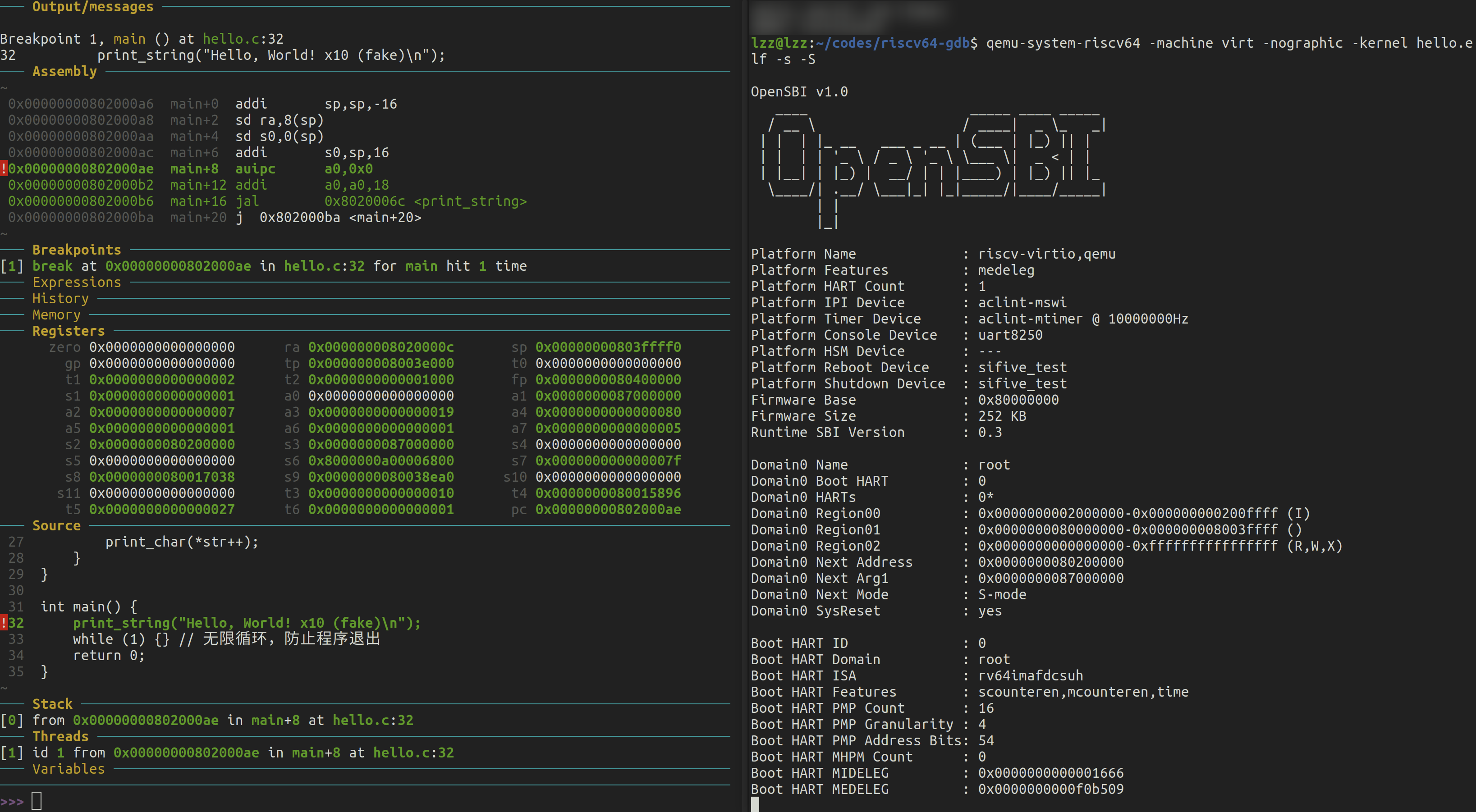

Hello World 伪内核

现在我们已经掌握了足够的知识,可以编写一个伪操作系统内核,它只是在 UART 设备上打印“Hello world”。这个功能与我们在前一篇文章中看到的裸机程序没有太大区别,但我们到达目标的方式有显著不同。这次,我们将通过 SBI 调用来打印到 UART,而不是直接与 UART 设备交互(我们将这项工作委托给一个更底层的特权软件层)。即使在像“Hello world”这样简单的例子中,这也可能带来重大影响:我们将与 UART 硬件交互的责任委托给 SBI 层,从而实现跨不同符合 SBI 接口的机器的可移植性。

如何调用 RISC-V 的 SBI 层?概念上,这与在 x86 Linux 上调用标准输出打印非常相似——我们需要填充一些寄存器并触发软件中断/陷阱,将控制传递到软件栈的底层 OpenSBI。OpenSBI 在 SBI 层提供了许多服务,其中许多服务对于开发可移植的操作系统内核非常有用,例如与定时器的交互(这与时间切片和使多个线程共享同一 CPU 核心相关)。有关 SBI 层暴露的全部功能列表,请查看这里。

在本指南中,我们将专注于调试控制台功能,即通过 SBI 向 UART 写入内容。让我们开始编写代码吧!

首先,我们需要知道如何通过寄存器编码我们希望 OpenSBI 执行的功能。这在这里有详细记录。简而言之,SBI 功能被分组到“扩展”中。寄存器 a7 包含扩展 ID (EID),而 a6 编码该扩展中的功能 ID (FID)。然后通过 a0、a1、a2 等寄存器传递参数。

要打印到控制台,我们需要的 EID 是 0x4442434E(一个相当有趣的值),而 FID 则是 0x00。

这次,和之前裸机编程指南中的逐字打印不同,我们将一次性调用打印功能。毕竟,我们应该从 SBI 层提供的高级功能中受益。因此,我们的二进制文件应该将输出字符串存储在内存中的某个地方,理想情况下,我们希望通过调用 SBI 从该地址开始打印。我们将这样做:

.global _start

.section .text.kernel

_start: li a7, 0x4442434E

li a6, 0x00

li a0, 12

lla a1, debug_string

li a2, 0

ecall

loop: j loop

.section .rodata

debug_string:

.string "Hello world\n"

这里有几个需要注意的地方:

- 我们在这里使用了 PC 相对寻址来处理输出字符串。需要提醒的是,内核存储在一个非常大的无符号整数表示的地址上。这个值太大,无法用任何 RISC-V 32 位指令字编码。这不是问题,我们只需使用一小段

AUIPC和ADDI指令即可到达那里(有关更多信息,请查看这篇文章)。如果你不理解这一点,请务必复习不同的内存寻址模式及其差异:这是任何裸机编程的关键。由于这是一个常见的模式,RISC-V 汇编器提供了一个伪指令LLA,我们在这里使用了它。 - SBI 需要将要打印的字符串指针分为两部分传递。可以看到其中一部分是 0。我不太确定为什么需要这样,但这是 API 设计的要求。

SBI 调用涉及的寄存器

a7标识 SBI 扩展。a6标识扩展中的功能(在本例中是调试控制台扩展)。a0包含需要发送到调试控制台输出的字符串长度。a1和a2结合在一起,形成指向需要打印的字符串地址的 64 位指针。

SBI 调用通过 ecall 指令触发,它会激活 CPU 陷阱。此时,OpenSBI 接管并通过 UART 输出数据,方式与我们在最初的裸机编程指南中所做的完全相同。如果你想知道为什么简单的 ecall 调用会将控制权交给 OpenSBI,这是因为 OpenSBI 设置了陷阱处理机制,当我们的内核进入陷阱时,程序计数器会跳转到 OpenSBI 的软件部分。这些细节超出了本文的范围,但我们可能会在其他文章中详细讨论。

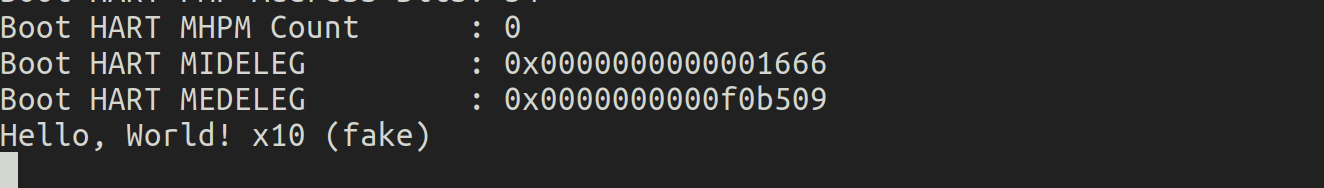

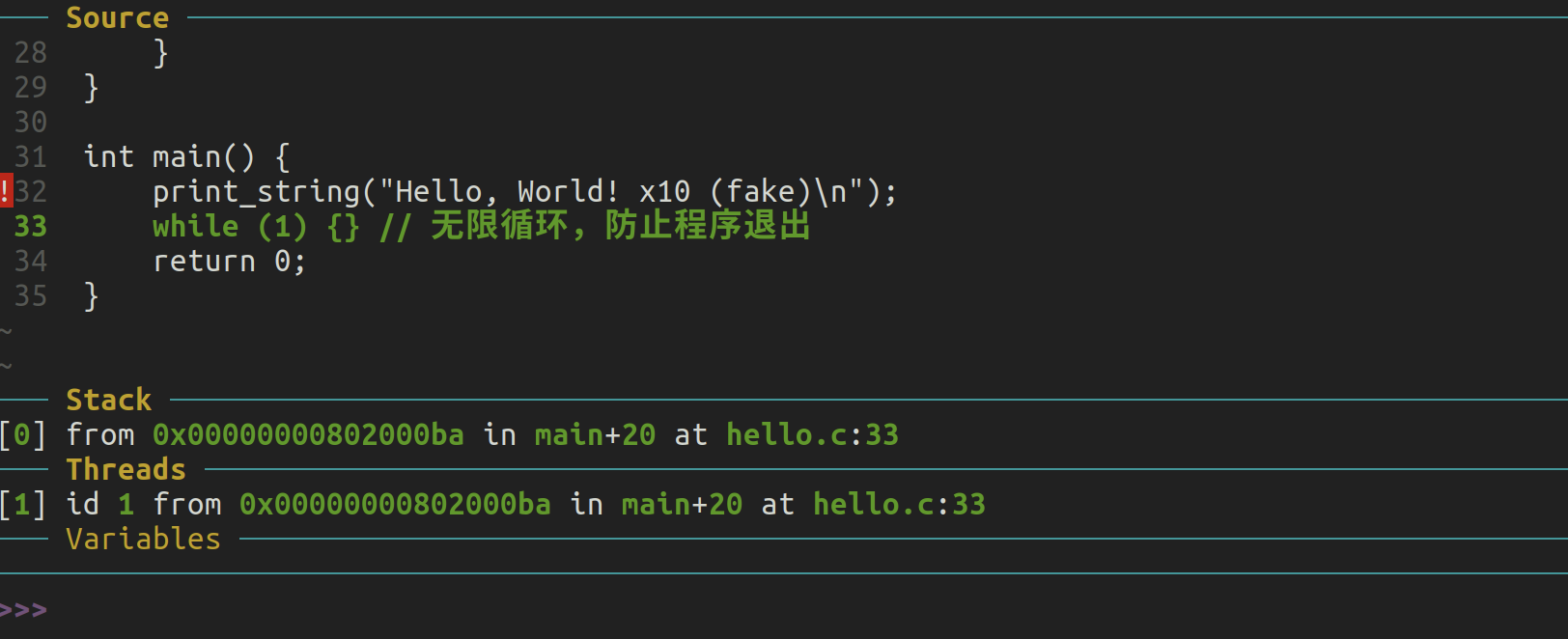

现在,只需查看 QEMU 的串行端口,确认“Hello world”已正确打印:

qemu-system-riscv64 -machine virt -s -S -bios build/platform/generic/firmware/fw_dynamic.bin -kernel ~/work/github_demo/risc-v-bare-metal-fake-kernel/hello_world_kernel

输出应该如下所示:

OpenSBI v1.3-54-g901d3d7

____ _____ ____ _____

/ __ \ / ____| _ \_ _|

| | | |_ __ ___ _ __ | (___ | |_) || |

| | | | '_ \ / _ \ '_ \ \___ \| _ < | |

| |__| | |_) | __/ | | |____) | |_) || |_

\____/| .__/ \___|_| |_|_____/|____/_____|

| |

|_|

Platform Name : riscv-virtio,qemu

Hello world

作为练习,我建议通过 gdb 探索基础扩展(0x10),以调查你构建的 QEMU 机器和 OpenSBI 能提供哪些功能。

结论

最终,我们得到了一个完全可移植的伪内核,它能够通过 UART 打印“Hello world”!虽然看起来不特别,但其背后的概念非常强大。你可以在支持调试控制台扩展的不同 RISC-V 64 位机器上直接使用相同的内核映像,无需重新构建。

事实上,我在这里玩了个小技巧 :) 让我建议你从源代码构建 OpenSBI 的原因之一是,某些 Linux 发行版包管理器提供的 QEMU 版本不支持调试控制台扩展(它们的版本较旧)。这正是我在 Debian 的 QEMU 中默认使用的 OpenSBI 遇到的情况。

最后,提醒大家我们主要关注的是带有 RISC-V 核心的 QEMU virt 机器,本文的所有细节都与此相关。不过,我希望读者已经了解了足够的启动顺序和裸机编程概念,以便将这些知识轻松应用到现实中的特定场景。

在接下来的文章中,我们将讨论如何进一步引导完整的 Linux 内核,并逐步扩展,直到我们实现一个能够处理键盘、鼠标、屏幕和以太网网络的 Linux 部署。

希望你喜欢这篇长篇文章!

代码指引

如果你不想复制粘贴代码,它可以在这个 GitHub 仓库中找到。

【翻译】Bare metal programming with RISC-V guide

原文作者: @popovicu

原文链接: Bare metal programming with RISC-V guide

版权声明: 本文为 @popovicu 的原创作品。本文的翻译仅供学习参考,更多详细信息请访问原文链接。

RISC-V 裸机编程指南

发表于:2023年9月9日 | 上午12:05

今天我们将探讨如何为 RISC-V 机器编写一个裸机程序。为了确保可重复性,我们将目标设定为 QEMU 的 riscv64 virt 虚拟机。

我们将简要介绍 RISC-V 机器启动的初始阶段,以及如何插入你自己的定制软件来进行裸机编程!

在本文的结尾,我们将为我们的 RISC-V 机器编写一个裸机程序,并向用户发送字符串“hello”,而不依赖于运行机器上的任何支持软件(操作系统内核、库等)。

机器启动和初始软件运行

一般概念

如果你熟悉计算机如何启动,可以跳过这一部分。

当一台真实的机器启动时,硬件首先运行健康检查,然后将要运行的第一批指令加载到内存中。一旦指令加载完成,处理器核心初始化其寄存器,程序计数器指向第一条指令。从那时起,软件便可以运行。

在像小型微控制器这样的简单系统中,所有的软件都包含在一个单一的二进制指令块中。处理器接下来将只执行这些指令。在像笔记本电脑或手机这样的更复杂的系统中,启动有更多阶段。

在这些复杂系统中,传统上,第一批指令是 BIOS,它的任务是将引导加载程序加载到内存中并将控制权移交给它。引导加载程序通常很小,便于加载到运行内存中,处理器可以轻松开始执行它的代码。然后它将操作系统内核加载到内存中(实现引导加载程序本身就是一门学问)。

每台机器以自己的方式加载初始软件。例如,BIOS 可以存储在一个独立的存储芯片上,通电后,存储的内容将被加载到内存中的固定地址,然后处理器从该地址开始执行。

QEMU 启动

即使 riscv64 virt 机器是虚拟的,它仍然有自己的启动顺序。它会经历多个阶段,目前我们不会探索所有细节。请关注后续文章中的更多详细介绍。

理解这个虚拟机的关键在于,显然它没有连接读取软件的芯片(它是虚拟的),所以 QEMU 通过某种方式模拟这一过程。你可能在之前的 QEMU 示例中见过 -bios 标志,现在你应该能对它有一个强烈的直觉。如果你猜测这是传递你的虚拟 RISC-V 核心在启动时执行的第一批指令,你是几乎正确的*。

零阶段引导加载程序 (ZSBL)

一旦你启动了这个虚拟机,QEMU 就会在 0x1000 地址填充一些指令,并将程序计数器设置为该地址。这相当于一台真实的机器在板上有一些硬编码的 ROM 固件(存放在某个芯片中),并在启动时将其内容转储到 RAM 中。你无法控制这些指令,它们不是你软件镜像的一部分,通常来说,我认为你没有理由想要覆盖这些指令,而且它们实际上对于更复杂的设置非常有用(我保证我们会在后续文章中讨论它们)。对于好奇的人来说,这几条指令就是零阶段引导加载程序(ZSBL)。ZSBL 设置了一些寄存器,具体原因我们将在未来探索(现在,你可以基本忽略这些寄存器的设置),并跳转到 0x80000000 地址,这才是真正的“战斗”开始的地方!

QEMU 的 -bios 标志

0x80000000 是 QEMU 开始运行用户提供的第一条指令的地址,这些指令在虚拟机启动时立即加载。如果你不传递任何东西,QEMU 将使用默认设置,并加载一个名为 OpenSBI 的软件。下一篇文章将详细介绍 RISC-V 中 SBI 的概念,以及 OpenSBI 究竟是什么。需要注意的是,RISC-V 中的 SBI 并不是真正的 BIOS,而是非常类似的东西。我的个人猜测是,QEMU 作者简单地复用了在其他架构(如 x86)上代表 BIOS 的标志。不过需要记住的是,SBI 在功能上与 BIOS 非常相似,更重要的是,它是可以定制的。

-bios 标志接受一个 ELF 二进制文件,包含指令和其他数据,按段组织。ELF 是 Linux 的标准二进制格式,虽然 ELF 文件格式的详细内容超出了本文的讨论范围,但我们可以简化理解为它是一个键值对映射,其中键是段的起始地址,值是需要加载到该地址的字节序列。因此,传递给 -bios 标志的 ELF 文件会填充从 0x80000000 开始的内存(这正是 QEMU 默认的 OpenSBI 镜像所做的事情)。

关于 -kernel 标志的说明

如果你之前用 QEMU 启动过操作系统(例如 Linux),你可能用过 -kernel 标志。它的作用基本与 -bios 标志相同:你可以传递一个 ELF 映像,覆盖其他内存区域,从概念上讲,它只是将字节转储到内存中。我们今天不会使用这个标志,但会在后续文章中详细介绍它的用法。

ELF 文件如何在启动过程中使用?

虽然概念上 ELF 文件只是一种填充内存的方法,但它们绝对不简单,你无法在一个下午编写一个简单的解析器。细心的读者可能会想:机器如何知道从 ELF 文件中解析出映射到某个地址(如 0x12345678)的内容并将其加载到内存中?这是个很好的问题——在我们的案例中,我们使用的是虚拟机,基本上是在模拟一台拥有智能数字电路或极其复杂的初始软件引导程序的机器,而这些内容在机器上电时已经准备好存储在内存中。当然,这不是在真实机器中发生的事情。真实机器上电时加载的软件是存储在机器存储器中的平坦二进制块,上电时它会直接被转储到内存中,实际上并没有任何解析过程。但由于我们在这里处理的是虚拟机器,几乎没有限制,我们无需受到制造硬件复杂性的约束。

为 RISC-V 编写自定义 “BIOS”

我们已经确定 0x80000000 是机器执行的第一条用户提供指令的位置。我只是将其作为一个事实给出,如果你想了解更多背景,可以从这里开始。基本上,我们看到的是,DRAM 在地址空间中映射为从 0x80000000 开始(如果你不理解这是什么意思,不用担心,本文接下来的内容对这个概念的依赖不大)。

让我们开始构建一个 ELF 文件,它将在地址 0x80000000 处布置一些处理器指令,以向用户显示消息“hello”!

通过 UART 与用户交互

曾经做过嵌入式系统编程的人肯定熟悉 UART 的概念。UART 是一种非常简单的设备,用于最基本的输入/输出形式:它有一根输入线(接收,称为 RX)和一根输出线(发送,称为 TX),每次传输一位。如果你要连接两台设备通过 UART 通信,一台设备的 TX 连接到另一台设备的 RX,反之亦然。如果你阅读本文时从未接触过 UART,我强烈建议你至少购买最便宜的 Arduino,并通过 USB 转 UART 电缆与计算机通信。这个概念与我们在这里做的完全相同,但你将真正动手操作,理解会更加深刻,因为这里的场景是完全虚拟化的。

QEMU 虚拟化了虚拟机上的 UART 设备,我们的软件可以访问它。当你打开 QEMU 的串行端口(UART)部分时,基本上当你按下键盘上的按钮时,按键的代码会从主机的 TX 发送到虚拟机的 RX,而当虚拟机在其 TX 上输出某些内容时,它会在终端中图形化显示给你(因此你不必解码来自模拟板的电信号 :)),例如,如果虚拟机发送 8 位代表 65 的数据,你的 QEMU 将显示字符 a,因为这是它的 ASCII 代码。

我们知道 QEMU 将 UART 映射到地址 0x10000000(可以在 QEMU 的源代码中查看),这里虚拟化的设备是 NS16550A。具体细节不重要:对于本文的目的来说,这意味着如果你从软件中向该地址发送一个 8 位值,它将通过虚拟化的 UART 设备的 TX 线路发送出去。实际上,这意味着如果你打开 QEMU 的串行端口,你写入 0x10000000 的字符将显示在你的控制台中。

将代码整合在一起

了解了所有这些知识后,我们现在可以编写代码。我们即将构建的 ELF 文件会在地址 0x80000000 上布局一些指令,这些指令依次将字符 ‘h’、‘e’、‘l’、‘l’ 和 ‘o’ 发送到地址 0x10000000。最后,代码会进入一个无限循环(这样 QEMU 不会由于某些奇怪的原因崩溃,并且我们可以检查输出)。

.global _start

.section .text.bios

_start: addi a0, x0, 0x68

li a1, 0x10000000

sb a0, (a1) # 'h'

addi a0, x0, 0x65

sb a0, (a1) # 'e'

addi a0, x0, 0x6C

sb a0, (a1) # 'l'

addi a0, x0, 0x6C

sb a0, (a1) # 'l'

addi a0, x0, 0x6F

sb a0, (a1) # 'o'

loop: j loop

将此文件保存为 hello.s。让我们将这个文件汇编为机器码。在我的情况下(可能也是你的情况),我使用了跨平台的工具链,这意味着我在与目标平台不同的平台上进行开发。具体来说,我在 x86 机器上开发此软件,并为 riscv64 机器构建。

要汇编此文件,我运行以下命令:

riscv64-linux-gnu-as -march=rv64i -mabi=lp64 -o hello.o -c hello.s

具体命令可能会根据你使用的 riscv64 汇编器有所不同,这是我通过 Debian 系统的包管理器获得的工具。我建议你通过互联网获取构建 riscv64 软件的正确工具链,通常只需获取正确的软件包。

现在,代码只是被汇编了,这意味着我们已经将软件指令转换为机器码格式,但这个二进制文件还不能作为我们的伪 BIOS 使用。我们需要使用 链接器 并通过 链接脚本 来确保生成的指令按预期布局在 0x80000000 地址。让我们编写链接脚本。

MEMORY {

dram_space (rwx) : ORIGIN = 0x80000000, LENGTH = 128

}

SECTIONS {

.text : {

hello.o(.text.bios)

} > dram_space

}

我们不会深入解释这些内容的含义,但简而言之,现在我们有一种方法可以将这些指令准确地放置在我们想要的位置。让我们用 objdump 验证一下。

riscv64-linux-gnu-objdump -D hello

输出应该类似如下:

Disassembly of section .text:

0000000080000000 <.text>:

80000000: 06800513 li a0,104

80000004: 100005b7 lui a1,0x10000

80000008: 00a58023 sb a0,0(a1) # 0x10000000

8000000c: 06500513 li a0,101

80000010: 00a58023 sb a0,0(a1)

80000014: 06c00513 li a0,108

80000018: 00a58023 sb a0,0(a1)

8000001c: 06c00513 li a0,108

80000020: 00a58023 sb a0,0(a1)

80000024: 06f00513 li a0,111

80000028: 00a58023 sb a0,0(a1)

8000002c: 0000006f j 0x8000002c

在 QEMU 上运行“伪 BIOS”

现在可以通过运行以下命令启动 QEMU:

qemu-system-riscv64 -machine virt -bios hello

要查看 UART 上发生的情况,请点击顶部菜单中的 View 按钮并切换到串行端口视图。输出应该如下图所示:

我只想运行代码

访问本文的 GitHub 仓库,运行 make 命令,它将执行我们上述的所有步骤。然后你可以启动 QEMU。

RISC-V Privileged Architecture

本讲座是由Allen Baum在第八届RISC-V研讨会上,于2018年5月7日在西班牙巴塞罗那进行的,讲述了RISC-V特权架构的内容。该架构是RISC-V处理器设计中的关键部分,决定了系统不同操作模式下的安全性、隔离性和性能。此幻灯片的内容重点阐述了特权架构的基本组成部分及其在处理器功能中的作用。

原始内容来源:

幻灯片标题:RISC-V Privileged Architecture

原作者:Allen Baum Esperanto Technologies.

出处:8 th RISC-V Workshop Barcelona, Spain

原始发布日期:2018年5月7日

版权声明:该幻灯片及其内容的版权归 Allen Baum 所有。翻译与讲解仅供学习和参考,更多详细信息请参见原文链接。

这是2018年发布的RISC-V特权架构资料,其中的大部分内容仍然与当前的RISC-V架构相关和有效,特别是在架构的基础概念、特权模式、控制状态寄存器(CSRs)和特权指令方面。然而,随着RISC-V的持续发展和标准的更新,部分技术细节可能已经有所改进或扩展。

如果你希望深入了解RISC-V在某些特定领域的最新进展,建议参考最新的RISC-V规范,或者查阅RISC-V基金会的最新文档和技术报告。

目录

为什么需要特权架构?

在处理器架构中,引入特权级别的目的是为了提供更高的系统安全性和资源控制。特权架构确保操作系统和用户程序运行在不同的权限级别,防止普通应用程序访问或修改关键的系统资源。例如,操作系统需要完全访问硬件资源和内存管理功能,而用户程序则只应在受限的环境下运行,以避免误操作或恶意行为影响整个系统的稳定性。特权架构通过分离不同的权限模式,帮助实现系统的可靠性和安全性。

配置文件(Profiles)

RISC-V特权架构根据不同的应用场景设置了不同的配置文件(Profiles),以适应多样化的需求。这些配置文件的存在使得RISC-V架构能够在嵌入式系统、服务器、移动设备等不同领域中灵活应用。每个Profile可以包括不同的功能和特权级别,从而满足特定应用的需求。

权限级别和模式(Privileges and Modes)

RISC-V特权架构划分了几种不同的权限模式,这些模式对应处理器在不同上下文中的操作需求。常见的模式包括:

- 机器模式(M模式):这是RISC-V系统中最高的权限模式,通常由系统固件或低级别管理程序使用,直接控制硬件。

- 监督模式(S模式):用于操作系统内核,允许访问部分硬件资源,但受到比机器模式更多的限制。

- 用户模式(U模式):最低权限的模式,用户应用程序在此模式下运行,无法直接访问硬件或特权指令。

不同的模式通过硬件层级来隔离,确保每个级别的程序只能访问其权限范围内的资源。

特权功能(Privileged Features)

控制和状态寄存器(CSRs)

控制和状态寄存器是RISC-V特权架构中的重要部分,用于管理处理器的操作模式和状态。在特权模式下,CSRs控制包括中断、内存管理、性能计数等各种功能。不同的模式可以访问不同的CSRs,确保系统安全性。例如,用户模式无法修改系统级别的CSRs。

特权指令

RISC-V定义了一系列特权指令,这些指令只能在特定模式下运行,主要用于管理硬件资源和处理系统级别的操作,如中断处理和内存保护。

内存寻址(Memory Addressing)

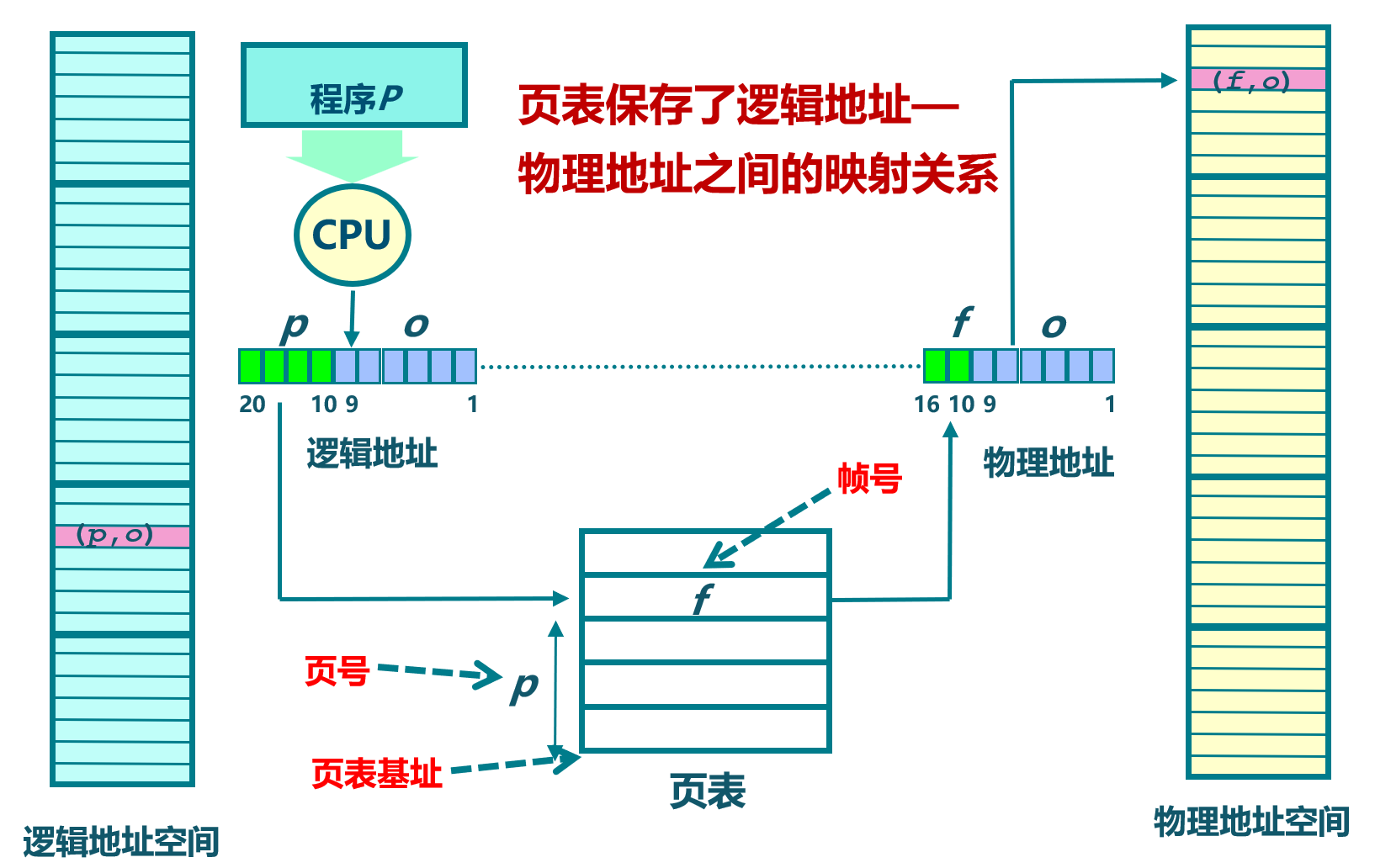

内存寻址机制包括地址翻译和保护功能。RISC-V采用了一种分页机制来实现虚拟内存管理,允许操作系统将物理内存抽象为更灵活的虚拟地址空间。内存保护则确保不同模式下的程序只能访问特定范围的内存,避免越权访问。

地址翻译(Translation)

地址翻译通过页表将虚拟地址映射到物理地址,支持多级页表结构以提高寻址灵活性和效率。这一机制使得RISC-V处理器能够支持大规模内存应用和多任务处理。

内存保护(Protection)

内存保护的核心是防止低权限程序访问或修改高权限内存区域。通过在页表中设置访问权限位,RISC-V能够有效地隔离不同权限模式下的内存访问。

异常处理(Trap Handling)

异常处理机制用于处理运行过程中出现的各种异常情况,包括硬件中断和软件异常。RISC-V特权架构对这些异常的处理进行了细致的定义,确保系统能够在发生异常时迅速恢复或进行适当的操作。

异常(Exceptions)

当发生例如非法指令、访问未授权内存等异常情况时,处理器会捕获这些异常并转入相应的处理程序。这些异常处理程序通常运行在高权限模式下,以确保能够正确恢复系统。

中断(Interrupts)

RISC-V支持硬件和软件中断处理。硬件中断通常由外部设备引发,而软件中断则由处理器内部指令触发。中断处理需要快速响应并恢复正常执行,这也是操作系统设计中的一个关键部分。

计数器(Counters)

RISC-V架构中的计数器用于记录处理器的时间和性能信息。通过这些计数器,操作系统可以监控系统的运行状态,执行诸如时间片轮转、性能调优等任务。

时间(Time)

时间计数器记录系统运行的时间戳,用于系统时钟、定时器和其他时间相关功能。

性能(Performance)

性能计数器用于测量处理器的性能参数,如指令执行数、缓存命中率等。这些数据有助于优化系统性能,并为开发者提供性能调试信息。

Why a Privileged Architecture?

RISC-V特权架构的设计背后有着明确的目的,主要是为了更好地管理共享资源、保护系统的核心功能,并隔离具体实现的细节。共享资源的管理和保护对于现代计算系统至关重要,尤其是在多核、多任务环境中,特权架构的存在能够确保不同任务之间的安全隔离和资源分配。同时,它还提供了软件与硬件层的通信机制,尤其是在虚拟化支持方面,RISC-V架构通过引入一系列执行环境(Execution Environments)实现不同层次的任务隔离和资源共享。

管理共享资源

共享资源包括内存、I/O设备以及处理器核心。在多任务操作系统中,不同任务会争夺这些资源,而没有特权架构的管理会导致系统冲突和崩溃。通过特权架构,系统能够高效地分配这些资源,并在不同任务之间进行适当的隔离与协调。

关键资源管理包括

- 内存:虚拟内存映射使得各个任务能够使用独立的地址空间,从而避免直接访问物理内存。

- I/O设备:通过虚拟内存映射,系统能够保护设备接口,防止低权限任务直接访问关键I/O资源。

- 处理器核心:特权架构可以管理处理器核心的分配,确保高权限任务优先运行。

保护共享资源

资源保护是特权架构的另一个重要目的。通过使用虚拟内存映射以及访问权限控制,RISC-V能够有效防止任务间的越权访问和资源冲突。

具体的保护手段包括

- 内存保护:通过虚拟内存,系统可以为每个任务分配独立的内存空间,防止任务间的非法访问。

- I/O保护:与内存一样,I/O访问也被映射到虚拟地址空间,通过特权级别控制,防止低权限模式直接操作硬件设备。

- 访问权限控制:权限位可以设置在内存映射中,以确保只有特定权限模式能够访问相应的资源。

隔离实现细节

在多任务、多用户环境中,隔离不同实现的细节非常重要。特权架构通过捕获未实现的操作并通过软件仿真进行处理,从而能够兼容不同的实现。此外,处理异步事件(如I/O事件、计时器事件、软件中断)也是特权架构的重要任务,确保外部事件能够被及时响应并处理。

具体措施包括

- 未实现操作的捕获和仿真:当任务执行一个硬件不支持的操作时,特权架构能够捕获该操作并交由软件进行仿真。

- 外部异步事件处理:如I/O设备事件、计时器中断、线程间的中断等,特权架构能够管理这些事件的优先级和处理流程。

- 两级地址转换:为了支持虚拟化,RISC-V引入了两级地址转换机制,特别是在虚拟机管理程序(Hypervisor)模式下,这一机制至关重要。

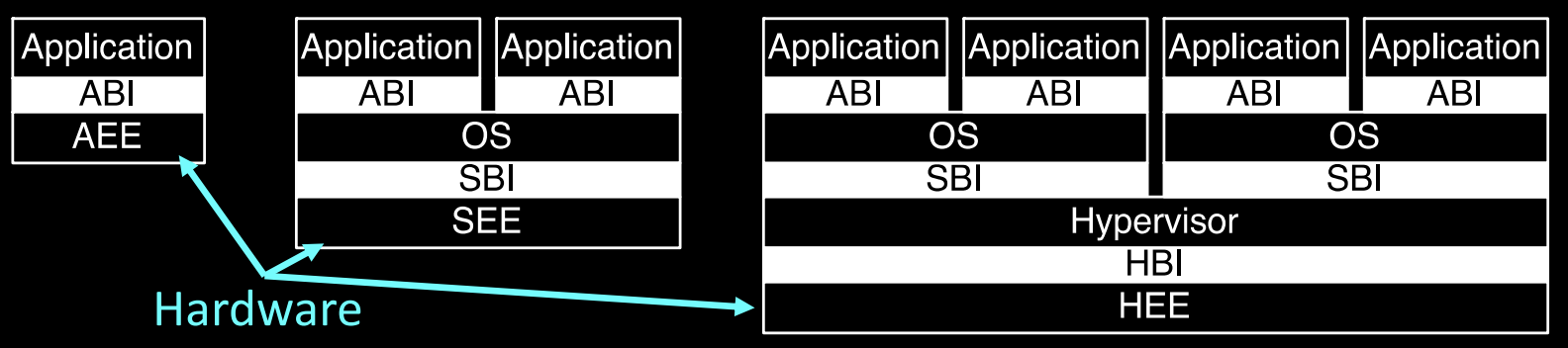

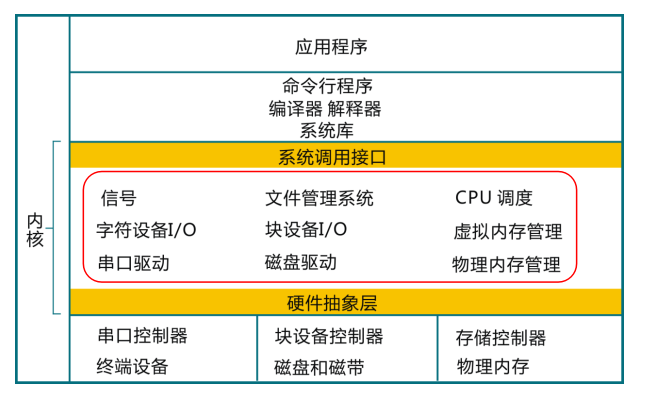

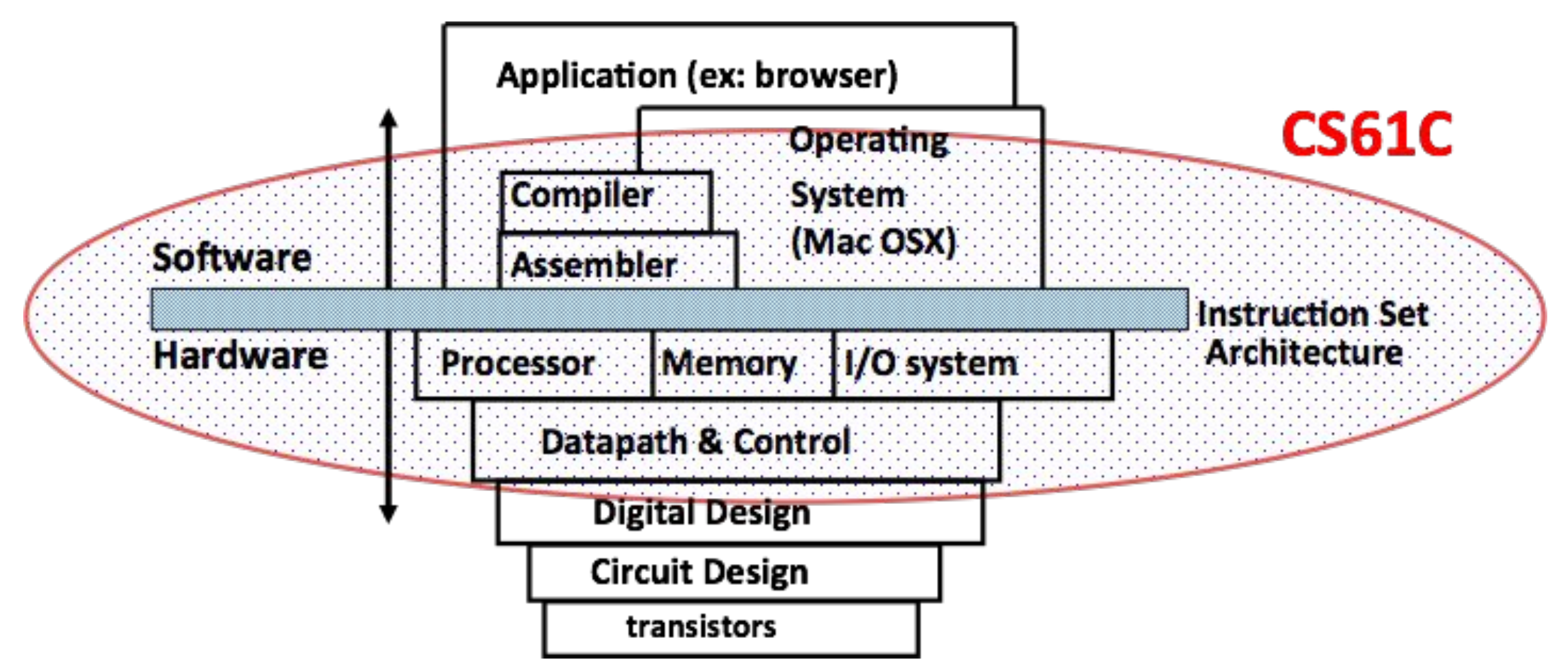

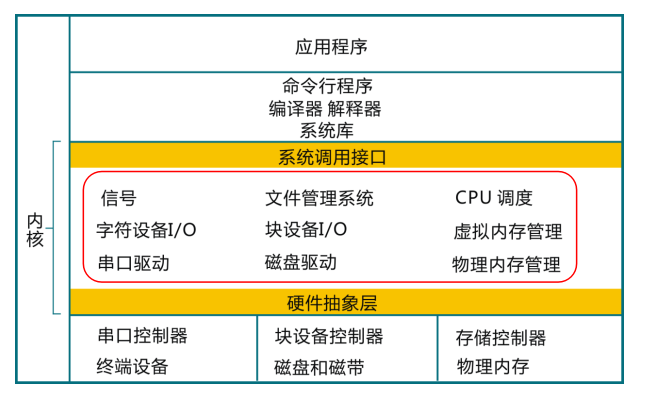

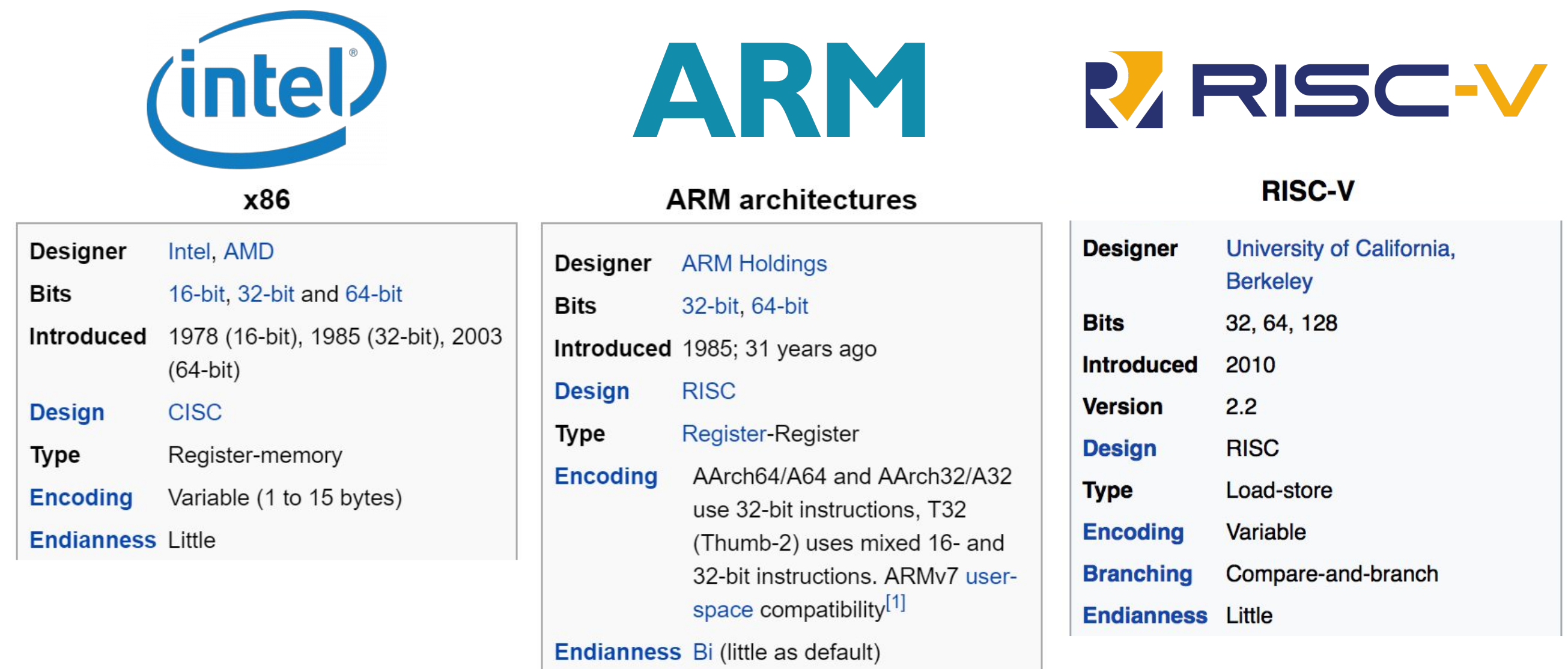

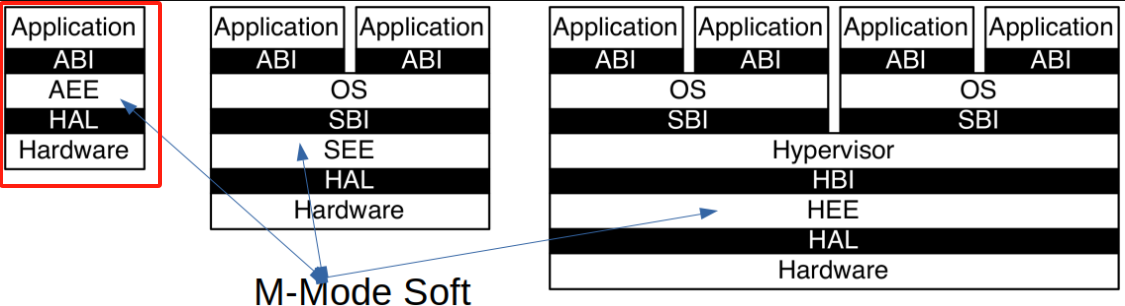

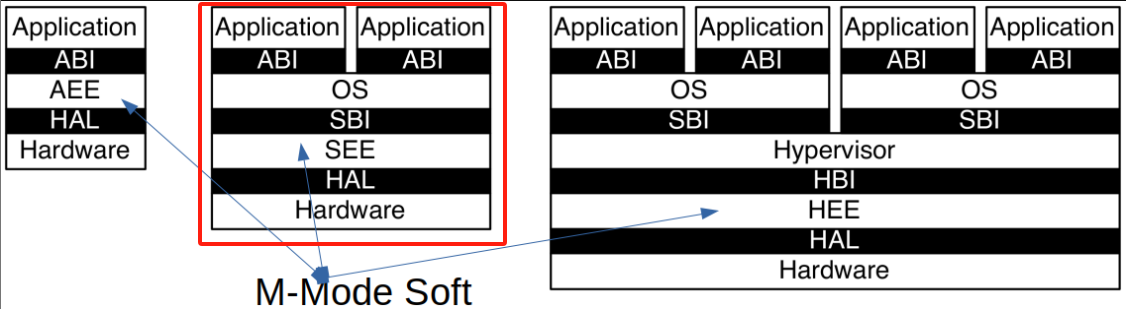

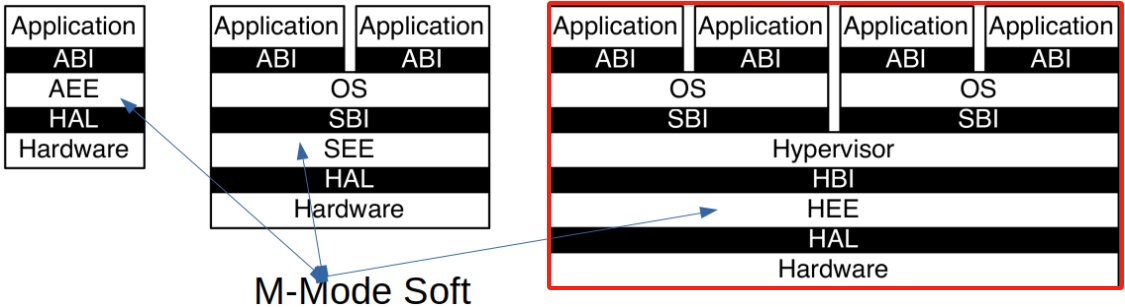

RISC-V Privileged Architecture Layers

RISC-V特权架构分为多个层次,每个层次负责不同的执行环境,并通过特定的接口进行通信。这些层次清晰地划分了应用程序、操作系统、虚拟机管理程序之间的权限和功能,确保系统的可扩展性和安全性。

主要层次

-

应用层(Application):

- 应用执行环境(AEE):为应用程序提供一个运行环境,通过**应用二进制接口(ABI)**与底层系统进行交互。

-

操作系统层(Operating System):

- 监督执行环境(SEE):操作系统运行在监督模式下,管理系统资源,并通过**系统二进制接口(SBI)**与硬件进行通信。

-

虚拟机管理程序层(Hypervisor):

- 虚拟机管理程序执行环境(HEE):支持虚拟化,虚拟机管理程序能够通过虚拟机管理程序二进制接口(HBI)与操作系统层进行交互,管理虚拟机的执行。

层次间的通信

每一层都有其特定的二进制接口,通过这些接口,应用程序、操作系统和虚拟机管理程序能够顺利地进行通信和资源管理。例如,应用程序通过ABI接口调用操作系统的服务,而操作系统通过SBI接口管理底层硬件资源。

通信接口包括

- ABI(Application Binary Interface):应用程序通过ABI与操作系统交互。

- SBI(System Binary Interface):操作系统通过SBI直接与硬件进行通信。

- HBI(Hypervisor Binary Interface):虚拟机管理程序通过HBI接口管理虚拟化环境中的资源和操作系统。

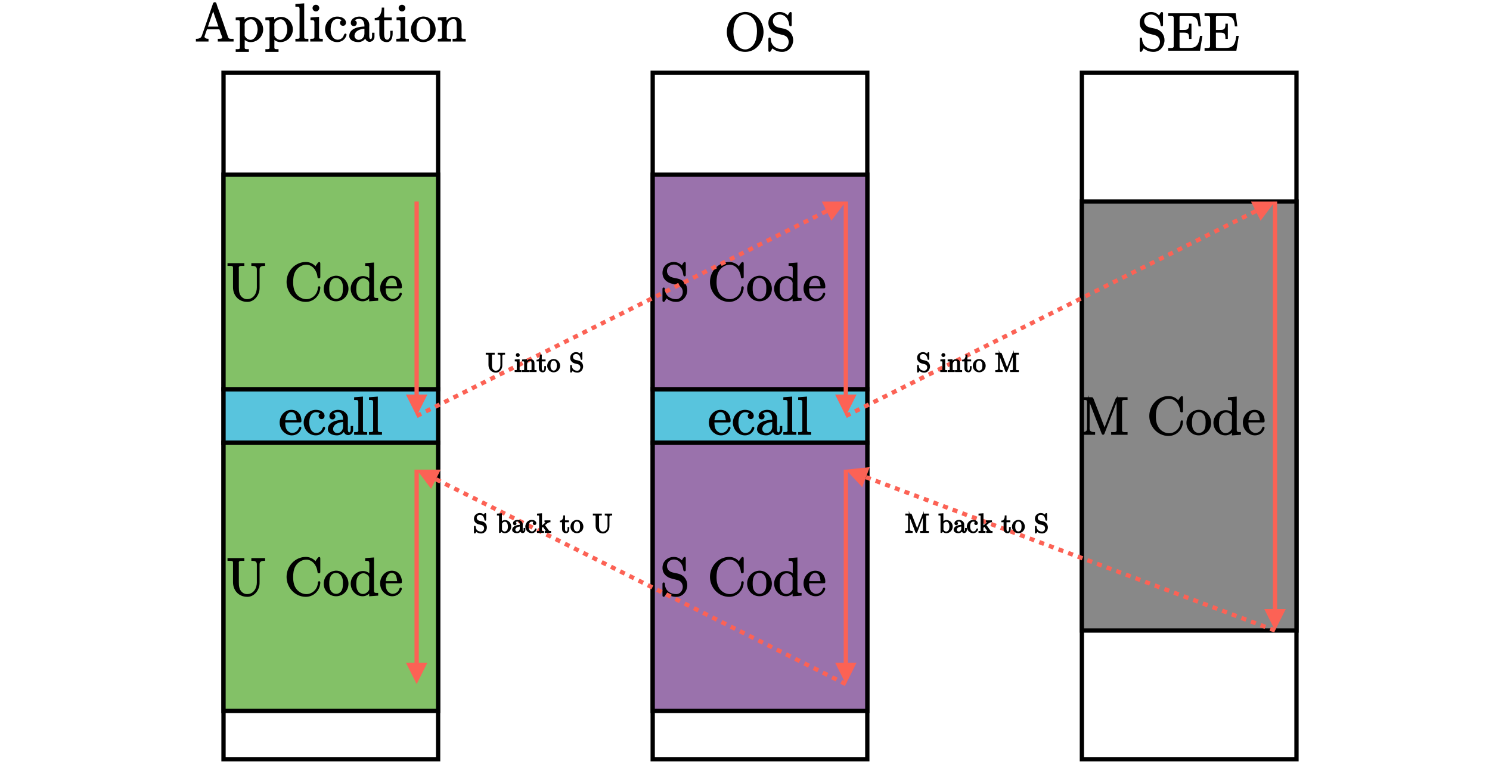

特权层次间的指令通信:ECALL指令

RISC-V引入了ECALL指令来实现不同权限层次之间的通信。当应用程序需要访问高权限功能时,它可以发出ECALL指令,这一指令会触发进入监督模式或虚拟机管理模式进行相应处理。这样,系统能够在保护低权限程序不直接访问高权限功能的同时,提供必要的功能调用接口。

支持虚拟化

RISC-V的所有ISA层次都设计为支持虚拟化。通过虚拟化,操作系统和应用程序可以在不同的虚拟机中运行,彼此隔离而不会影响底层硬件的安全性和资源分配。虚拟化的实现依赖于特权架构中的多级地址翻译机制和特定的二进制接口。

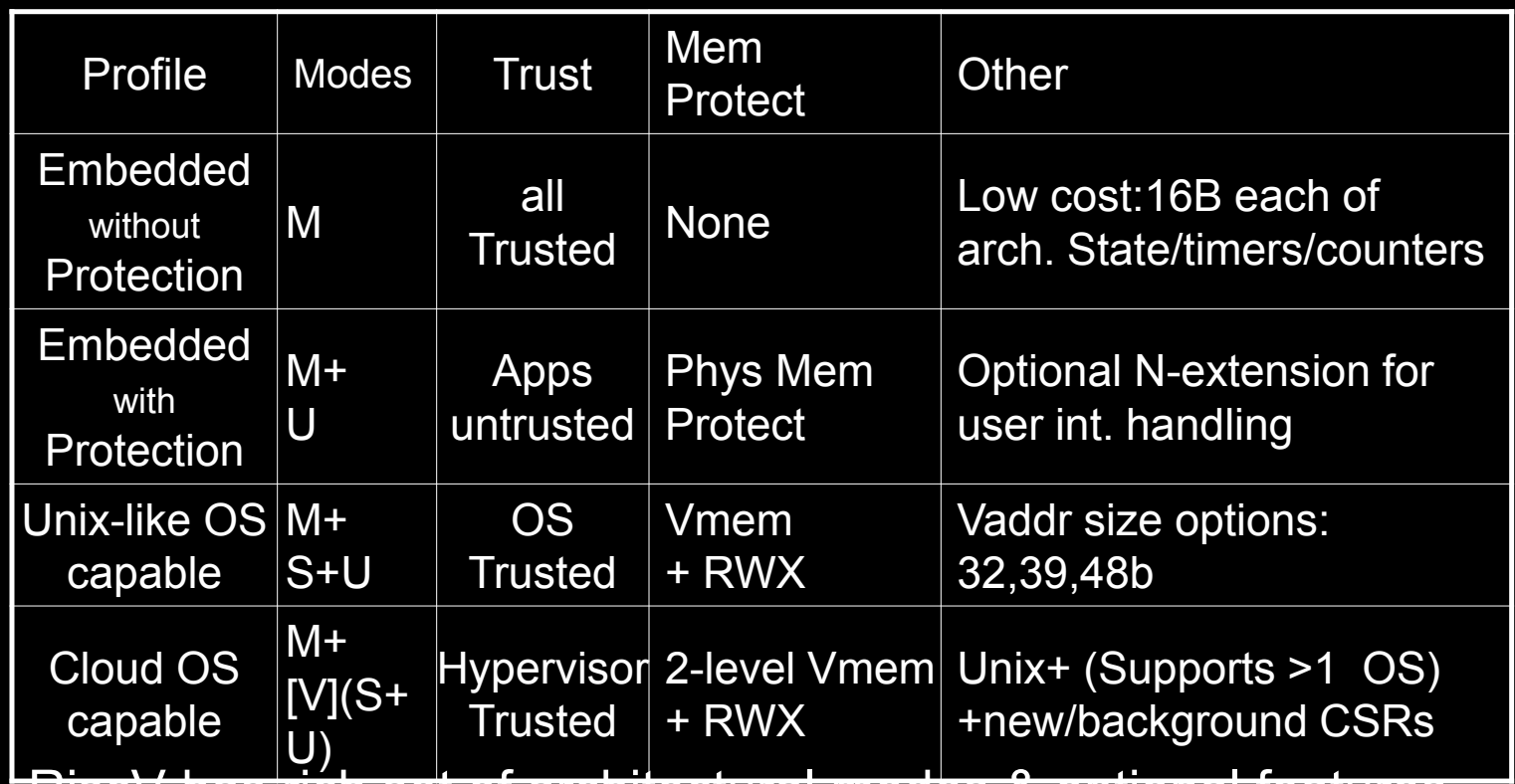

Profiles

在RISC-V特权架构中,"Profiles"定义了处理器可以支持的不同配置和特性集,以适应从简单嵌入式系统到复杂的云计算环境不等的应用需求。每个Profile描述了特定的操作模式、信任级别、内存保护方式以及其他特性,这些都是为了优化特定的使用场景而设计的。

主要的RISC-V Profiles

- Embedded without Protection:

- 模式(Modes):M(机器模式)

- 信任(Trust):所有代码均可信

- 内存保护(Mem Protect):无

- 其他特性(Other):成本低廉,拥有16B的架构状态、计时器和计数器

这个Profile适用于需要极低成本和资源使用的简单嵌入式设备,如简单的传感器或控制器。不支持内存保护,意味着所有代码都运行在机器模式下,具有完全的硬件访问权限。

- Embedded with Protection:

- 模式(Modes):M+U(机器模式和用户模式)

- 信任(Trust):应用不可信

- 内存保护(Mem Protect):物理内存保护

- 其他特性(Other):可选的N扩展,用于用户中断处理

这个Profile适用于需要隔离应用程序的更复杂嵌入式系统。通过引入用户模式,提高了系统的安全性,避免了不可信应用直接访问关键硬件资源。

- Unix-like OS Capable:

- 模式(Modes):M+S+U(机器模式、监督模式和用户模式)

- 信任(Trust):操作系统可信

- 内存保护(Mem Protect):虚拟内存和读写执行(RWX)保护

- 其他特性(Other):支持不同的虚拟地址大小(32位、39位、48位)

此Profile旨在支持类Unix的操作系统,提供完整的内存虚拟化支持和多用户环境。操作系统运行在监督模式下,管理用户模式下运行的应用程序。

- Cloud OS Capable:

- 模式(Modes):M+V(机器模式和可选的Hypervisor模式)

- 信任(Trust):Hypervisor可信

- 内存保护(Mem Protect):两级虚拟内存和RWX保护

- 其他特性(Other):支持Unix+,支持多操作系统,新的后台CSR

专为云计算环境设计,支持虚拟化技术,允许在同一硬件上运行多个虚拟机和操作系统。Hypervisor模式提供硬件级别的隔离和资源管理,优化了多租户环境的安全性和性能。

Profiles的应用

通过这些不同的Profiles,RISC-V能够为广泛的市场和应用提供灵活的解决方案。无论是低成本的嵌入式设备还是高性能的云服务器,RISC-V架构都能通过选择合适的Profile来最大化硬件的效能和适应性。这种灵活性是RISC-V在现代计算领域中逐渐成为一个重要选项的关键因素。

Privileges and Modes

RISC-V特权架构通过设置多种权限级别和操作模式来确保系统的安全性和功能完整性。这些权限模式为不同类型的任务分配了不同的权限,以确保高权限任务能够安全地管理硬件资源,而低权限任务则受到适当的限制。这种设计不仅提升了系统的安全性,还支持虚拟化、多任务处理等复杂应用。

RISC-V权限模式(Privilege Modes)

RISC-V定义了一个分层的权限模式结构,分为用户模式、监督模式和机器模式,它们以等级结构从低到高排列:

-

用户模式(User Mode,U-mode):

- 最低权限,通常用于运行用户应用程序。程序在该模式下无法直接访问硬件资源,只能通过操作系统提供的系统调用接口进行有限的操作。

- 虚拟化支持:也可在虚拟化环境下运行,虚拟机管理程序可以限制用户模式下的虚拟机行为。

-

监督模式(Supervisor Mode,S-mode):

- 中级权限,通常由操作系统内核使用。监督模式允许对硬件资源和内存管理进行更直接的控制,如页表管理和中断处理。

- 虚拟化支持:可以在虚拟化环境下运行,支持在Hypervisor管理下的操作系统执行。

-

机器模式(Machine Mode,M-mode):

- 最高权限,通常由固件或低级系统管理程序使用。该模式具有对所有硬件资源的完全访问权限,负责处理最低级别的系统初始化和管理任务,如启动、异常处理和中断控制。

- 特殊模式:还有更高的调试模式,但此处不做讨论。调试模式类似于机器模式,但用于硬件调试。

支持的模式组合

RISC-V根据应用场景支持以下几种常见的权限模式组合:

- M模式(仅机器模式):适用于简单的嵌入式系统,所有任务都在最高权限下运行,不需要复杂的内存保护。

- M + U模式:嵌入式系统中常见的组合,机器模式用于底层管理,而用户模式用于运行普通应用程序,提供了基本的内存保护。

- M + S + U模式:适用于类Unix操作系统(如Linux),在这种组合下,操作系统内核运行在监督模式,用户程序运行在用户模式,实现了虚拟内存管理和多用户隔离。

- M + [V(S + U)]模式:适用于支持多个操作系统和虚拟化的复杂系统,允许多个操作系统在虚拟机管理程序的监督下并行运行。

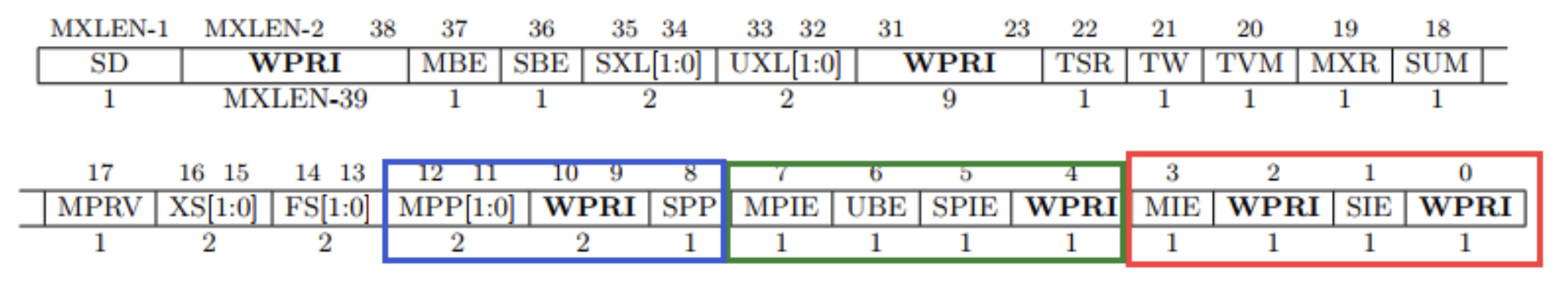

控制和状态寄存器(Control and Status Registers, CSRs)

每个特权模式都可以访问专门的控制和状态寄存器(CSRs),用于管理模式下的操作。CSRs的访问权限根据运行模式而不同,低权限模式无法访问高权限模式的寄存器,以确保系统的安全性和完整性。

- CSRs的作用:这些寄存器控制处理器的关键操作,如中断使能、内存管理以及时间计数器等。每个特权模式可以有其专属的CSR集合,以保证隔离。

- 多副本CSRs:通常,每个模式都有多个CSR副本或视图,确保不同模式下的操作隔离和安全。

通过这种分层的特权模式和CSR访问机制,RISC-V确保了系统从上电到应用程序执行的每个阶段都受到严格的权限控制,同时支持灵活的虚拟化和多操作系统环境。

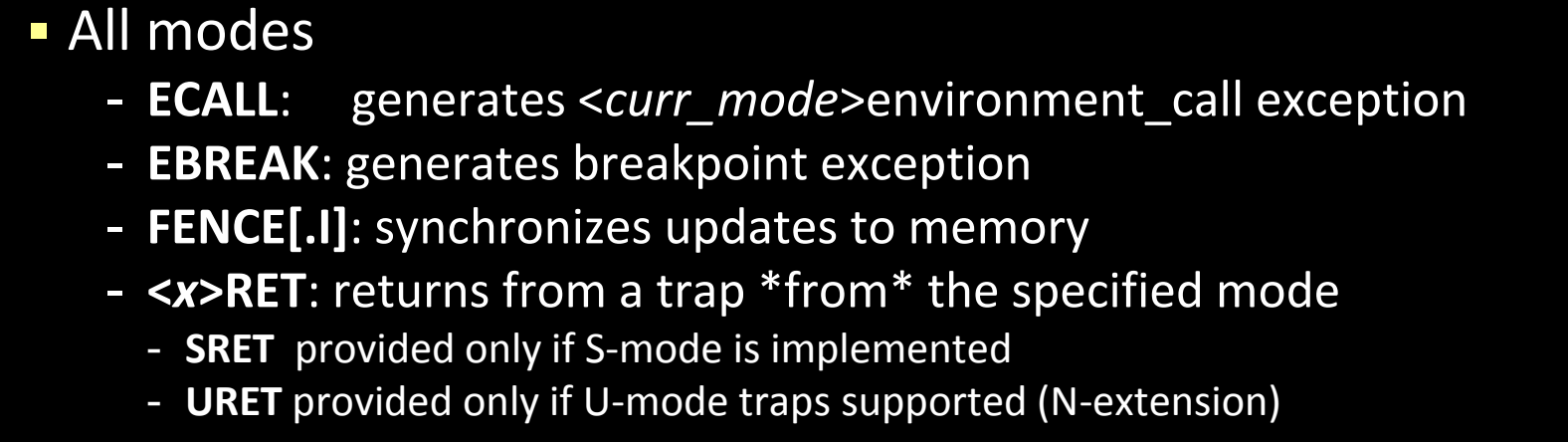

Privileged Features: Instructions and CSRs

在RISC-V架构中,特权指令和控制状态寄存器(CSRs)是特权模式下的核心功能。它们允许操作系统和固件有效地管理硬件资源,同时提供安全的多用户和多任务环境。特权指令只能在相应的特权模式(如机器模式或监督模式)下执行,确保系统的控制权不会被低权限的用户模式所滥用。

模式专属指令(Mode Specific Instructions)

RISC-V为机器模式(M-mode)和监督模式(S-mode)定义了一系列特权指令,这些指令扩展了基本的用户模式(U-mode)操作,以便在不同的权限模式下更好地控制系统。

- 特权指令只能在适当的特权模式下执行,低权限模式(如U-mode)无法访问高权限模式的指令。这些指令是为了保证不同模式间的隔离和安全。

所有模式下的指令(All Modes)

-

ECALL:

- 生成环境调用异常,触发从当前模式到更高特权模式的系统调用。

- 例如,当用户模式的应用程序需要操作系统的服务时,它会通过ECALL指令请求监督模式处理系统调用。

-

EBREAK:

- 生成断点异常,通常用于调试。

- 当程序执行到某个断点时,处理器会捕获断点并进入调试模式。

-

FENCE.I:

- 同步对内存的更新,确保指令的修改在所有后续指令中可见。

- 这一指令在多核或并发系统中尤为重要,用于确保不同处理器核心之间的内存一致性。

-

RET :- 从指定模式的异常中返回。

- SRET:用于从监督模式的陷阱或异常中返回。

- URET:用于从用户模式的异常中返回,通常在N扩展(用户模式异常)被支持时使用。

监督模式(S-mode)和机器模式(M-mode)下的特定指令

S-mode(及M-mode)新增指令

- SFENCE.VMA:

- 用于同步虚拟内存的更新。

- 此指令确保对内存页表的更改在所有处理器核心中都被正确识别,防止出现页面翻译错误。

M-mode新增指令

- WFI(Wait For Interrupt):

- 当前hart进入等待状态,直到有中断需要服务时再恢复运行。

- 该指令用于节省功耗,通常在低功耗模式下使用,是一个提示性指令,可能被实现为空操作(noop)。

特权指令的作用

特权指令的引入是为了增强RISC-V在特权模式下的控制能力。通过ECALL和EBREAK等指令,用户模式的程序可以请求高权限的服务或在调试时打断程序的执行。而诸如SFENCE.VMA和FENCE.I这样的指令则确保了内存管理和同步操作的安全性和一致性。

特权指令确保了不同模式下的隔离和安全性,同时也增强了处理器对多任务、虚拟化和并发场景的支持,使得RISC-V能够灵活适应各种复杂的系统需求。

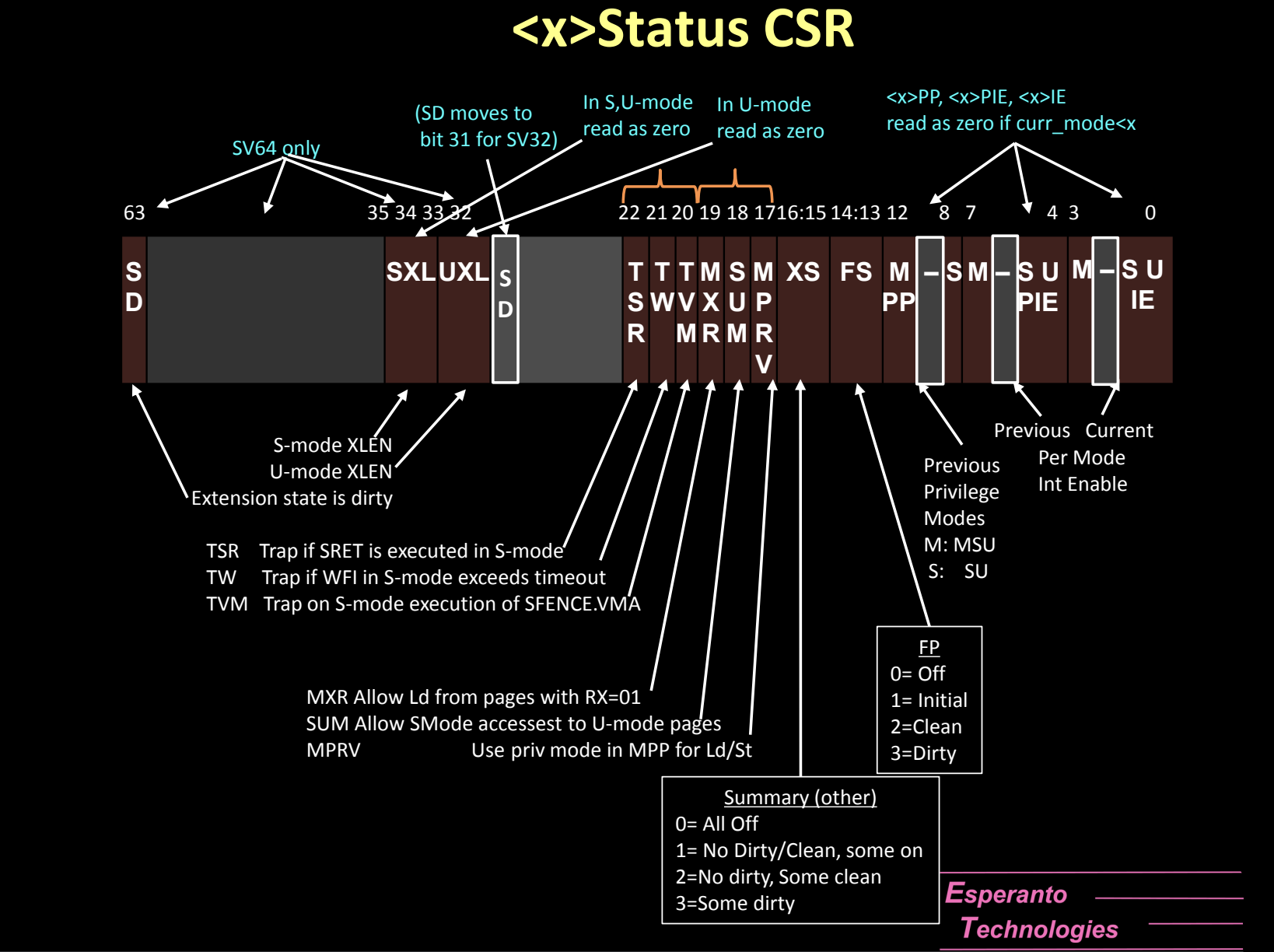

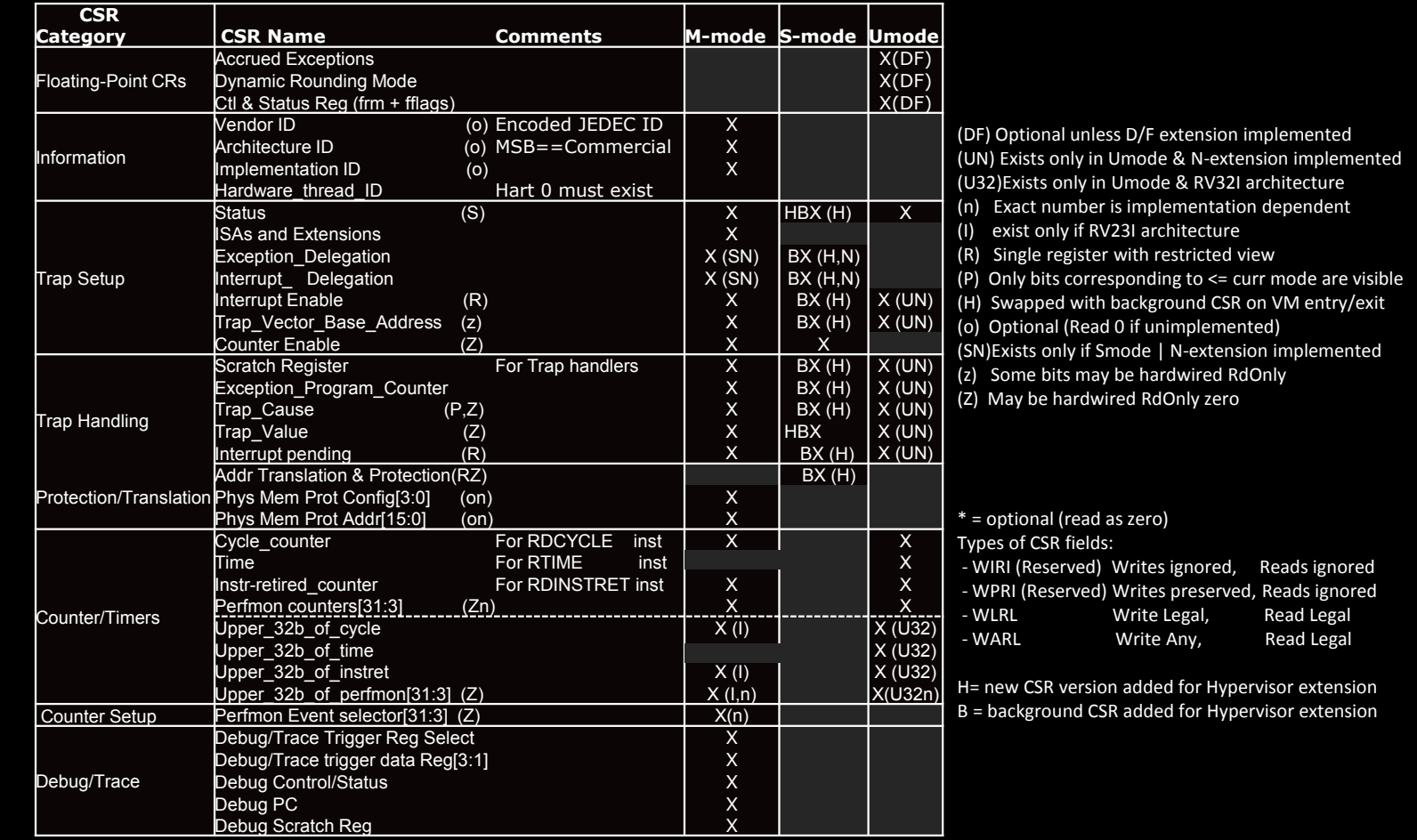

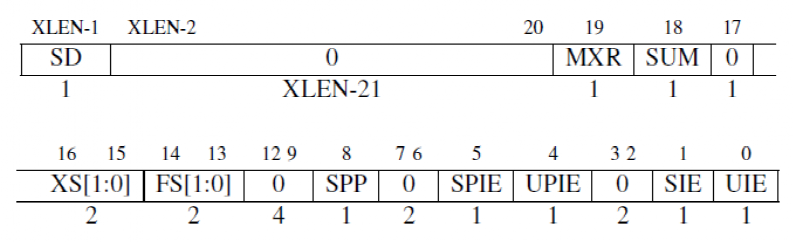

Mode Specific CSRs

控制和状态寄存器(Control and Status Registers, CSRs)是RISC-V特权架构中的重要组成部分,它们用于管理处理器的操作模式、硬件资源和系统状态。每个权限模式(用户模式、监督模式、机器模式)都有其特定的CSRs,确保不同权限模式下的任务只能访问与其权限相关的寄存器。

CSR的地址空间和访问机制

-

独立的地址空间:CSRs有自己专用的地址空间,直接通过地址访问。这意味着不同的寄存器集在各模式下有不同的编码和访问方式。

-

每个硬件线程(hart)都有自己的CSRs:每个hart(硬件线程)拥有独立的一组CSRs,通常每个模式拥有多达1000个寄存器,总共4K个CSRs(即1000个寄存器乘以4个模式)。

-

专用操作:CSRs通过特定的操作访问,例如支持原子交换或位设置/清除的指令。这些操作确保了对CSRs的高效读写。

-

模式敏感:CSRs只能被运行在相应或更高权限模式下的代码访问。低权限模式(如用户模式)尝试访问高权限模式(如机器模式)的寄存器时,会触发陷阱(trap),从而保护系统安全。

可选和只读CSRs

许多CSRs是可选的,或者具有可选字段,其行为依赖于具体实现:

- 访问不存在的CSRs会触发陷阱:如果某一特权模式的代码尝试访问一个不存在的CSR,处理器会产生异常。

- 只读寄存器的写操作会触发陷阱:尝试写入只读寄存器时,也会产生异常。不过,如果是只读/读写寄存器中的只读字段,写入操作将被忽略,不会触发异常。

- 可选寄存器的访问:可选寄存器在没有实现时,会读取为零,并且(如果是读写寄存器)忽略写入操作。

这使得系统的实现具有高度灵活性,不同的处理器可以根据需要实现不同的CSRs集,依赖于具体的架构和应用需求。

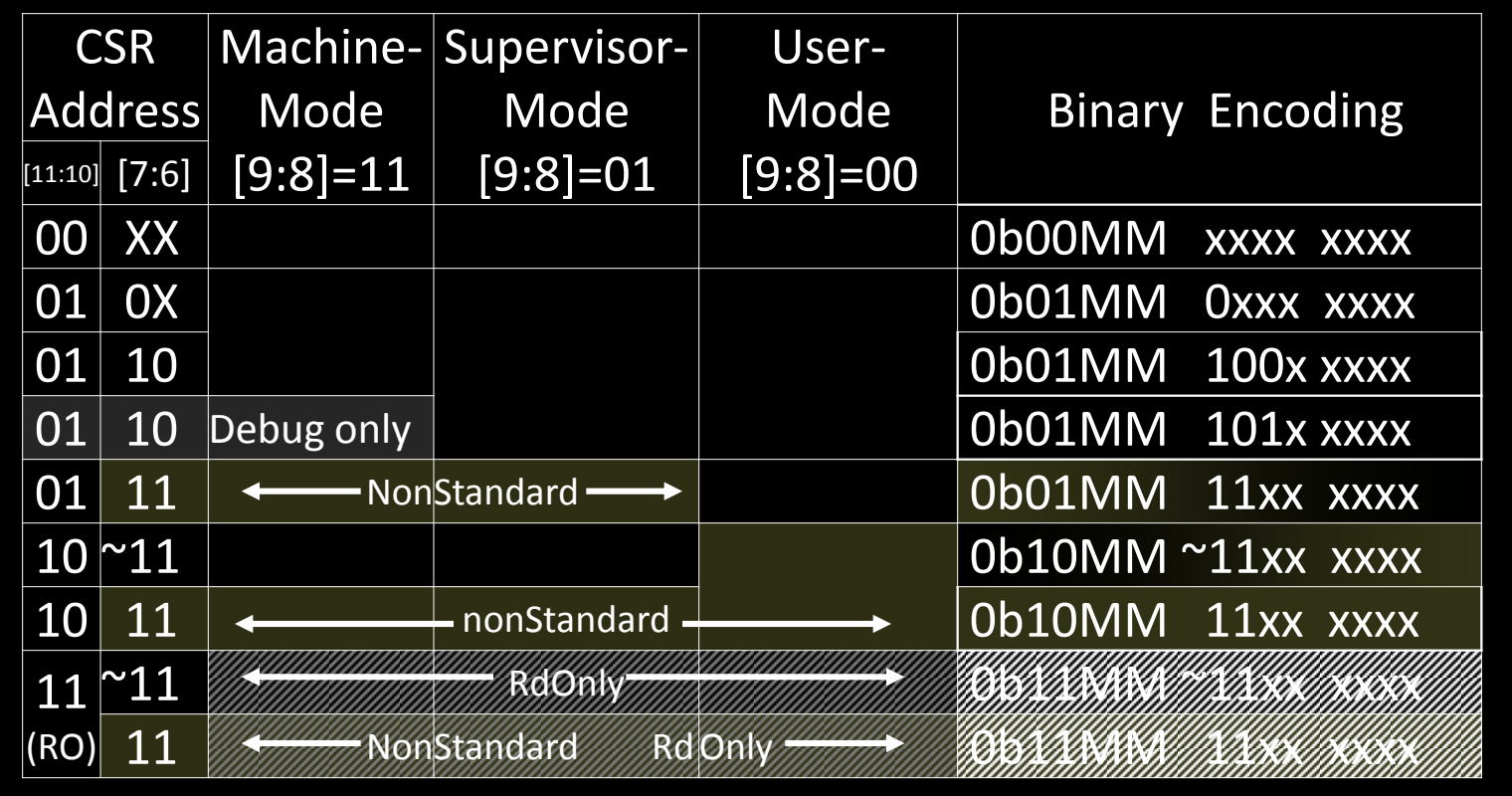

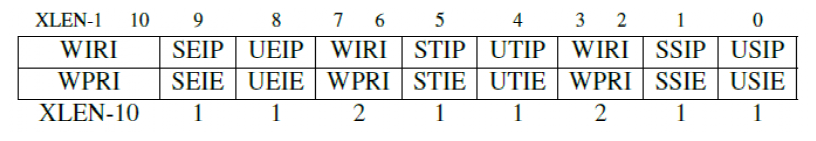

CSR Address Space

在RISC-V架构中,控制和状态寄存器(Control and Status Registers,CSRs)是用来管理处理器的操作模式、硬件资源和系统状态的核心组件。不同的特权模式下,处理器会使用不同的CSR集,确保权限隔离。CSR地址空间由多层结构组成,遵循特定的编码规则,用于区分不同的模式和寄存器。

CSR地址的编码结构

CSR地址是12位的二进制值,用来标识不同的寄存器。具体的编码结构如下:

- 高两位[11:10]:用于定义CSR的类型。

- 中两位[9:8]:用于区分不同的特权模式:

00:用户模式(U-mode)专用的CSRs01:监督模式(S-mode)专用的CSRs11:机器模式(M-mode)专用的CSRs10:为虚拟机管理程序(Hypervisor,V-mode)保留,当前版本尚未实现。

- 其余位[7:6]:用于标识CSR的具体种类和用途。

通过这种结构,RISC-V的CSR地址可以灵活地支持不同的模式、权限级别和操作需求。

CSR地址空间划分

CSR地址空间分为多个区域,每个区域对应不同的特权模式。根据特定的二进制编码,CSR地址的用途如下表所示:

| CSR地址 | 机器模式(M-mode) | 监督模式(S-mode) | 用户模式(U-mode) | 二进制编码说明 |

|---|---|---|---|---|

00 XX | - | - | 可访问 | 0b00MM xxxx xxxx 用户模式专用寄存器 |

01 0X | - | 可访问 | - | 0b01MM 0xxx xxxx 监督模式下的常规寄存器 |

01 10 | 可访问 | - | - | 0b01MM 100x xxxx 调试模式专用寄存器 |

01 11 | 非标准(NonStandard) | - | - | 0b01MM 11xx xxxx 非标准寄存器 |

10 ~11 | - | - | - | 0b10MM ~11xx xxxx 保留给虚拟化支持的CSR |

11 ~11 | 只读(ReadOnly) | 非标准(NonStandard) | 只读(ReadOnly) | 0b11MM 11xx xxxx 机器模式的只读寄存器 |

关键编码细节

-

0b00MM xxxx xxxx:这些CSR主要供用户模式使用,最低权限,通常用于用户程序的控制状态信息,如性能计数器或用户态的软中断控制等。 -

0b01MM xxxx xxxx:这些CSR供监督模式和调试模式使用,权限较高,典型的应用是页表管理、内存访问控制和中断处理等。监督模式的操作系统内核可以使用这些CSR来管理用户进程。 -

0b11MM xxxx xxxx:这些CSR为机器模式(M-mode)专用,权限最高。通常,这些寄存器用于系统初始化、硬件配置以及固件层面的管理。 -

0b10MM xxxx xxxx:这一段目前保留给虚拟化支持(Hypervisor mode)。虽然当前版本的RISC-V规范尚未全面实现虚拟化,但这一编码区域为将来虚拟机管理程序的功能预留了空间。将来,虚拟机管理程序会通过这些CSR来管理多虚拟机的操作。

特殊类型的CSR

-

只读寄存器(ReadOnly):某些寄存器是只读的,用于存储系统状态或硬件信息,这类寄存器在低权限模式下也可以读取,但无法被写入。

-

非标准寄存器(NonStandard CSRs):有些CSR的地址编码不属于RISC-V标准,通常由处理器厂商或特定实现提供。这类CSR通常是硬件优化或扩展功能的一部分,处理器厂商可以根据需要定义。

-

调试模式专用CSR:

01 10开头的CSR是调试模式下专用的,用于在调试环境中保存系统的状态信息并控制调试操作。这些寄存器只有在调试端口连接时才能访问。

错误处理与陷阱机制

-

访问不存在的CSR:如果代码试图访问不存在的CSR,处理器会触发一个陷阱(trap),即系统会捕获这个错误并执行相应的异常处理程序。

-

写入只读CSR:同样,试图写入只读CSR也会触发陷阱,这种机制确保了系统的稳定性,防止低权限模式中的错误操作破坏关键数据。

-

可选CSR:某些CSR是可选的,具体实现时可以有选择地支持这些寄存器。如果某个CSR在实现中不存在,处理器在读取时将返回零,并且在写入时忽略操作。

CSR地址空间通过严格的编码规范,确保了不同特权模式下的CSR访问权限划分。机器模式(M-mode)拥有最高权限,能够访问最广泛的CSR集合,而监督模式(S-mode)和用户模式(U-mode)的权限则逐步递减。这种设计保障了系统的安全性和稳定性,同时为未来的扩展(如虚拟化支持)预留了足够的灵活性。

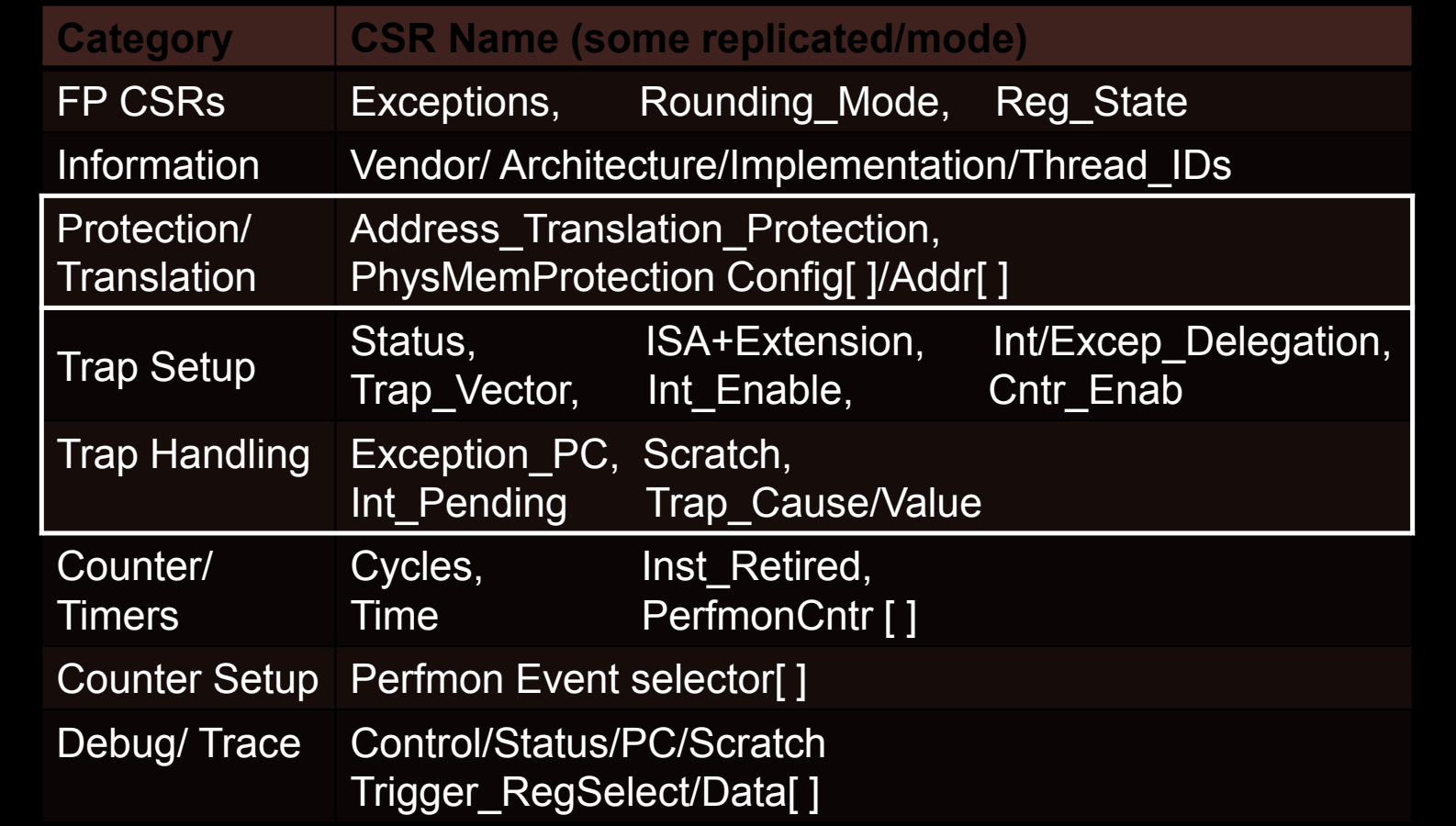

CSRs and Categories

RISC-V架构中的控制和状态寄存器(CSRs)根据其功能被划分为不同的类别,每个类别负责管理处理器的某一方面操作。CSRs为处理器提供了对硬件资源的精细控制和状态监控,涵盖了从异常处理、内存保护到计时器、调试等多个领域。部分CSR在不同的模式(如M-mode、S-mode、U-mode)下会有各自的副本或复制,这样可以保证不同权限级别的隔离性。

主要CSR类别

-

FP CSRs(浮点运算相关)

- 这些寄存器主要用于管理浮点操作和状态。它们负责处理浮点运算的异常、舍入模式以及浮点寄存器的状态。

- 关键CSR名称:

- Exceptions:用于浮点异常的处理。

- Rounding_Mode:控制浮点运算的舍入模式。

- Reg_State:浮点寄存器的状态保存。

-

Information(信息寄存器)

- 这些CSR保存处理器的厂商信息、架构标识、实现细节以及当前硬件线程的ID。

- 关键CSR名称:

- Vendor/Architecture/Implementation:用于识别处理器的厂商、架构版本和实现方式。

- Thread_IDs:管理多线程或多核心系统中每个hart(硬件线程)的标识符。

-

Protection/Translation(保护和地址翻译)

- 这些CSR用于虚拟内存的地址翻译和物理内存的保护,特别是在多任务操作系统中,保证不同任务之间的内存隔离。

- 关键CSR名称:

- Address_Translation_Protection:控制虚拟地址到物理地址的翻译,并应用内存保护。

- PhysMemProtection Config[]/Addr[]:管理物理内存保护的配置和地址。

-

Trap Setup(陷阱设置)

- 这些寄存器用于设置和配置异常(trap)的行为,例如指定异常向量地址或启用特定类型的异常处理。

- 关键CSR名称:

- Status:保存处理器的当前状态,如当前运行模式、全局中断使能等。

- Trap_Vector:指定异常处理程序的入口地址。

- Int_Enable:启用或禁用中断。

- Cntr_Enab:启用或禁用特定的计数器功能。

-

Trap Handling(陷阱处理)

- 这些CSR用于处理异常事件,包括保存异常发生时的处理器状态和异常的原因。

- 关键CSR名称:

- Exception_PC:保存异常发生时的程序计数器(PC)值,以便在异常处理完成后返回。

- Scratch:用于异常处理中的临时数据存储。

- Int_Pending:记录当前待处理的中断。

- Trap_Cause/Value:保存异常的原因和相关数据。

-

Counter/Timers(计数器和计时器)

- 这些寄存器用于记录处理器的周期数、时间以及指令执行情况,通常用于性能监控和系统调度。

- 关键CSR名称:

- Cycles:记录处理器执行的时钟周期数。

- Time:用于记录处理器的运行时间。

- Inst_Retired:记录处理器已执行的指令数。

- PerfmonCntr[]:性能监控计数器,用于跟踪性能指标。

-

Counter Setup(计数器设置)

- 用于配置性能监控事件,选择哪些事件需要计数。

- 关键CSR名称:

- Perfmon Event selector[]:性能监控事件的选择器。

-

Debug/Trace(调试与跟踪)

- 这些寄存器用于系统的调试和跟踪功能,帮助开发者分析程序执行情况和定位问题。

- 关键CSR名称:

- Control/Status/PC/Scratch:调试模式下的控制与状态寄存器,用于保存调试过程中的状态。

- Trigger_RegSelect/Data[]:调试触发器寄存器,用于调试时设置条件断点或数据监控。

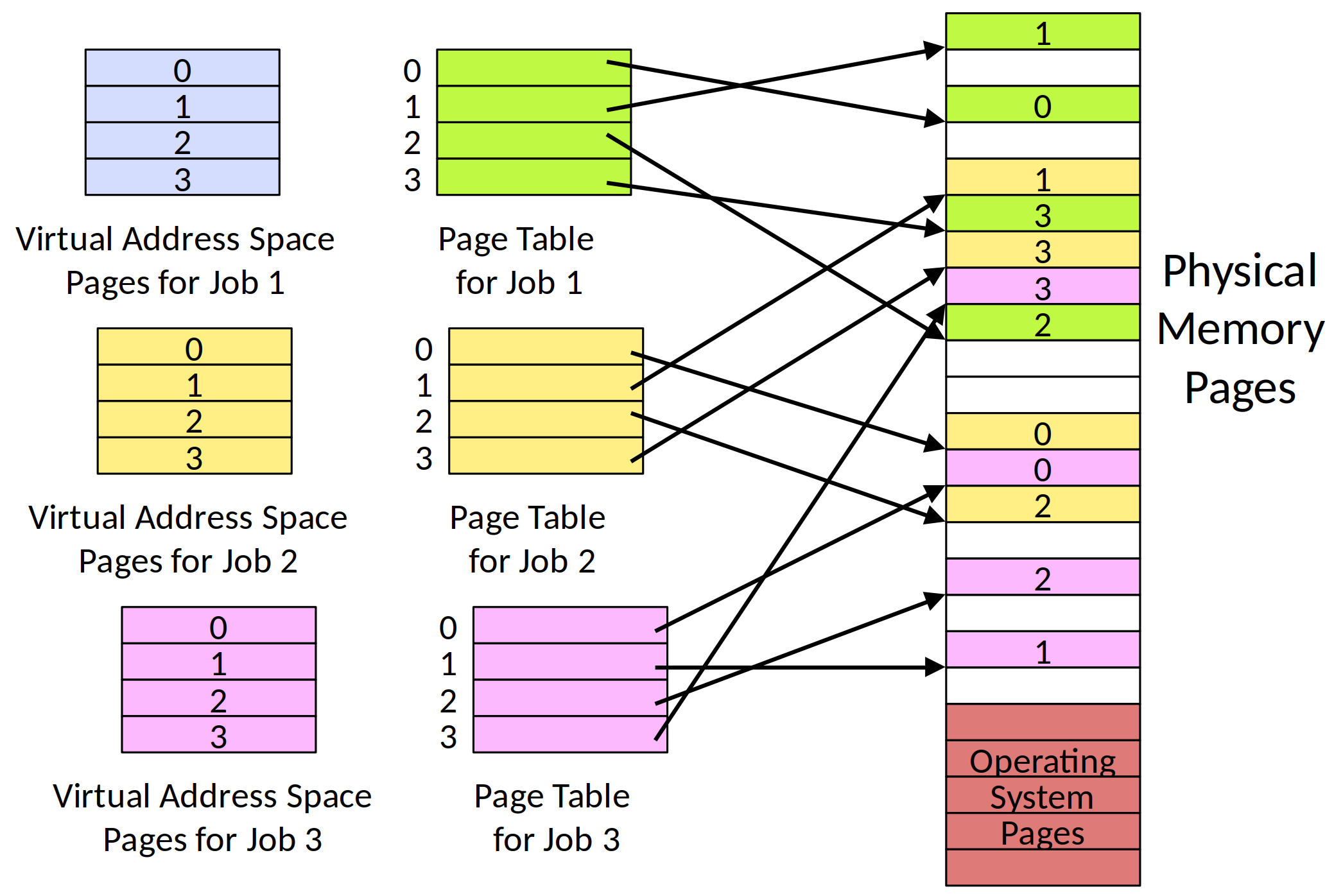

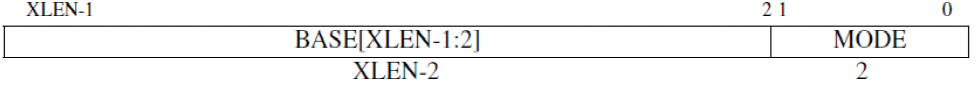

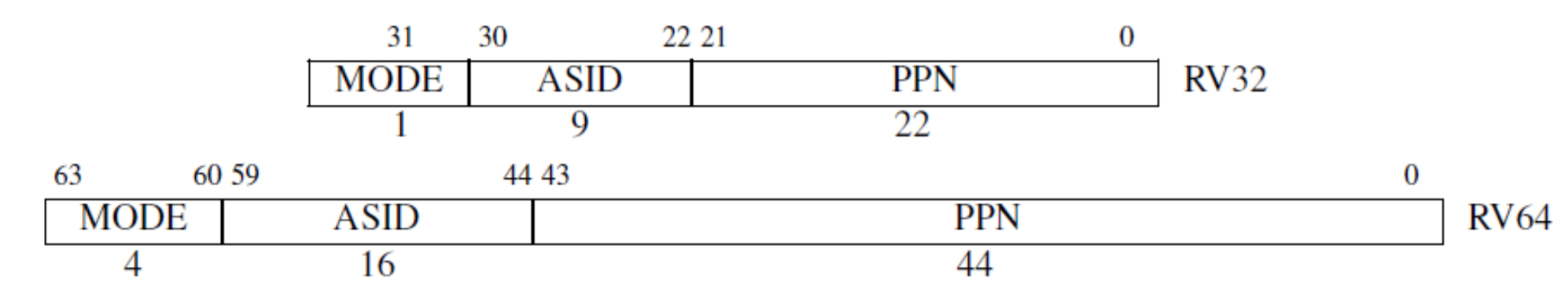

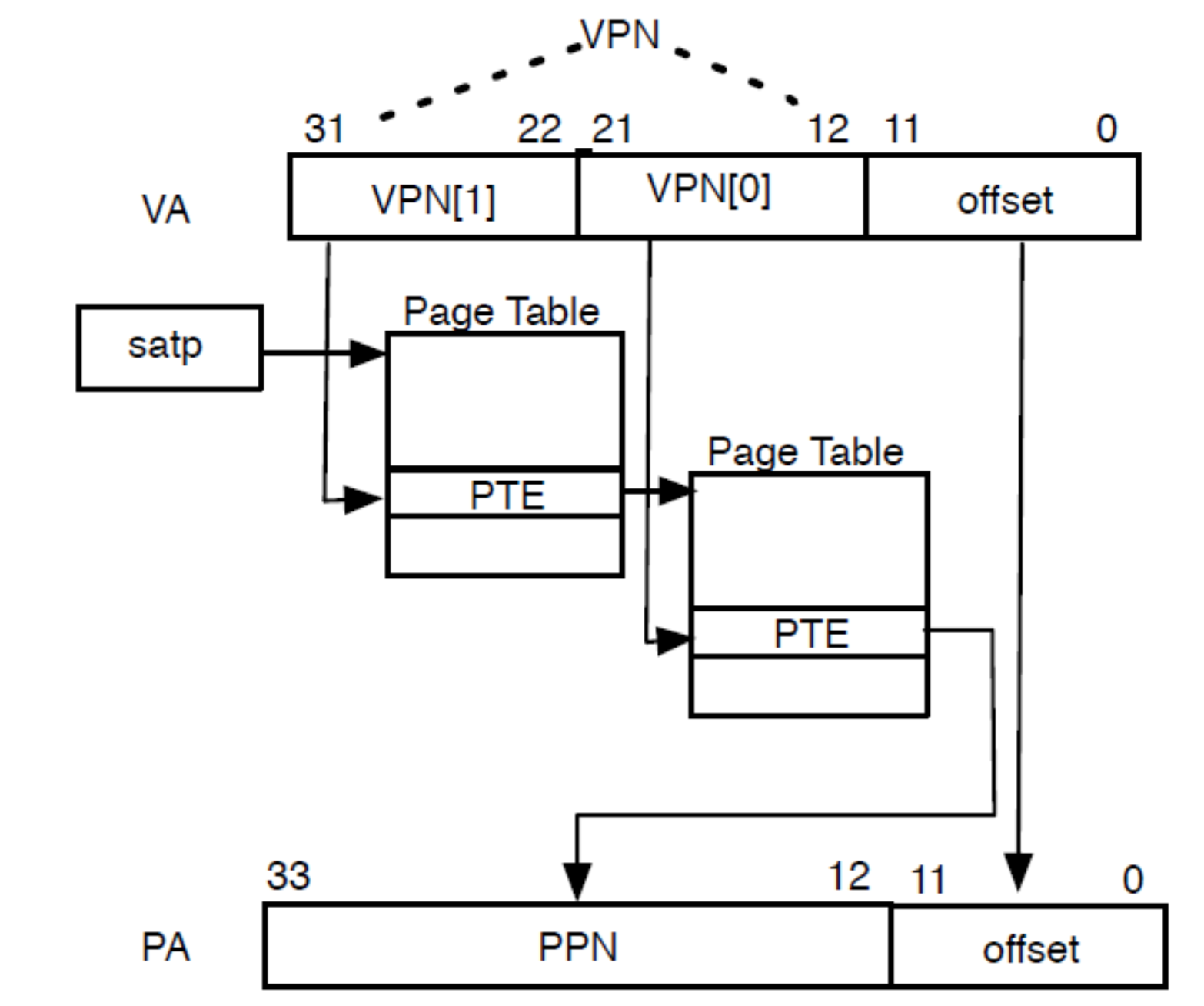

Memory Addressing: Translation

在RISC-V架构中,虚拟内存是监督模式(S-mode)下的重要功能,它通过页表机制将虚拟地址映射到物理地址,为多进程操作系统提供内存隔离和保护。虚拟内存的引入允许用户模式下的程序拥有各自独立的地址空间,避免直接访问物理内存,从而提升系统的安全性和稳定性。

S-mode中的虚拟内存页映射

- 最小保护/映射单位是4 KB的页面:

- RISC-V的虚拟内存使用固定大小的页面来进行地址映射,通常情况下每个页面大小为4 KB。4 KB是虚拟内存映射的最小单位,也是分页机制的基本单位。

多用户进程支持

- 支持多个用户模式进程,分别拥有独立的地址空间:

- 通过使用SATP(Supervisor Address Translation and Protection)CSR中的Addr_Space_ID字段,RISC-V能够为每个用户模式进程分配独立的地址空间。这使得多个进程可以安全并行运行,而不会互相干扰或影响彼此的数据。

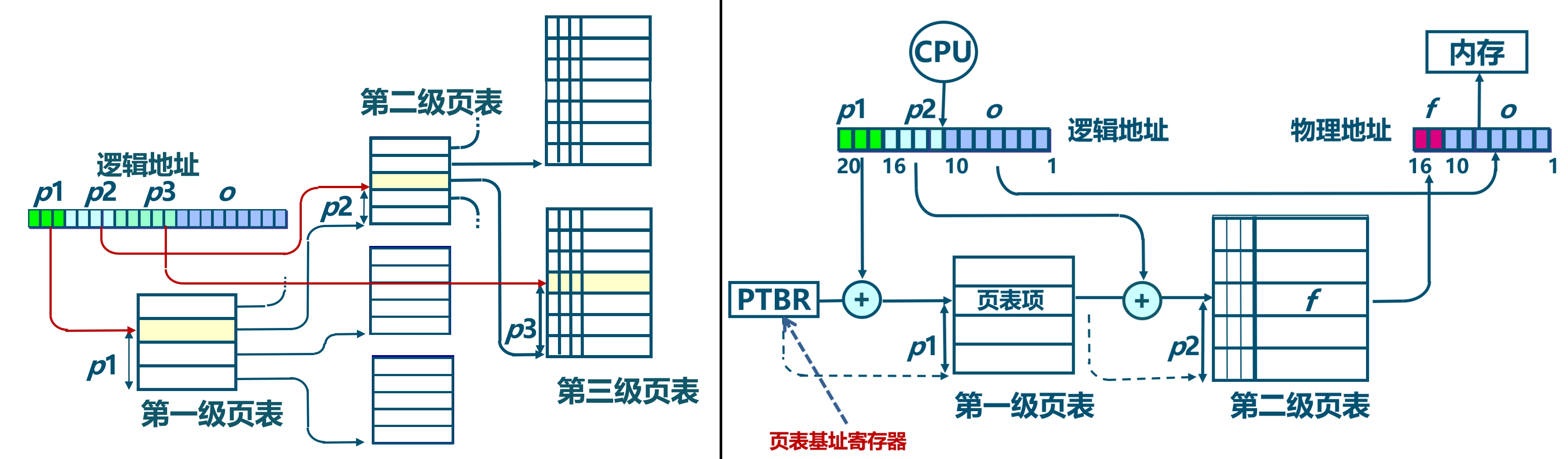

页表(Page Tables)的多级结构

RISC-V采用了多级页表机制来实现虚拟地址到物理地址的映射。这种分层结构的页表能够有效管理大量内存,同时支持不同的虚拟地址长度和物理地址长度。

- 页表级数:

- Sv32(32位架构):使用2级页表,适用于RISC-V的32位架构(RV32)。

- Sv39、Sv48(64位架构):分别使用3级或4级页表,适用于RISC-V的64位架构(RV64)。这些页表机制允许处理更大的内存空间。

- Sv57、Sv64(保留机制):这两个机制保留用于未来可能的更大虚拟地址或物理地址空间(如57位或64位地址空间的处理器)。

超大页面(Superpages)

- 页表遍历可以在任意级别停止以创建超级页:

- 在RISC-V中,超级页是比4 KB常规页更大的内存页块。通过在不同层级的页表遍历中提前停止,可以实现超级页的映射。

- 例如:

- 在Sv39架构下,如果页表遍历在第2级停止,可以映射2 MB的超级页。

- 如果遍历在第1级停止,则可以映射1 GB的超级页。

- 超级页的存在显著减少了页表项的数量,优化了大数据集或大内存应用的内存管理。

硬件页表遍历机制

- 硬件页表遍历语义由特权模式规范(Privileged Mode Spec)定义:

- RISC-V硬件负责自动遍历页表以进行地址转换。硬件会按照特权模式规范中定义的方式,逐级遍历页表项来完成虚拟地址到物理地址的映射。

- 如果硬件无法完成页表遍历,可能会触发陷阱(trap),并进入机器模式(M-mode)以进行软件方式的TLB(Translation Lookaside Buffer)重填。

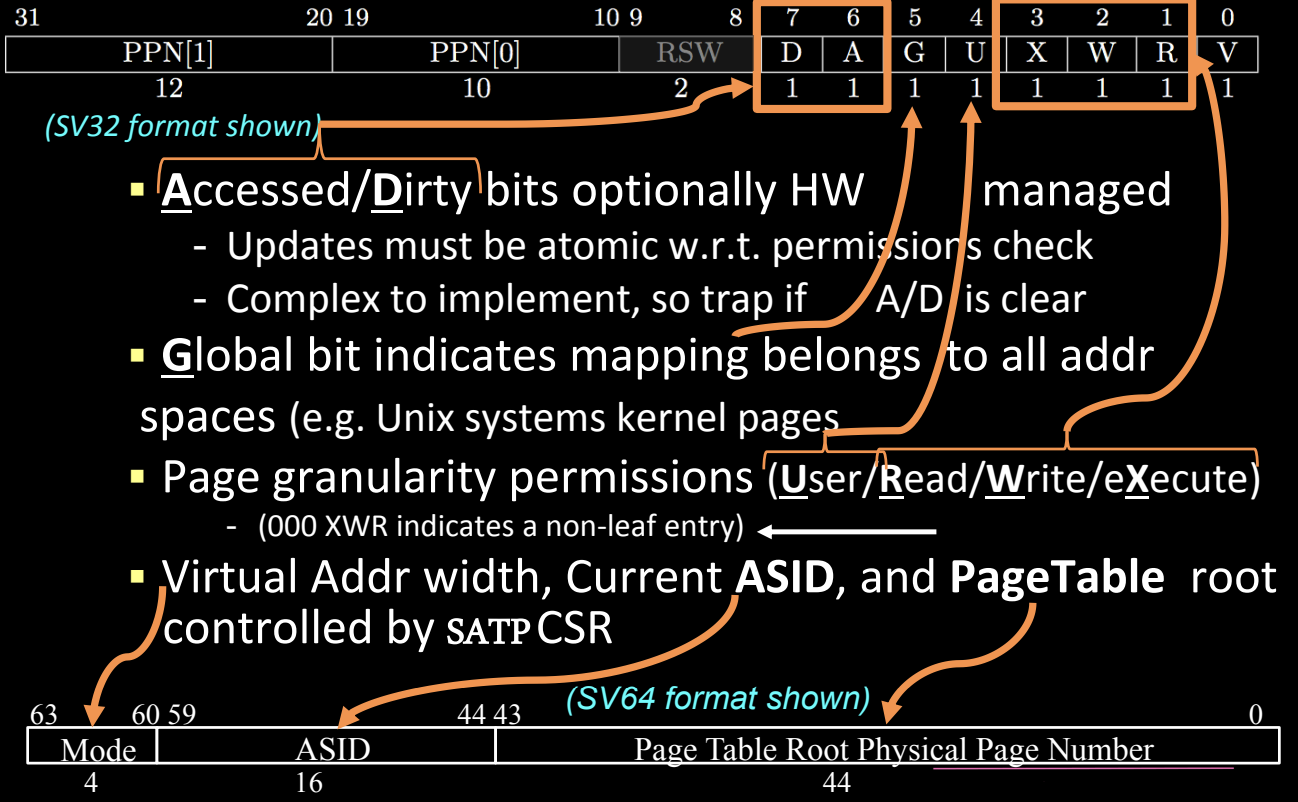

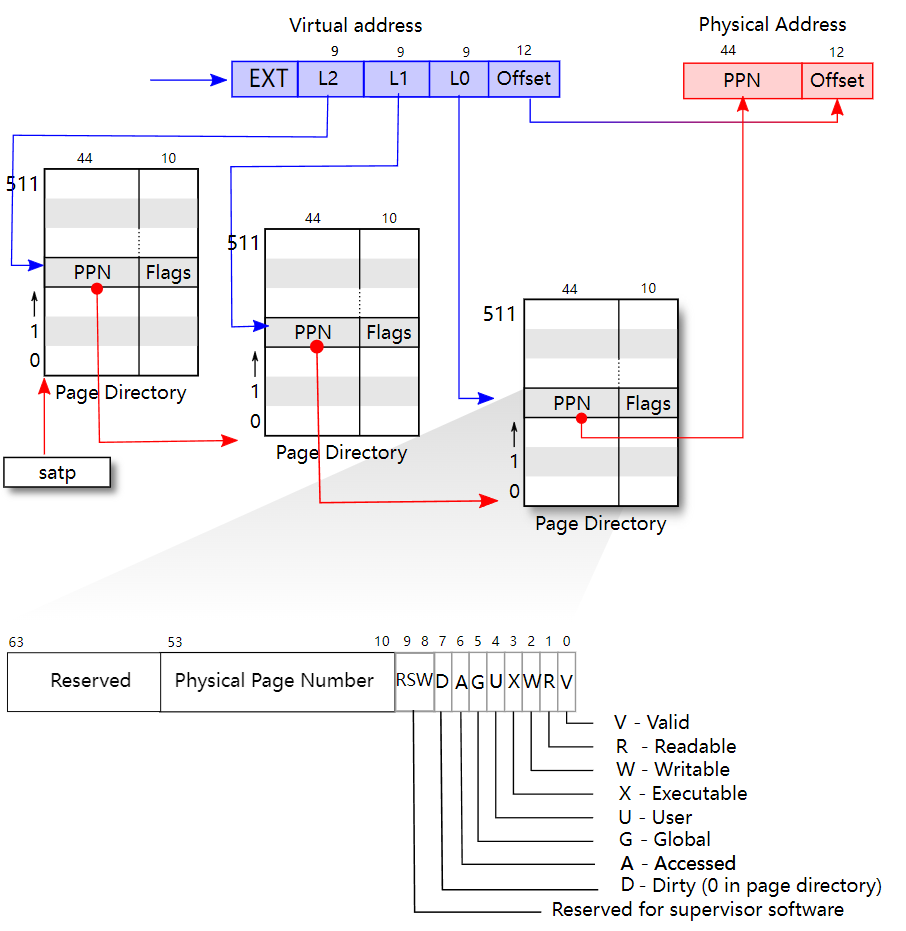

RISC-V Page Table Entries (PTEs)

可参见 Lzzs 6.S081 Notebook: Page Tables

在RISC-V虚拟内存机制中,页表条目(Page Table Entries, PTEs)负责将虚拟地址映射到物理地址,并定义了每个内存页面的权限和状态。每个PTE包含多个字段,这些字段共同决定内存访问的规则、状态和权限。根据虚拟地址的格式(如Sv32、Sv39、Sv48或Sv64),PTE的结构可能有所不同。

页表条目的结构

以下是以Sv32格式为例的页表条目(PTE)结构,其字段解释如下:

-

PPN(物理页面号,Physical Page Number):用于指定映射的物理页面地址。

- PPN[1] 和 PPN[0] 是物理地址的一部分。PPN字段可以根据虚拟地址空间的大小有不同的长度,比如Sv32、Sv39、Sv48和Sv64的长度各不相同。

- PPN字段在最终的物理地址形成中起关键作用,它决定虚拟地址指向的物理内存块。

-

RSW(保留位,Reserved for Supervisor):这些位由操作系统内核自行使用,不会被硬件直接处理。通常用于页表管理和内存分配的额外元数据。

-

D位(Dirty):标识页面是否被写入过。

- 如果页面被修改过,D位会被设置为1,表示该页面已经“脏”,需要同步回主存。

- 如果没有设置,可能需要陷阱(trap)到软件层进行处理。

-

A位(Accessed):标识页面是否被访问过。

- 当该页面被读取或写入时,A位会被设置为1,用于管理页面的生命周期或优化内存交换策略(如LRU)。

- 如果A位未设置,也可能触发陷阱处理。

-

G位(Global):指示该映射是否在所有地址空间中全局可见。

- 如果该位设置为1,则此映射对于所有进程都是全局有效的(如Unix系统中的内核页面),在进程切换时不需要刷新TLB。

-

U位(User):控制页面是否可被用户模式访问。

- 如果设置为1,用户模式代码可以访问该页面。

- 如果为0,则该页面只能被更高权限的模式(如S-mode或M-mode)访问。

-

X位(Execute):控制页面是否可被执行。

- 设置为1时,页面上的内容可以作为指令执行。

- 如果为0,则不允许执行,防止代码注入或其他安全风险。

-

W位(Write):控制页面是否可写。

- 设置为1时,允许对页面进行写操作;否则,写操作将被禁止。

-

R位(Read):控制页面是否可读。

- 设置为1时,允许读取页面内容;否则,读取操作将被禁止。

-

V位(Valid):指示该页表项是否有效。

- 如果V位为0,则该页表项无效,访问该页面时会触发异常。

页粒度的权限设置

- 权限(User/Read/Write/eXecute):RISC-V PTE支持按粒度设置页面的用户权限,包括读、写和执行权限。如果某个页表条目未设置任何权限位(即000),则该页表项表示为非叶子节点,指向下一层页表。

多地址空间的支持

- Addr_Space_ID(地址空间ID,ASID):用于支持多进程系统。每个进程的地址空间都有独立的ASID字段,存储在SATP(Supervisor Address Translation and Protection)CSR中。SATP管理当前虚拟地址的宽度、当前进程的ASID以及页表根地址。

多级页表的遍历

根据不同的虚拟地址长度,RISC-V支持不同级数的页表。以Sv64为例,PTE的格式适配64位虚拟地址,在SATP中包括44位的页表根物理地址、16位的ASID和4位的模式字段。

Memory Fences: More Control

内存屏障(Memory Fences)在多处理器系统中确保不同处理器核之间的内存访问顺序一致性。RISC-V引入了SFENCE.VMA指令,用于同步内存结构的更新,特别是页表。

SFENCE.VMA 指令

- S-mode下的SFENCE.VMA:这条指令用于同步虚拟内存数据结构的更新,特别是在修改页表之后,确保新的页表项能够被处理器正确使用。

- 作用范围:

- 可以作用于所有页表级别,或者只影响与特定地址相关的级别。

- 可以作用于所有地址空间,或者仅影响当前地址空间。

- 作用范围:

页表同步与TLB刷新

- 类似于其他架构的TLB刷新:在许多处理器架构中,当页表发生变化时,需要刷新TLB(Translation Lookaside Buffer,翻译后备缓冲区),以避免旧的映射被继续使用。RISC-V通过SFENCE.VMA实现这一功能。

确保指令顺序

- 确保存储操作有序:SFENCE.VMA可以确保所有先前的存储操作在后续的隐式内存访问前完成,防止出现内存顺序紊乱的情况。

影响范围

- 仅影响本地hart(硬件线程):SFENCE.VMA指令只影响发出指令的当前hart。如果需要与其他hart同步,通常通过IPI(Inter-Processor Interrupt)进行通知。

SFENCE.VMA 和 FENCE.I 都是RISC-V架构中用于处理内存同步和一致性的指令,但它们的作用和使用场景有所不同。让我们详细对比它们的功能与用途,并解释为什么在操作系统(如xv6)中会用到FENCE.I作为内存屏障。

1. SFENCE.VMA:虚拟内存的同步

全称:Supervisor Fence Virtual Memory Address

作用:用于同步虚拟内存的页表更新。具体来说,当修改页表(例如创建新的页面映射或释放旧页面)后,需要通过SFENCE.VMA指令来确保这些修改对处理器的地址翻译单元(如TLB,Translation Lookaside Buffer)可见。

使用场景:

- 当操作系统更新页表或修改虚拟内存结构时,必须确保这些更新被所有内存操作正确识别。在不执行SFENCE.VMA的情况下,TLB可能仍然保留旧的虚拟地址到物理地址的映射,导致系统使用过时的数据。

- SFENCE.VMA通常由内核代码调用,用于清除当前硬件线程(hart)中与虚拟地址相关的TLB条目,确保地址翻译映射的正确性。

示例:如果操作系统为进程分配了新的内存页面或者进行了页表的切换(例如,切换到一个新的进程地址空间),SFENCE.VMA指令会确保处理器清除缓存的旧地址映射,并使用新的页表。

2. FENCE.I:指令缓存的同步

全称:Fence Instruction

作用:FENCE.I用于同步指令缓存(I-cache)与内存。当在内存中修改了代码(例如动态加载新代码或自修改代码的场景),FENCE.I指令确保指令缓存中的旧指令被清除,并强制处理器从内存中重新加载最新的指令。

使用场景:

- 当内存中存储的指令被修改后,指令缓存和内存之间可能会不一致。为了确保处理器执行最新修改的指令,必须使用FENCE.I,清除缓存并刷新指令流。

- FENCE.I 通常用于内存中的代码被动态修改的场景。例如,操作系统在某个位置加载了一段新的代码,这时就需要使用FENCE.I来保证处理器看到的是最新的代码。

示例:在操作系统xv6中,使用FENCE.I指令作为内存屏障,确保处理器在加载新指令后执行正确的指令流。特别是当进程从用户模式切换到内核模式,或者当处理器加载新的用户态代码后,使用FENCE.I可以避免执行缓存中的旧指令。

两者的主要区别

功能/特性 SFENCE.VMA FENCE.I 目的 用于同步页表更新,清除TLB中的旧虚拟地址到物理地址映射 用于同步指令缓存,确保指令缓存与内存的一致性 影响范围 虚拟内存(页表和TLB) 指令缓存 使用场景 当页表更新或地址空间切换时使用 当内存中的指令被修改或动态加载代码时使用 触发对象 内存地址映射的变化(如进程切换、页表修改) 内存中代码修改或动态生成代码的场景 影响对象 影响当前hart的虚拟地址空间翻译 影响当前hart的指令缓存 为什么xv6使用FENCE.I?

在操作系统(如xv6)中,通常有一些场景需要动态修改内存中的指令,或者加载新的程序代码到内存中。此时,为了确保处理器执行的是内存中的最新代码,而不是已经缓存的旧指令,必须使用FENCE.I来刷新指令缓存,保证代码的正确性。例如,当xv6从内核模式切换到用户模式,或者从磁盘加载新的程序时,FENCE.I确保处理器执行的指令是最新加载的。

SFENCE.VMA 则更多用于处理虚拟地址映射的变化。如果xv6进行页面映射的更改,或切换到新的地址空间,它则会用到SFENCE.VMA。

Memory Addressing: Protection

RISC-V特权架构中的虚拟内存保护机制通过设置每个页面的权限来保证系统的安全性和稳定性。虚拟内存的保护不仅包括传统的读、写、执行(RWX)权限,还引入了针对不同特权模式的访问控制,从而确保内核与用户进程之间的隔离。

页面权限(RWX)

- 标准的RWX权限:每个虚拟内存页面可以配置读(R)、写(W)、执行(X)权限组合。这样做确保了特定页面的访问权限明确,可以精细控制哪些页面可以被读取、写入或执行。

- 支持执行权限单独设置(X-only pages):可以将页面设为只允许执行(X-only),这对于一些存储代码但不需要写入的页面很有用。

- 写和非读(W和非R)的组合被保留:在当前架构中,不允许页面被设置为可写但不可读。这种组合通常没有实际应用,并且可能导致安全漏洞,因此在设计中被保留未使用。

监督模式(S-mode)的内存访问限制

- 默认情况下,S-mode不能访问用户模式(U-mode)的页面:

- 这种设计有助于检测操作系统或驱动程序中的潜在错误,并确保用户进程与内核的隔离。

- 如果S-mode需要读取用户内存(例如处理系统调用时),可以通过设置sStatus寄存器中的"Supervisor Access to User Memory"(SUM)位来暂时允许S-mode访问用户内存。

- SUM位的设置过程是暂时的,S-mode读取用户内存后,应立即关闭此权限,确保安全性。

- S-mode无法从U-mode页面执行代码,即使SUM位被设置为1。这种设计防止了潜在的权限升级攻击。

执行页面的保护

- S-mode默认不能读取只执行(execute-only)页面:

- 执行权限和读取权限是独立设置的,S-mode无法读取仅设置了执行权限的页面。这样可以防止未经授权的内核代码试图读取用户模式中的代码页面内容。

- 如果必须读取执行页面(例如非法指令陷阱处理程序需要读取指令内容),可以通过设置sStatus寄存器中的“Make eXecutable Readable”(MXR)位来覆盖默认行为。

虚拟内存的启用与禁用

- S-mode可以启用或禁用虚拟内存(VM):通过控制SATP(Supervisor Address Translation and Protection)寄存器中的模式字段,S-mode可以选择启用或禁用虚拟内存管理(例如在嵌入式系统或裸机环境中可能不需要虚拟内存)。

- 选择页表的深度:S-mode还可以通过SATP寄存器选择页表的深度,以适应不同的地址空间需求。例如,使用Sv32、Sv39或Sv48的多级页表结构来管理不同大小的虚拟地址空间。

RISC-V Physical Memory Protection Unit (PMP)

物理内存保护单元(PMP)是RISC-V架构中的一个可选特性,用于在硬件级别对物理内存进行访问控制,特别是在处理器的监督模式(S-mode)或用户模式(U-mode)下,这对于未受信任的操作系统和进程至关重要。PMP的主要作用是通过定义物理内存的权限,来限制访问,并防止未经授权的代码操作敏感的内存区域。

PMP的功能和特性

-

可选的新特性(v1.10):

- PMP是从RISC-V的v1.10版本引入的,作为一个可选的特性,允许系统在硬件层面上控制对物理内存的访问。

-

默认无权限:

- 在启用PMP的情况下,默认情况下,监督模式(S-mode)和用户模式(U-mode)对物理内存没有任何权限。PMP通过明确授予读、写、执行(RWX)权限来决定哪些内存区域可以被访问。

-

R/W/X权限配置:

- PMP允许为多达16个PMP区域设置读、写、执行权限,每个区域可以设置不同的权限组合。

- 这些区域是以自然对齐的2^N字节(N>=2)为单位的连续内存块,PMP使用这些内存块来定义特定的内存访问规则。

- 也可以通过相邻的PMP寄存器组合来形成基址/边界(base/bounds)的区域,以灵活设置更复杂的内存访问规则。

-

PMP可以被锁定:

- PMP区域一旦被配置,可以通过设置为“锁定”,即使是机器模式(M-mode)也无法更改,除非系统进行复位(reset)。

- 锁定机制确保了在某些关键应用场景下,重要的内存访问权限不会被意外或恶意修改。

-

虚拟内存与PMP的优先级:

- 当虚拟内存(VM)启用时,虚拟内存的页表和缺页处理会在PMP检查之前发生。这意味着如果虚拟地址映射失败或者发生缺页错误,PMP检查不会继续。

- 这种机制对于不受信任的监督模式(S-mode)特别有用,PMP可以作为额外的保护层。

使用场景

- 未受信任的S-mode:在安全敏感的场景下,PMP可以防止不受信任的操作系统(或S-mode应用)访问物理内存中的关键资源,例如固件、特权数据等。

- 嵌入式系统和安全关键系统:PMP在没有复杂虚拟内存机制的情况下,仍然提供了对物理内存的保护,特别适用于嵌入式系统、物联网设备等。

Physical Memory Attributes (PMA)

物理内存属性(PMA)是RISC-V体系结构中用于管理物理地址空间的访问属性的硬件特性。这些属性是平台和实现特定的,这意味着它们由具体的硬件平台决定,而不是RISC-V架构标准中的固定部分。PMA定义了内存访问的各种行为,如访问宽度、对齐限制、可缓存性等。

PMA的功能和特性

-

平台和实现相关:

- PMA的配置因具体平台而异。不同平台可能有不同的总线事务类型和内存访问限制。例如,在某些嵌入式系统中,特定的内存地址可能映射到外设,而在另一些平台上则可能是系统内存。

-

映射到总线事务类型或错误:

- PMA会将内存访问映射到特定的总线事务类型(例如内存读取、内存写入、设备访问等),或者返回一个错误,指示该访问是不被允许的。

-

专用硬件控制:

- PMA由专用硬件单元管理,该硬件负责将特定的物理地址范围映射到相应的访问属性。以下是一些常见的物理内存属性:

- 访问宽度:支持的访问宽度可以是1/2/4/8/16/64字节等,决定每次内存访问的最小/最大数据块大小。

- 对齐限制:可能要求内存访问不能跨越特定字节边界(例如2^N字节对齐)。

- 幂等性(Idempotency):指在启用推测执行时,允许对某些地址进行重复访问,而不会改变其结果。

- 内存访问顺序:强顺序或弱顺序控制(Strong/Weak Ordering),用于确保不同通道的内存操作顺序一致性。

- 缓存行为(Cacheability):决定特定的内存区域是否可以被缓存(包括写穿、写合并等缓存策略)。

- 优先级:当多个请求同时访问内存时,可以根据优先级控制冲突时的处理顺序。

- 原子性:定义是否允许特定类型的原子操作,如交换、逻辑操作、加法等。

- 允许的访问模式:定义不同的访问模式,如M-mode、S-mode、U-mode、调试模式等是否可以访问特定内存区域。

- PMA由专用硬件单元管理,该硬件负责将特定的物理地址范围映射到相应的访问属性。以下是一些常见的物理内存属性:

-

部分属性可配置:

- 虽然PMA的部分行为是由硬件固定的,但有些属性可以通过软件配置。这使得系统在运行时可以根据需求调整内存的访问行为。

使用场景

- 内存映射设备:PMA非常适用于嵌入式系统和SoC架构,其中一部分内存空间被映射为外设的寄存器,通过PMA可以为这些地址设置不同的访问权限和行为。

- 缓存控制:PMA允许为不同的内存区域指定缓存策略,特别是在多核处理器或需要处理外部设备的情况下,决定哪些数据应该缓存以及缓存的策略(如写回、写穿等)是非常重要的。

- 系统优化与安全:通过设置访问顺序、优先级和对齐要求,PMA可以提升系统性能,并且通过严格的访问控制可以增强安全性。

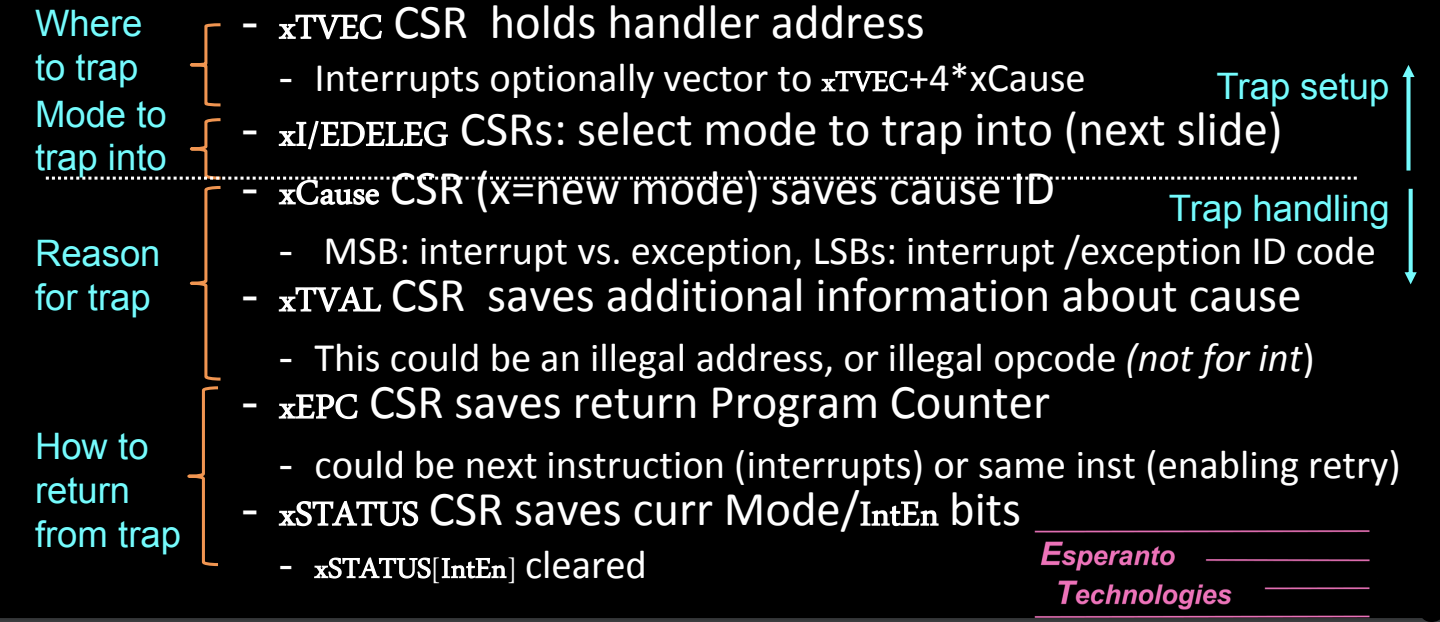

Trap Handling: Exceptions and Interrupts

可参见 Lzzs 6.S081 Notebook: Page Faults、Interrupts

在RISC-V架构中,陷阱(Trap)机制用于处理两类重要的事件:异常(Exceptions) 和 中断(Interrupts)。这两类事件的发生方式和处理机制稍有不同,但它们的处理流程在硬件层面是相似的。

异常(Exceptions)与中断(Interrupts)的区别

-

异常(Exceptions):

- 异常是同步事件,它们由具体指令的执行引发。通常,异常是在指令执行过程中检测到错误(如非法操作码、除零错误、内存访问违规等)时触发的。

- 示例:当程序试图执行一条未定义的指令时,处理器会触发一个异常并进入异常处理程序。

-

中断(Interrupts):

- 中断是异步事件,它们与当前执行的指令无关。中断通常由外部设备(如I/O设备、定时器)或者来自其他处理器核心的信号引发。

- 示例:当定时器超时时,系统会触发一个中断,处理器暂停当前执行的指令并处理定时器中断。

统一的陷阱处理流程

尽管异常和中断的触发机制不同,它们在RISC-V中通过类似的陷阱机制来处理。

- 陷阱处理的基本流程:

-

xTVEC CSR:保存陷阱处理程序的入口地址。无论是异常还是中断,处理器都会根据xTVEC的值跳转到相应的处理程序。

- 中断可以根据xCause的值选择一个可选的偏移量,通过

xTVEC + 4 * xCause来跳转到不同的处理程序。

- 中断可以根据xCause的值选择一个可选的偏移量,通过

-

xI/DELEG CSR:用于选择陷阱处理的模式。这个寄存器决定了发生的异常或中断应该陷入哪个特权模式。例如,操作系统可以配置某些中断直接由用户模式处理,而无需进入内核模式。

-

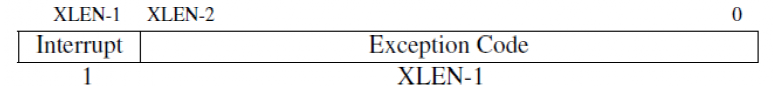

xCause CSR:保存引发陷阱的原因。

- 高位(MSB)用于区分这是中断还是异常。

- 低位(LSB)保存具体的中断或异常编号,标识是什么原因引发的陷阱。

-

xTVAL CSR:保存额外的关于陷阱的信息,例如非法地址或非法操作码的值。对于某些异常(如非法内存访问),xTVAL可以保存发生错误的虚拟地址。

-

xEPC CSR:保存导致陷阱的指令的程序计数器(PC)值。陷阱处理程序完成后,处理器将从xEPC中存储的PC地址继续执行,可能是中断处理后的下一条指令,或者重试之前的指令(异常处理)。

-

xSTATUS CSR:保存处理器的当前状态,包括当前模式(用户、监督或机器模式)以及中断使能位。处理器在进入陷阱处理程序时会自动保存这些状态,以便在处理完成后正确返回。

- 当陷阱处理完成时,

xSTATUS[IntEn]位会被清除,确保处理器在恢复时不会发生竞态条件。

- 当陷阱处理完成时,

-

更详细的陷阱处理机制

-

陷阱处理的位置(Where to trap):

- 处理器会根据xTVEC CSR的值找到陷阱处理程序的入口地址。处理器可能跳转到一个固定的处理程序地址,也可能根据不同的原因(xCause)偏移跳转到不同的处理程序。

-

陷阱的处理模式(Mode to trap into):

- 不同的中断或异常可以配置为陷入不同的特权模式(如U-mode、S-mode、M-mode)。这些模式的选择由xI/DELEG寄存器决定,操作系统可以根据需要配置哪些陷阱直接进入用户模式处理,哪些需要更高权限的模式来处理。

-

陷阱原因(Reason for trap):

- 处理器会在xCause CSR中保存引发陷阱的具体原因。这一原因可能是中断(如外部设备中断)或者异常(如非法指令)。xCause还用于区分不同的中断或异常源,以便跳转到不同的处理程序。

-

返回机制(How to return from trap):

- 在陷阱处理完成后,处理器会从xEPC CSR保存的程序计数器继续执行之前被中断的程序。xEPC保存的是引发陷阱的指令地址,而处理器可以通过恢复xSTATUS CSR的状态确保正确的执行模式和中断状态恢复。

异常与中断的处理细节

-

异常的处理:通常是由于指令执行过程中产生的同步错误。处理器会将异常处理程序的入口保存在xTVEC中,并在处理完后根据xEPC返回到同一指令或执行下一条指令。

-

中断的处理:由于中断是异步事件,处理器可以在处理完中断后从xEPC中保存的地址继续执行后续指令。常见的中断包括定时器中断、外设中断或多处理器间的中断(如IPI)。

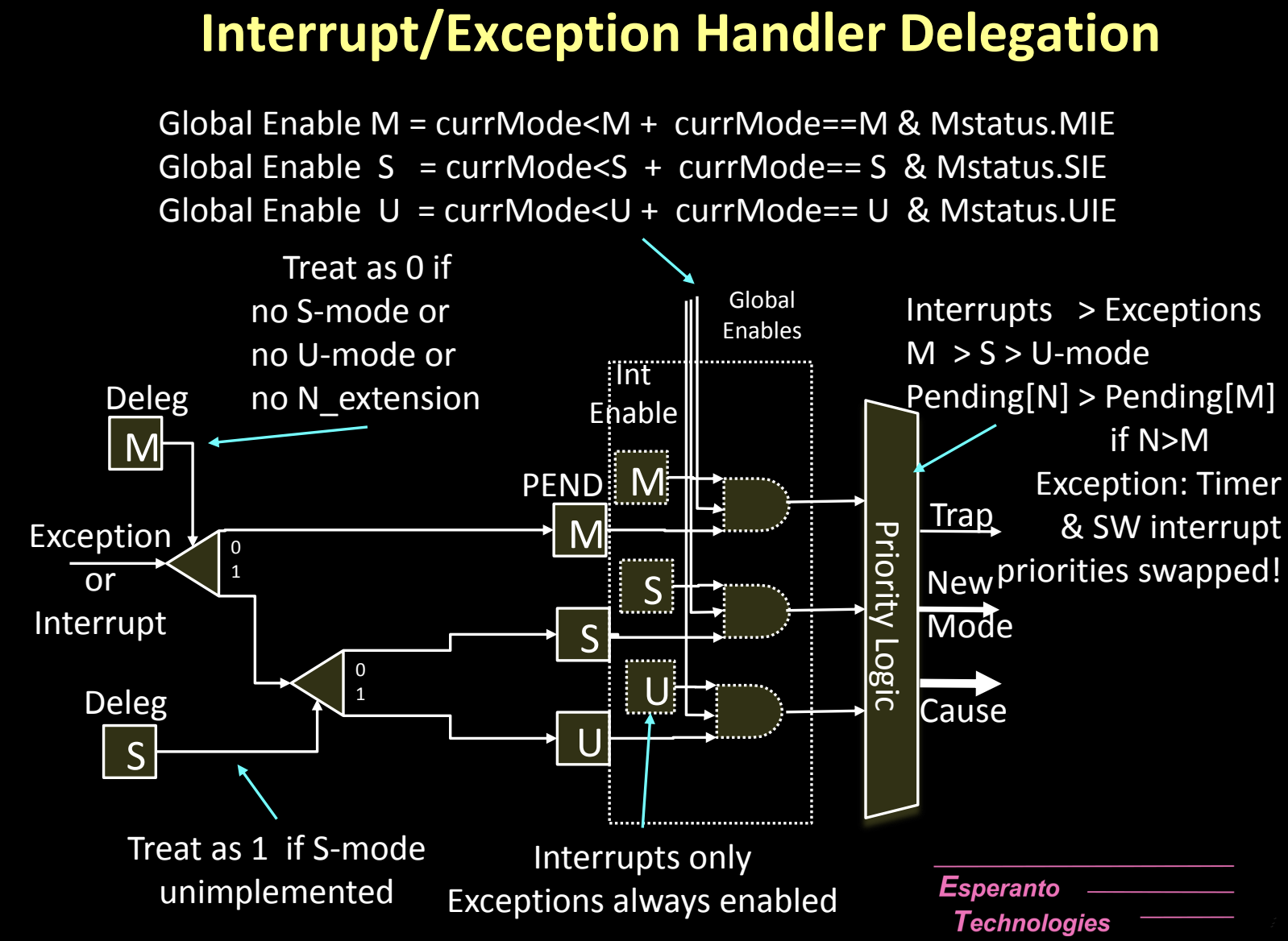

Trap Setup: Interrupt/Exception Handler Delegation

在RISC-V架构中,陷阱(Trap)通常默认发送到机器模式(M-mode),但为了提高处理效率,某些中断和异常可以被委派到较低的特权模式(如S-mode或U-mode)进行处理。陷阱委派机制允许操作系统根据需求减少开销,同时确保系统的安全性和特权隔离。

委派机制(Delegation Mechanism)

-

默认发送到M-mode:

- 在RISC-V架构中,所有的中断和异常默认都会被处理器发送到最高权限的M-mode。这是因为M-mode拥有对系统的完全控制,负责处理所有的低级硬件事件。

-

委派到低权限模式:

- 虽然陷阱默认被发送到M-mode,但可以通过设置委派寄存器将某些中断和异常委派到较低的特权模式(如S-mode或U-mode)。

- 不能将陷阱委派到比触发陷阱的模式权限更低的模式。例如,M-mode的异常可以委派到S-mode,但不能委派到U-mode(除非没有S-mode)。

-

委派寄存器:

- mideleg 和 medeleg:这些寄存器控制从M-mode到S-mode的中断和异常的委派。如果没有S-mode(如在嵌入式系统中),可以将陷阱直接委派到U-mode。

- sideleg 和 sedeleg:在存在S-mode的情况下,这些寄存器用于将中断和异常委派给U-mode,前提是系统启用了N扩展。

-

中断的启用:

- 中断的委派只有在对应的启用位(如mie或sie)被设置时才会发生。启用位用于控制中断是否允许处理。

- 注意:异常总是被启用并处理,无需像中断那样设置启用位。

-

陷入模式的选择:

- 委派发生时,中断或异常将被发送到下一级权限模式(M→S,或者S→U)。这可以减轻M-mode的负担,允许低权限模式处理与其相关的事件,例如用户程序引发的异常可以直接在U-mode处理,而不需要进入S-mode。

-

中断设置CSR位:

- 当中断或异常发生时,相应的位会在xE/IP CSR(如mip、sip)中被设置,指示当前的中断/异常状态。

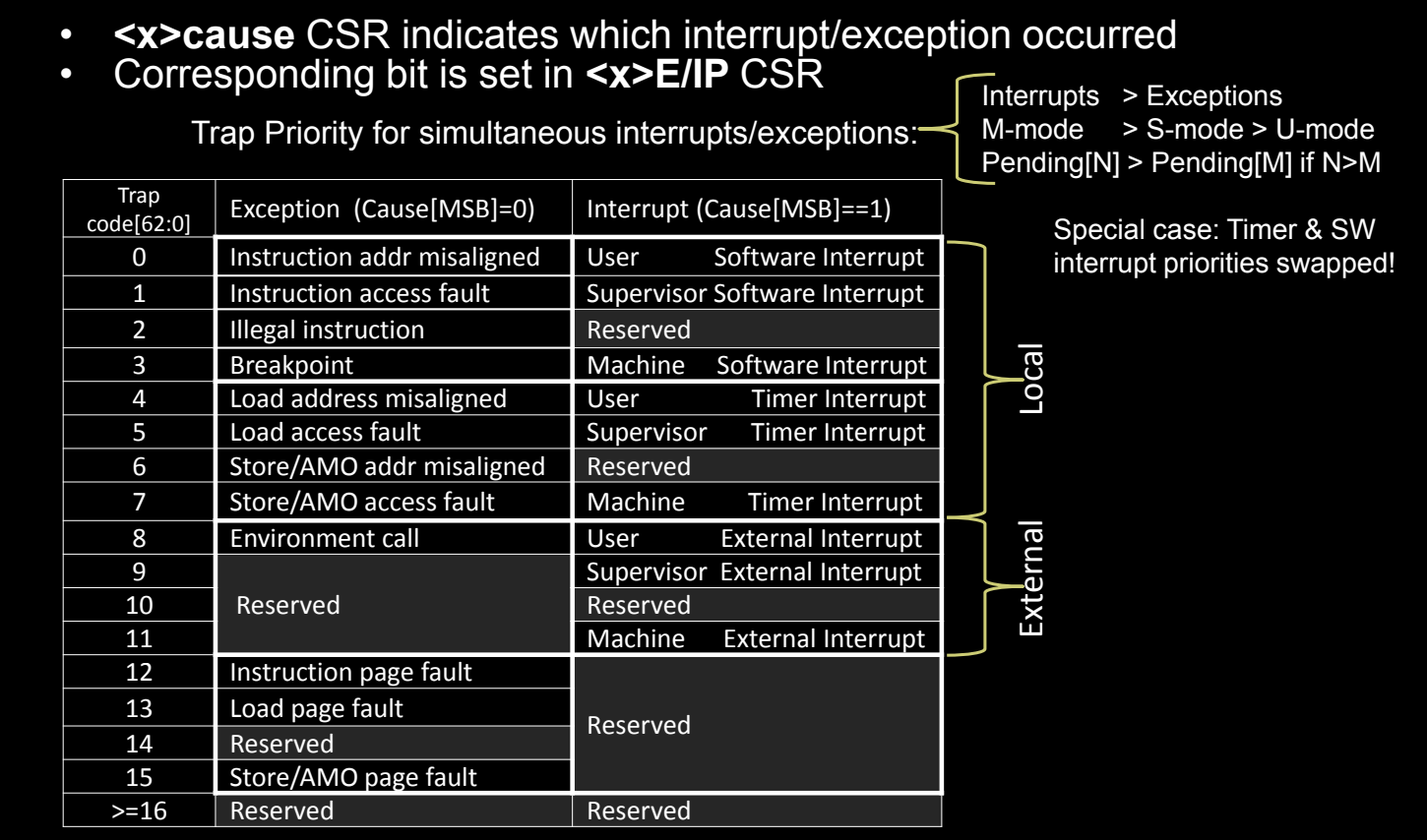

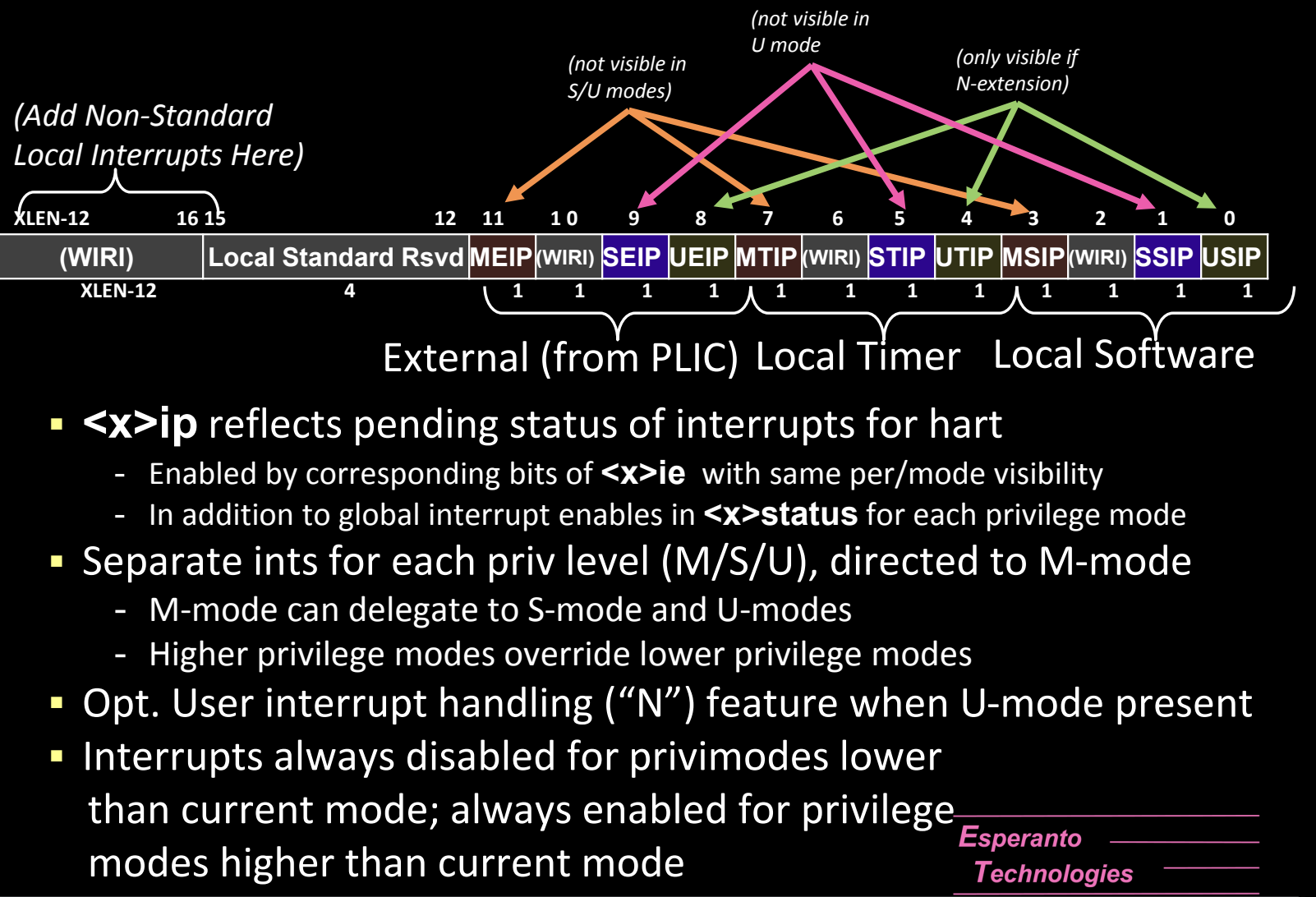

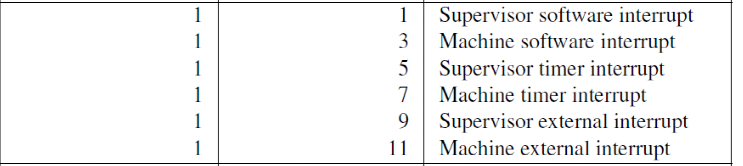

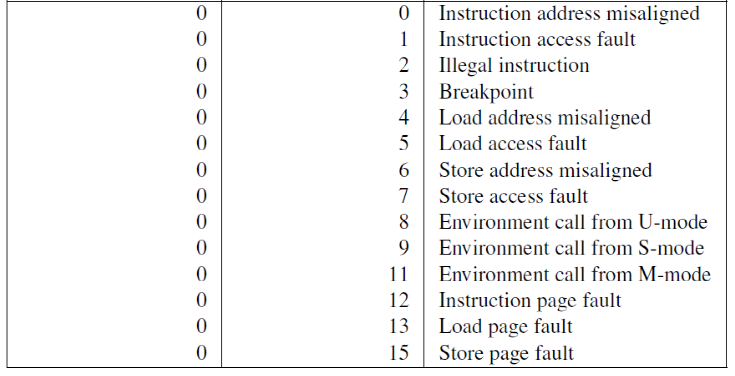

Trap Handling: Interrupt/Exception Causes

在RISC-V中,每个中断和异常的原因都存储在xCause CSR中,该寄存器会指示当前发生的中断或异常的类型,便于操作系统采取相应的处理。

xCause CSR 及其功能

-

原因指示:

- xCause CSR 保存了中断或异常发生的具体原因。通过该寄存器,操作系统可以知道是哪种类型的事件引发了陷阱,并根据事件类型选择合适的处理方式。

- 最高位(MSB)用于区分是中断(1)还是异常(0),而低位(LSB)则保存了具体的中断或异常代码。

-

xE/IP CSR 中的位设置:

- 当一个中断或异常被触发时,对应的位会在xE/IP CSR(如mip、sip)中设置。这个寄存器记录了当前系统中待处理的中断或异常事件,并为系统提供了事件的优先级队列。

-

同时发生的中断/异常的优先级:

- RISC-V为同时发生的多个中断和异常设置了优先级规则:

- 中断优先于异常:当中断和异常同时发生时,处理器优先处理中断。

- M-mode > S-mode > U-mode:机器模式的中断和异常优先级最高,其次是监督模式,最后是用户模式。

- Pending[N] > Pending[M] if N > M:较高优先级的中断(如外部中断)优先于较低优先级的中断。

- RISC-V为同时发生的多个中断和异常设置了优先级规则:

-

特殊情况:定时器和软件中断:

- 在某些特定情况下(如定时器中断和软件中断),优先级可能会被交换,以确保系统的定时和内部同步机制不被外部设备的中断打断。

中断与异常的原因代码(Trap Code)

| Trap Code | 异常(Cause[MSB] == 0) | 中断(Cause[MSB] == 1) |

|---|---|---|

| 0 | 指令地址未对齐 | 用户软件中断 |

| 1 | 指令访问故障 | 监督软件中断 |

| 2 | 非法指令 | 保留 |

| 3 | 断点 | 机器软件中断 |

| 4 | 加载地址未对齐 | 用户定时器中断 |

| 5 | 加载访问故障 | 监督定时器中断 |

| 6 | 存储/AMO地址未对齐 | 保留 |

| 7 | 存储/AMO访问故障 | 机器定时器中断 |

| 8 | 环境调用(用户模式) | 用户外部中断 |

| 9 | 保留 | 监督外部中断 |

| 10 | 保留 | 保留 |

| 11 | 环境调用(机器模式) | 机器外部中断 |

| 12 | 指令页错误 | 保留 |

| 13 | 加载页错误 | 保留 |

| 14 | 存储/AMO页错误 | 保留 |

| >= 16 | 保留 | 保留 |

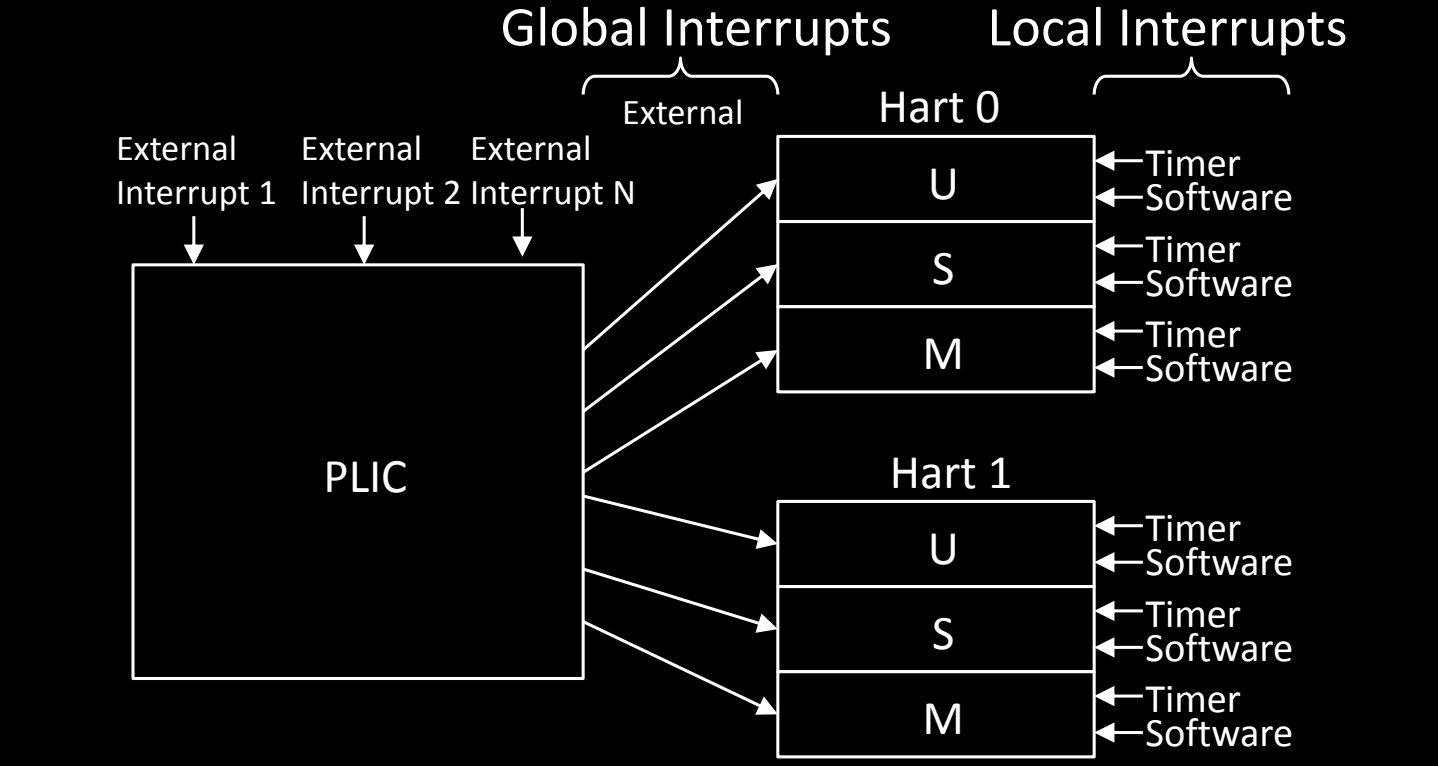

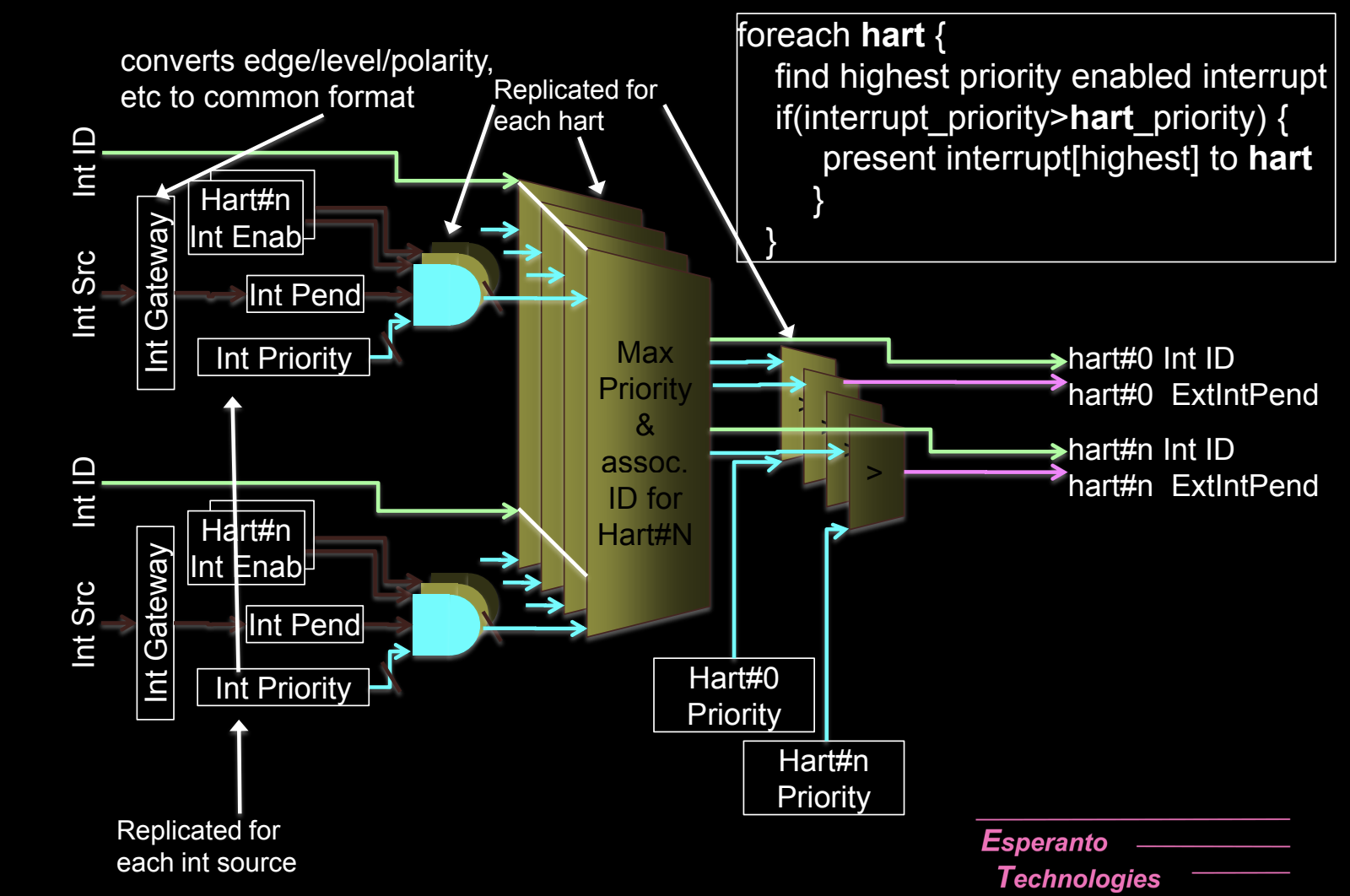

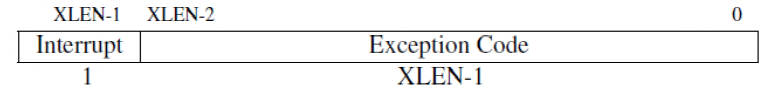

Interrupt

Platform-Level Interrupt Overview

在RISC-V架构中,中断系统分为全局中断(Global Interrupts)和本地中断(Local Interrupts)。这些中断管理的核心是平台级中断控制器(PLIC),它负责处理和调度外部设备发出的中断信号,并将其分发给系统中的各个硬件线程(harts)。本地中断则直接在每个hart内处理,与定时器和软件中断紧密相关。

全局中断(Global Interrupts)

-

外部中断(External Interrupts):

- 全局中断由平台上的外部设备发起,例如外部I/O设备、网络接口或存储设备。这些中断通过PLIC传递给每个hart。

- PLIC(Platform-Level Interrupt Controller)是RISC-V系统中处理外部中断的核心模块。它接收来自多个外部设备的中断请求,根据中断的优先级和配置决定哪个hart来处理中断。

- 通过PLIC,每个外部中断被分配给不同的hart(硬件线程),这些中断可以在不同的特权模式(U-mode、S-mode、M-mode)下进行处理。

-

PLIC的工作机制:

- 中断分发:PLIC接收到外部设备的中断信号后,根据中断的优先级和目标hart,将中断传递到合适的hart。

- 优先级处理:每个外部中断可以被分配不同的优先级,PLIC会根据优先级的高低决定哪个中断优先处理。

- 中断路由:PLIC负责将外部中断路由到指定的hart和特权模式(U、S、M)。

本地中断(Local Interrupts)

本地中断是与每个hart直接相关的中断,通常涉及到定时器和软件中断。这类中断只影响对应的hart,并不需要通过PLIC进行分发。

-

定时器中断(Timer Interrupts):

- 定时器中断是由处理器内部的定时器触发的,用于操作系统的时钟管理或任务调度。这些定时器中断直接分发到对应的hart,不经过PLIC。

- 每个hart都有自己独立的定时器,这意味着多个hart可以同时处理各自的定时器中断。

-

软件中断(Software Interrupts):

- 软件中断通常用于多hart(多核)系统中,hart之间的通信。操作系统可以触发软件中断来通知其他hart执行特定的任务(如任务切换、进程调度等)。

- 软件中断通过操作系统触发,作用于指定的hart,并由其直接处理。

每个hart的中断处理

每个hart(硬件线程)有自己独立的中断处理机制,并且可以根据特权模式(M-mode、S-mode、U-mode)处理不同级别的中断。每个模式都有自己对应的定时器中断和软件中断。

- M-mode中断处理:M-mode拥有最高优先级的中断处理权力,负责管理最底层的硬件和外部设备的中断。

- S-mode中断处理:S-mode通常用于操作系统内核,用来处理用户进程的调度、虚拟内存管理和设备管理。

- U-mode中断处理:U-mode的中断通常由用户态程序触发,用于软件中断或用户应用程序的定时器管理。

RISC-V Interrupt Source Categories

RISC-V的中断源分为两大类:全局(外部)中断和本地中断。每种中断类型在处理方式和目标硬件上有所不同,并通过特定的机制来分发和处理。

全局(外部)中断

- 路由到hart:全局中断通常来自平台上的外部设备,这些中断由**平台级中断控制器(PLIC)**负责管理。PLIC根据每个hart的中断阈值和优先级,决定将中断路由到哪个hart进行处理。

- 确定中断源:中断源可以通过读取PLIC的MMIO(内存映射I/O)CSR来确定。PLIC负责接收多个外部设备的中断,并根据配置的优先级处理它们。

本地中断

-

本地中断与单个hart相关:本地中断直接连接到每个hart,独立于其他harts。它们不通过PLIC,而是由每个hart自己处理。RISC-V定义了两种标准的本地中断类型:

- 软件中断:通常用于hart之间的通信,或由操作系统触发,用于多核系统中的任务调度。

- 定时器中断:由定时器触发,用于时间管理或操作系统的时钟调度。

-

通过xCause CSR确定中断原因:本地中断的原因可以直接从xCause CSR中读取。每个hart在接收到本地中断后,可以通过这个寄存器查看具体的中断类型,并进行相应的处理。

任意中断可用于任意模式(M/S/U)

- 中断可指向任何特权模式:无论是全局中断还是本地中断,都可以根据需要分发到任何特权模式(M-mode、S-mode、U-mode)。例如,某些中断可以直接由用户态程序处理,而不需要进入内核模式。

- 同时发生中断时优先级决定处理顺序:当同时发生多个中断时,系统会根据特权模式和中断优先级来决定处理顺序。处理器会首先处理优先级更高的中断。

External Interrupts

外部中断是由系统中的外部设备触发的中断,例如I/O设备、外设或其他硬件模块。这些中断通过PLIC进行管理和分发。

外部中断的工作机制

-

PLIC管理外部中断输入:

- **平台级中断控制器(PLIC)**接收外部设备的中断请求,并将这些中断分发到合适的hart。PLIC根据hart的中断阈值、中断启用状态以及中断优先级来决定哪些hart处理中断。

-

多hart的中断目标:

- PLIC可以将同一个外部中断同时发送到多个hart。在这种情况下,多个hart需要通过仲裁机制来决定哪个hart处理该中断。

- 仲裁机制:例如,多个hart可以竞争读取映射到PLIC的MMIO寄存器,第一个读取到中断源的hart将负责处理该中断。

-

PLIC的特权模式标签:

- PLIC可以根据中断的来源和配置,为每个中断输出标记一个特权模式(M/S/U),这允许不同的特权模式处理不同的中断。例如,某些低优先级的外部设备中断可以由用户模式(U-mode)处理,而高优先级中断则交由机器模式(M-mode)处理。

-

清除外部中断:

- 外部中断通过MMIO映射的LD(加载)/ST(存储)操作发送到PLIC后,可以通过写入相应的寄存器来清除中断。处理完中断后,操作系统或硬件会通过这种方式通知PLIC,表示中断已完成处理。

-

软件注入中断:

- 软件可以直接通过设置SEIP和UEIP中断位来支持PLIC虚拟化。这允许通过软件控制来模拟外部中断,通常用于操作系统的虚拟化环境中,在这种情况下,软件层面可以直接注入中断信号而无需实际硬件设备的中断触发。

Software Interrupts

软件中断是RISC-V架构中hart之间相互中断的机制,通常用于多核处理器中的核间中断(IPI,Inter-Processor Interrupts)。这种机制允许一个hart触发另一个hart的中断,以实现核间的同步或调度。

软件中断的工作机制

-

hart间通信: